Key Takeaways

The performance war is over, and composability across VMs is the next frontier.

Fluent’s Blended Execution puts EVM, SVM, and Wasm on one chain with no bridges.

A good chain isn’t enough, so Fluent is building Prints, its own reputation layer, to prove it.

1. The Battle After Performance

Blockchain infrastructure competition began with performance: faster, cheaper, higher throughput. That race is now effectively over. Dozens of chains exist, and performance is sufficient for all but the most extreme financial services.

Looking back, blockchain’s biggest breakthroughs came not from performance but from composability. DeFi Summer 2020 is the clearest example. Lending was layered with swaps, then yield farming stacked on top.

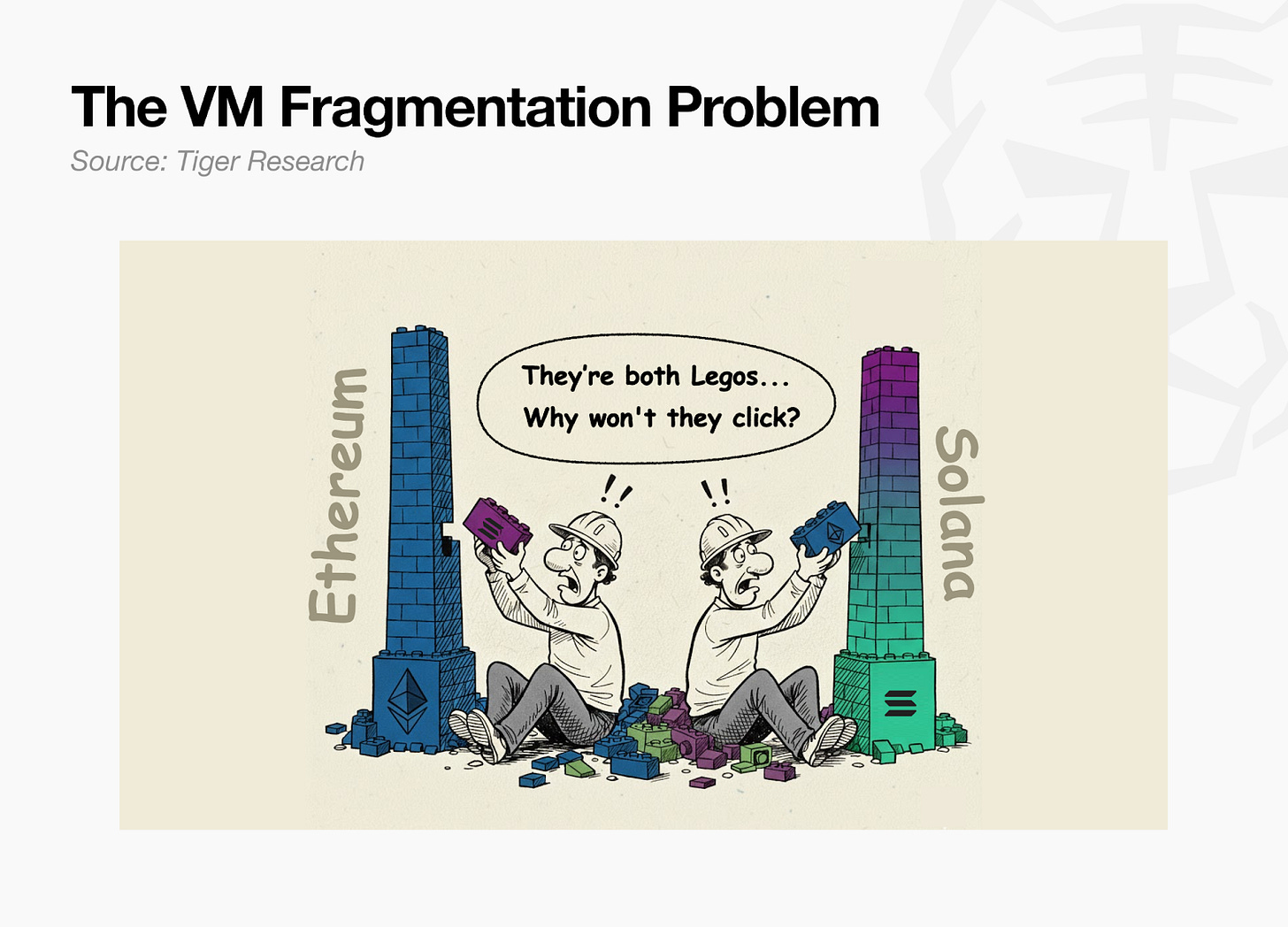

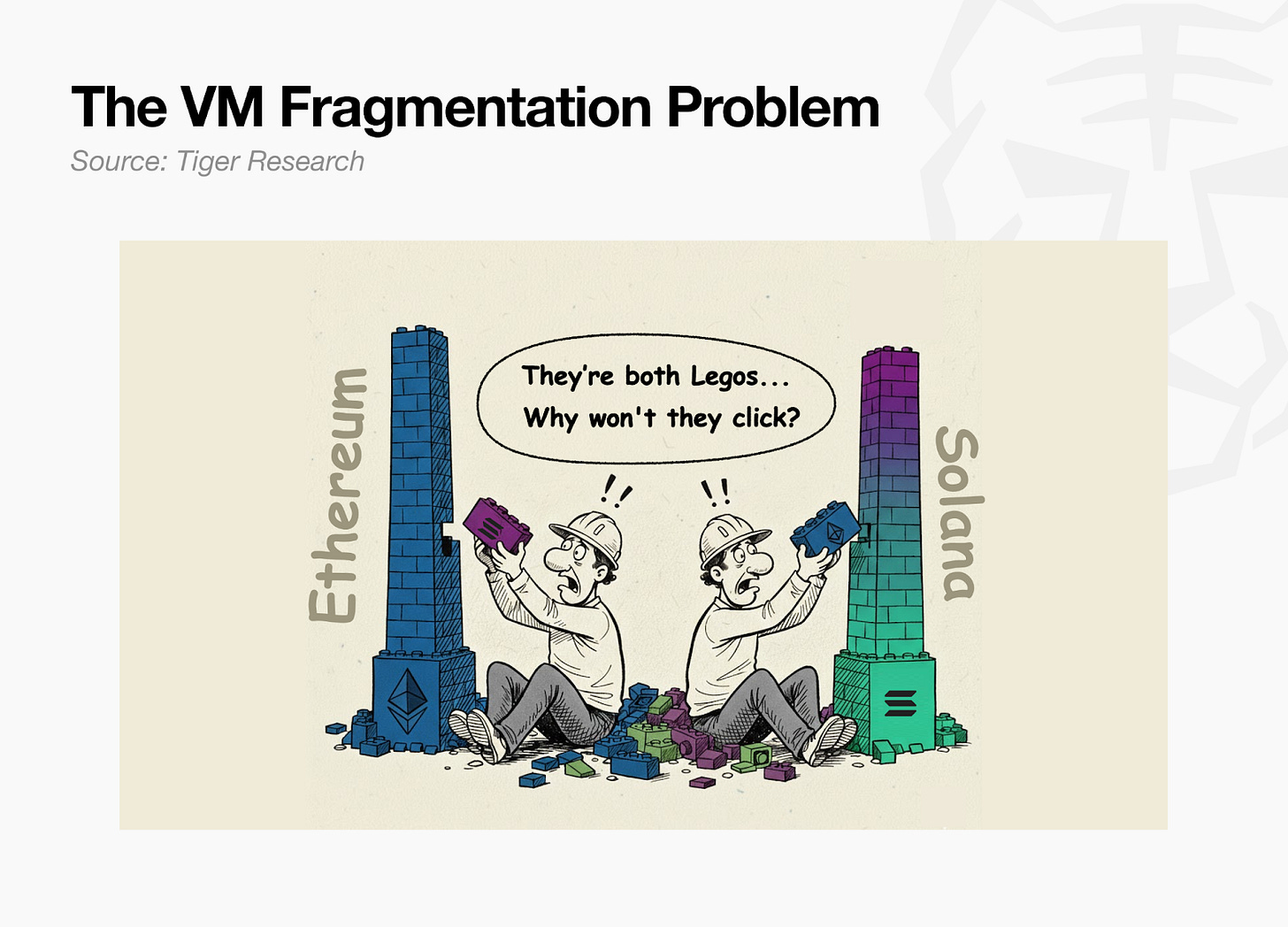

The key insight was that apps could snap together like Lego.

But this composability only worked within a single VM. Ethereum’s Lego blocks could not be used on Solana, and Solana’s could not be used on Ethereum. This VM fragmentation is the constraint Fluent is explicitly designed to remove.

2. The Lego Fluent Dreams Of

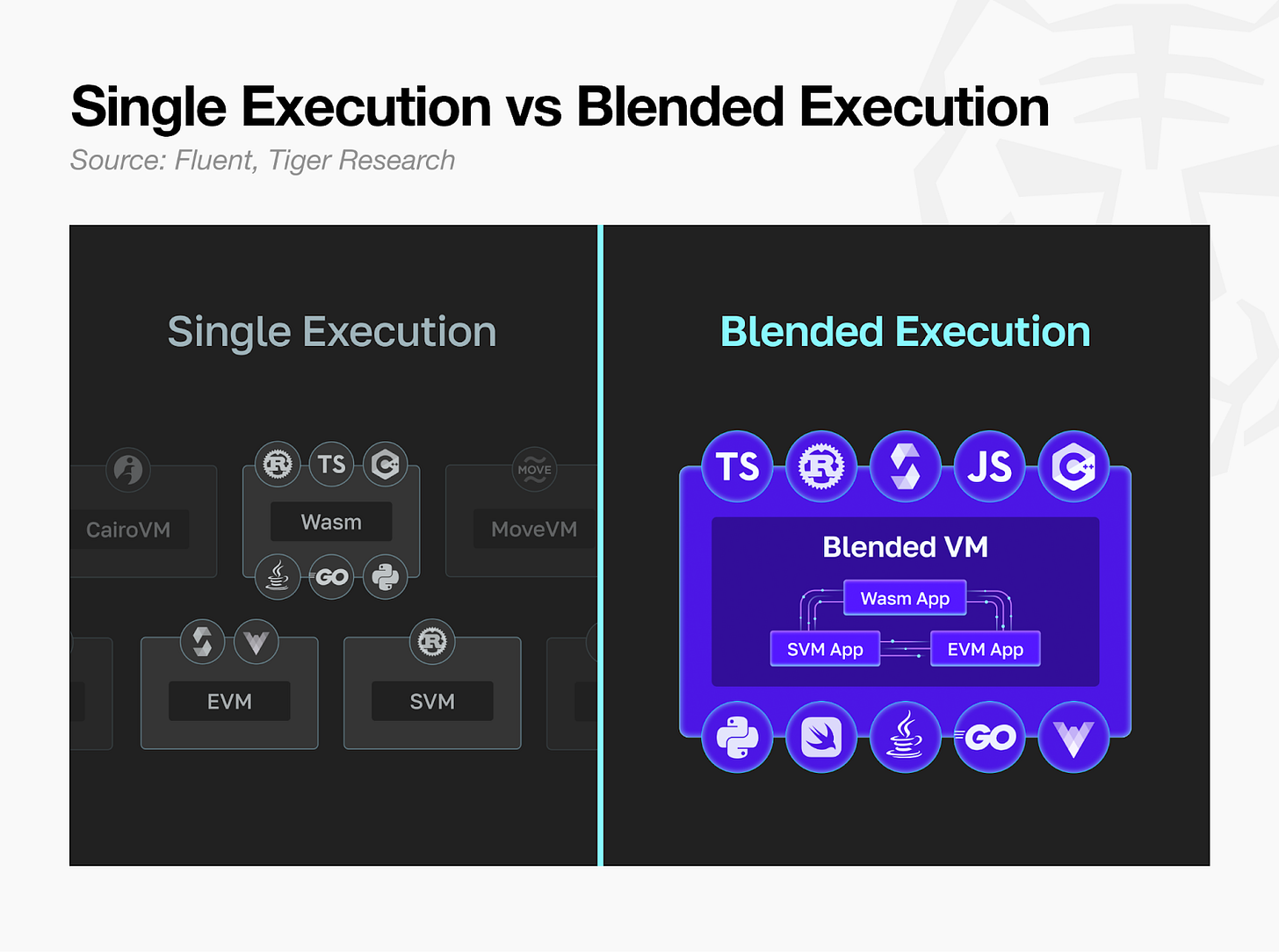

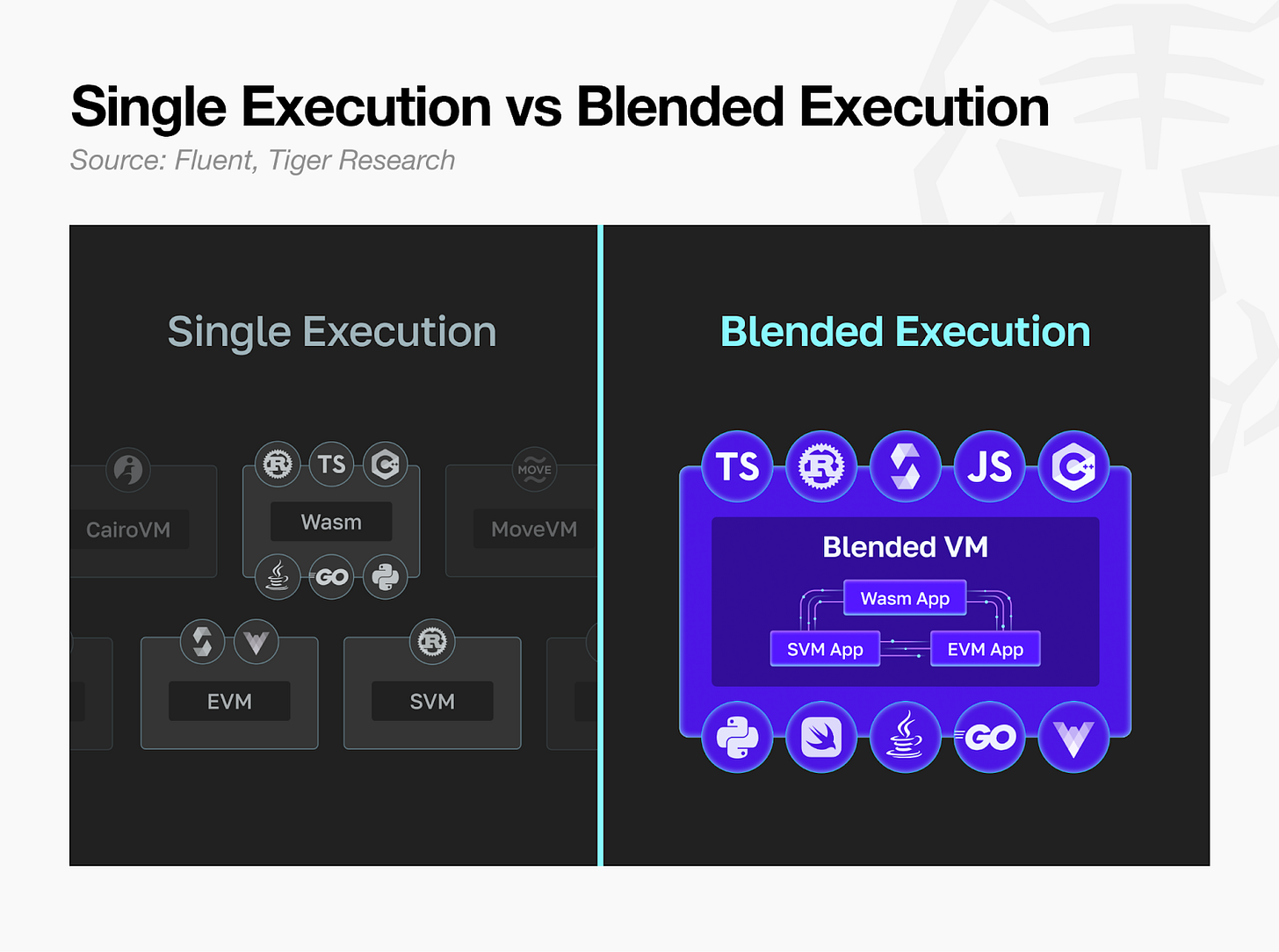

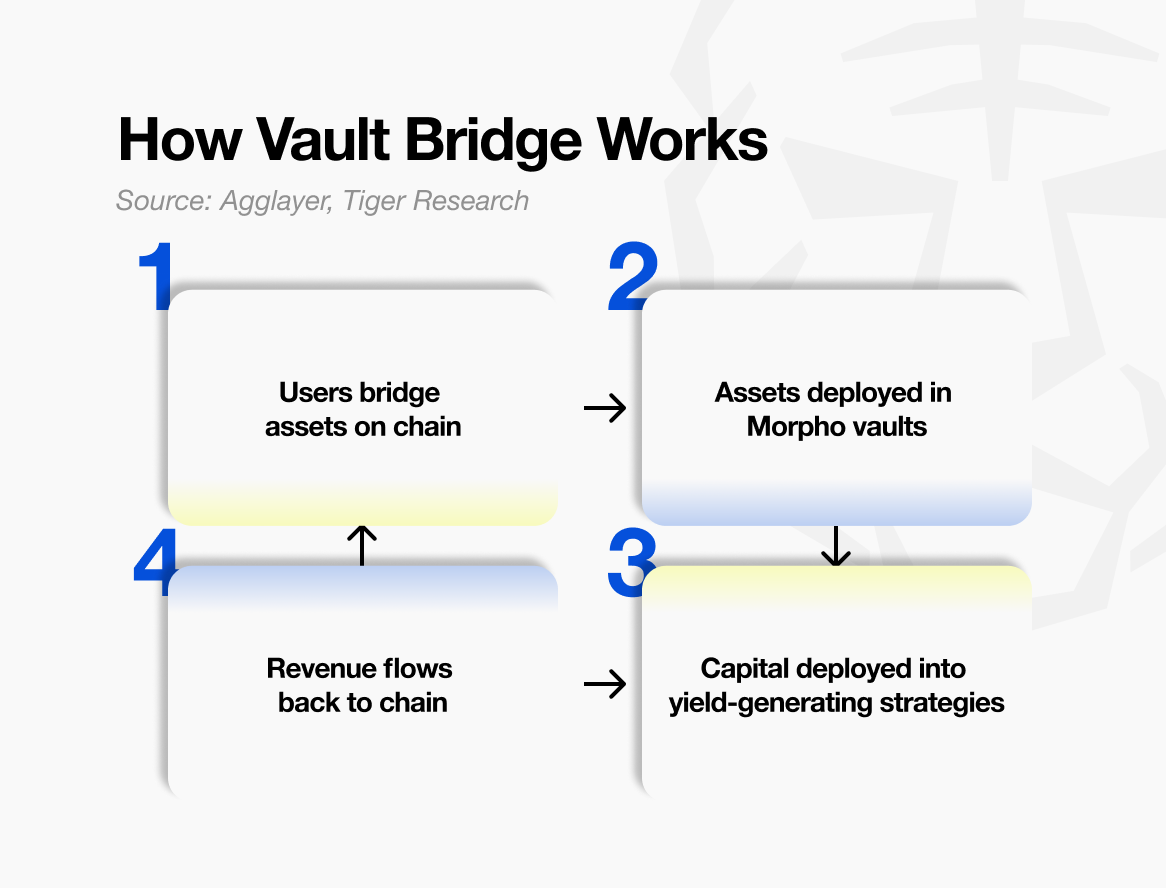

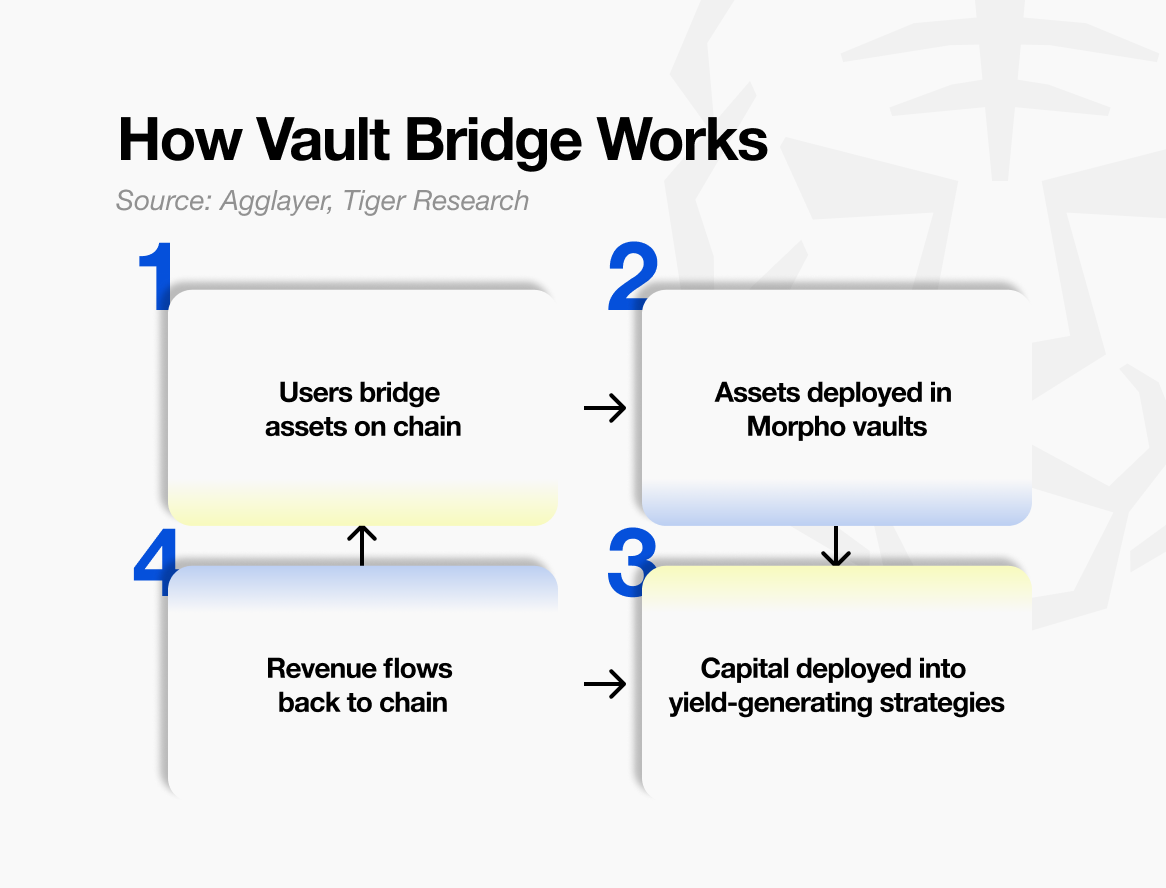

Fluent is a project designed to eliminate the boundary between VMs. Its approach is called “Blended Execution”, running apps from different VMs together within a single chain.

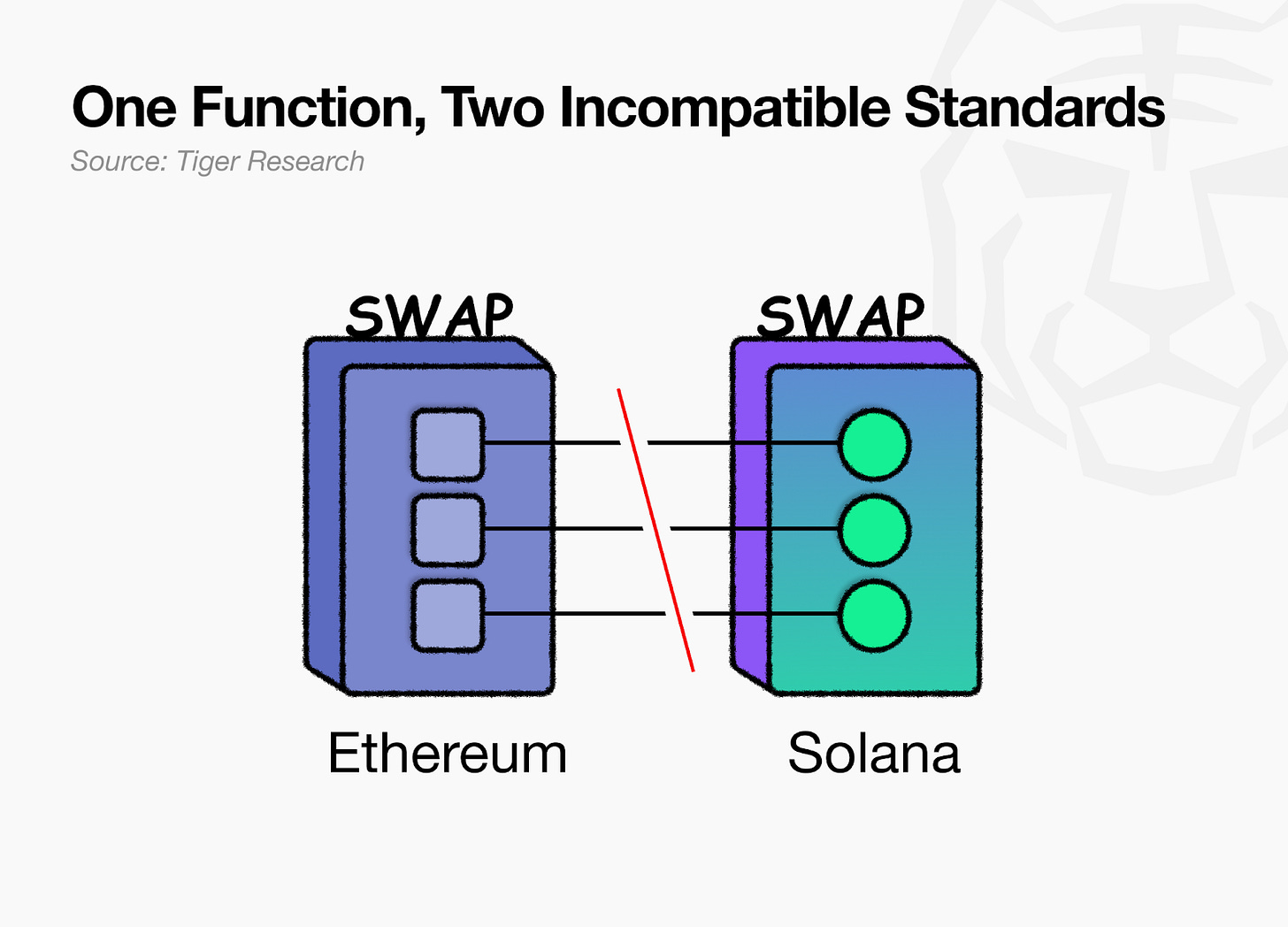

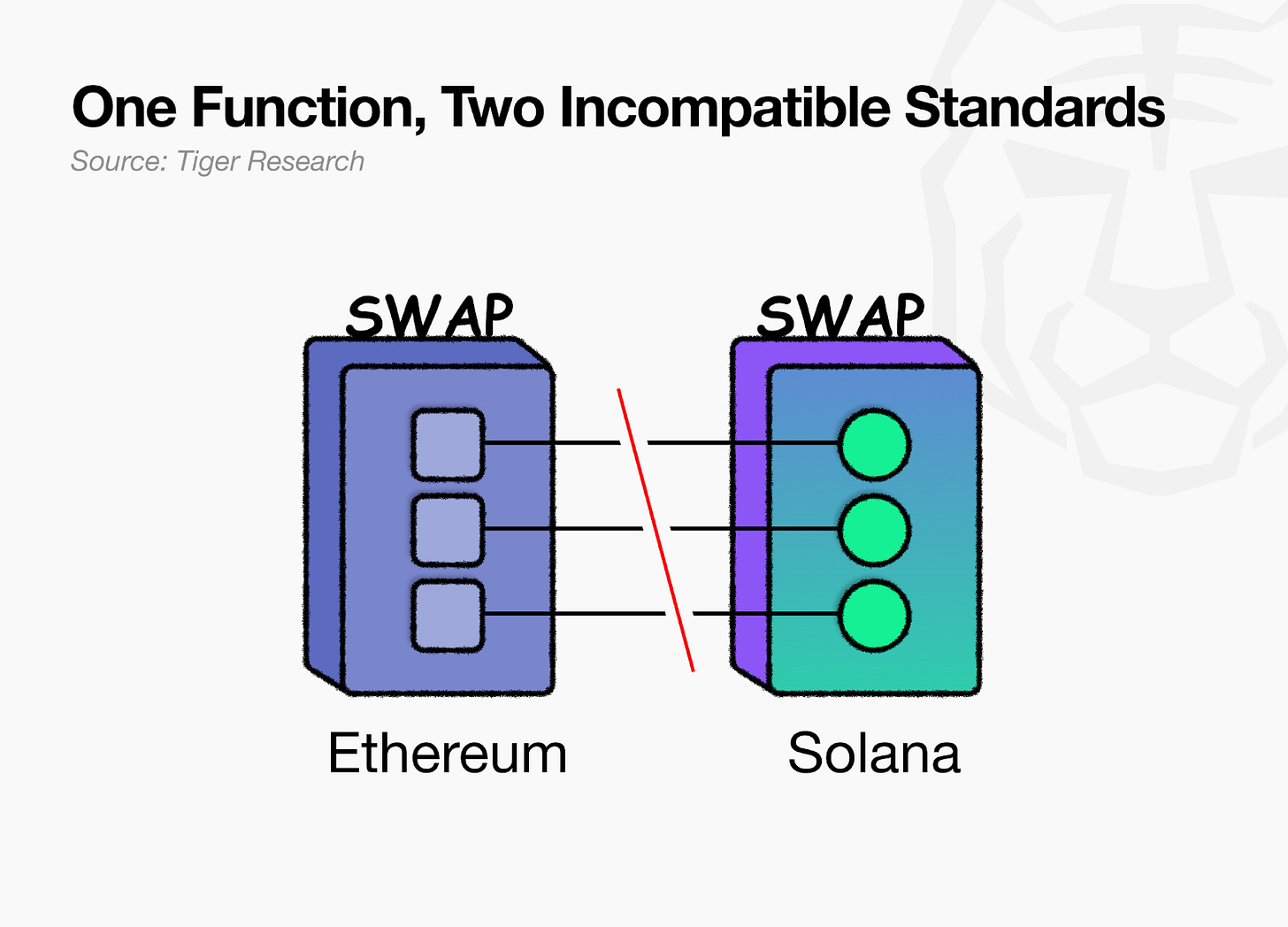

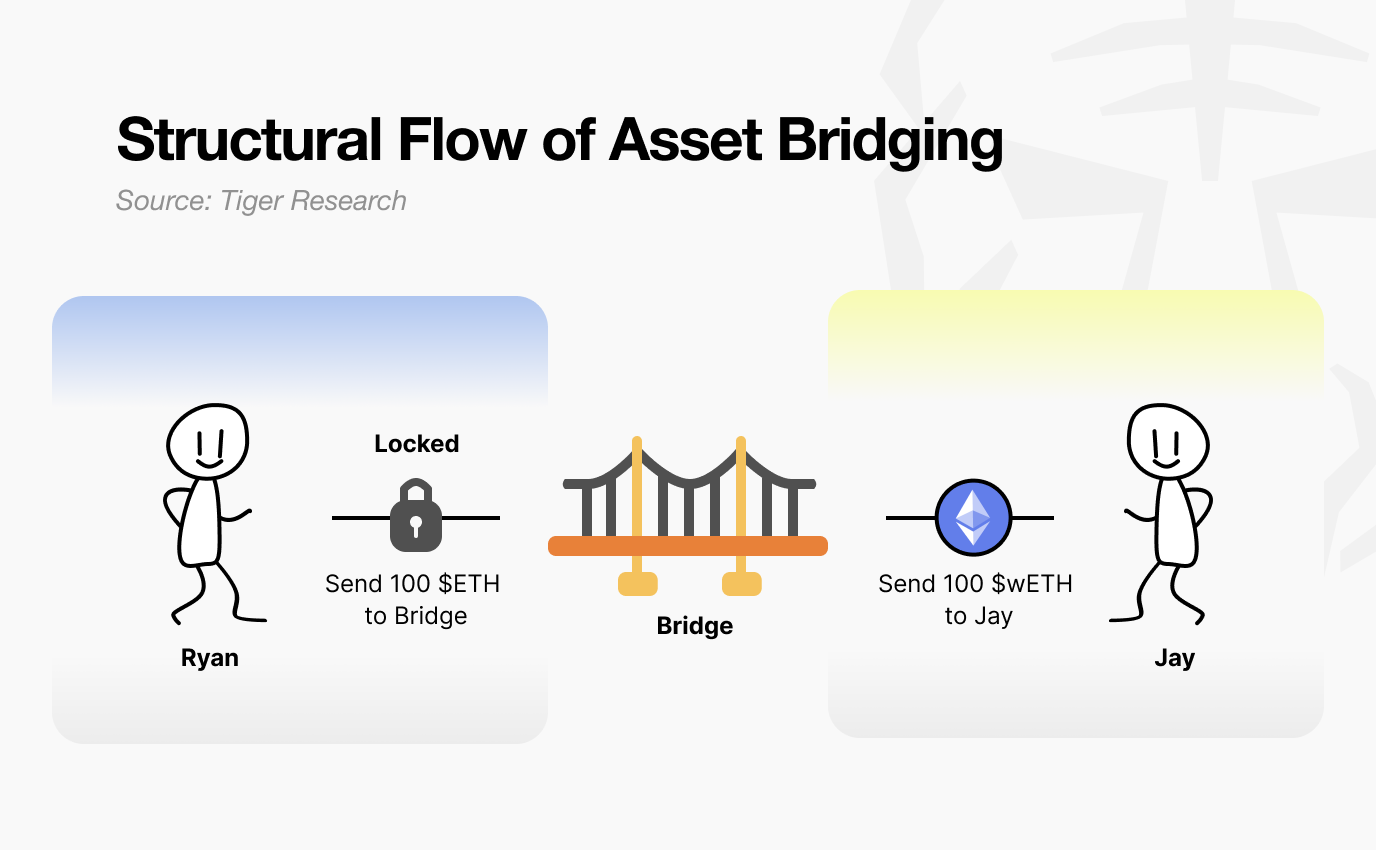

To illustrate the current situation with the Lego analog. Ethereum Lego blocks are square, and Solana Lego blocks are round. Both are good blocks, but their specs are incompatible. Even if you want to combine a lending app built on Ethereum with a trading app built on Solana, they sit in separate boxes and cannot connect.

Fluent is the board that unifies these specs. As an Ethereum L2, it inherits Ethereum’s security while building a new execution environment on top. Architecturally, Fluent resembles other Ethereum L2s like Arbitrum or Base, until execution begins.

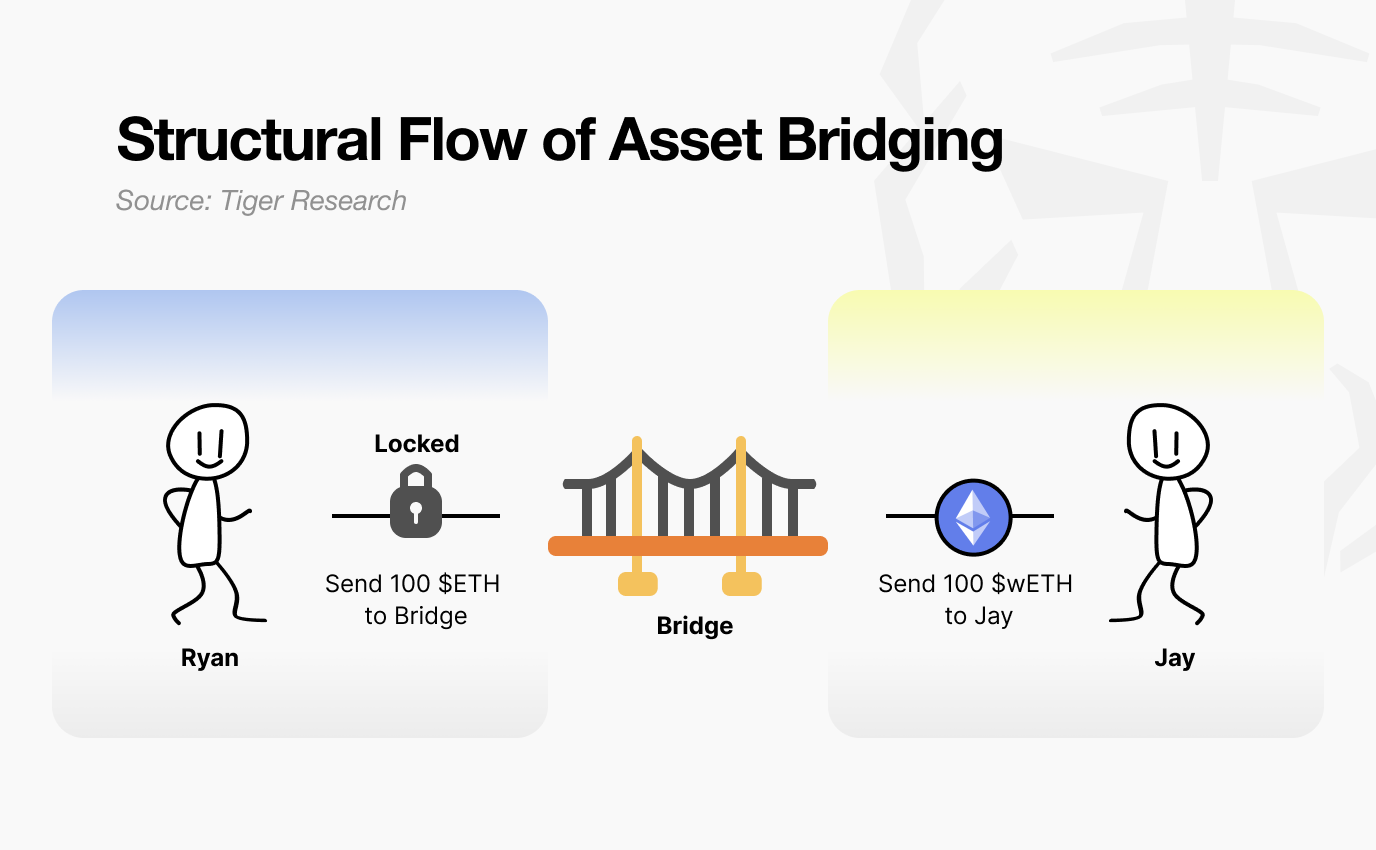

The difference is one thing. Inside Fluent, contracts written for EVM, SVM, and Wasm all live on the same chain, sharing the same state. Wasm (WebAssembly) was originally created to run high-performance programs in web browsers. It converts code written in various languages (Rust, C++, TypeScript, etc.) into a single common format.

Fluent uses Wasm to compile all contracts into a shared format called rWasm (reduced Wasm). Whether a block is square or round, it gets converted to the same spec, so everything can be freely combined on one board.

This means a Solidity app can directly call a function in a Rust app. No bridge, no message relay. It all executes within a single transaction. Fluent calls this “Blended Execution.”

Currently, blended execution between EVM and Wasm is live on testnet. SVM support has completed feature development and is in the optimization phase.

3. Proving It with Prints

BUT, does building a good chain automatically attract good apps?

In reality, NO.

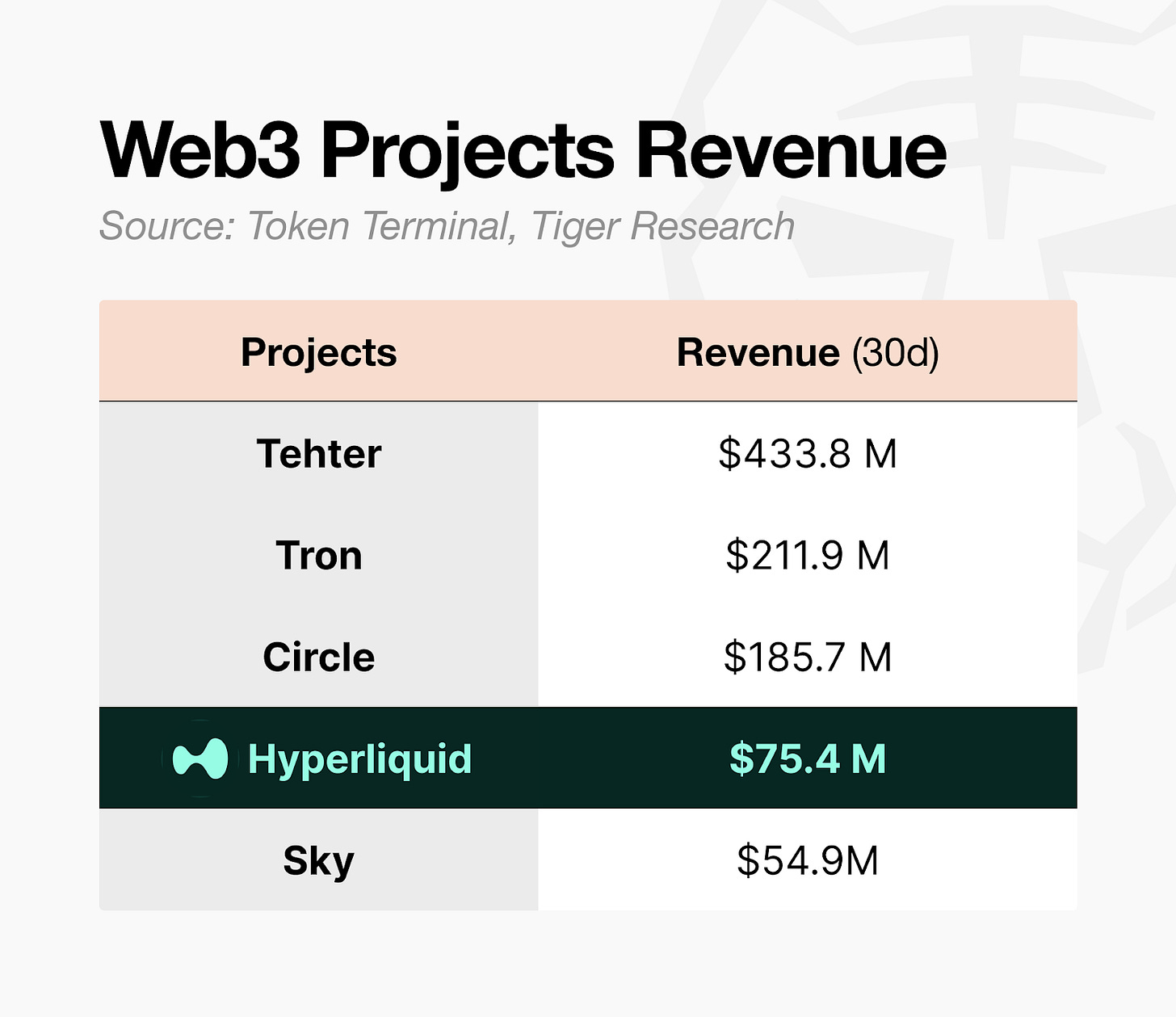

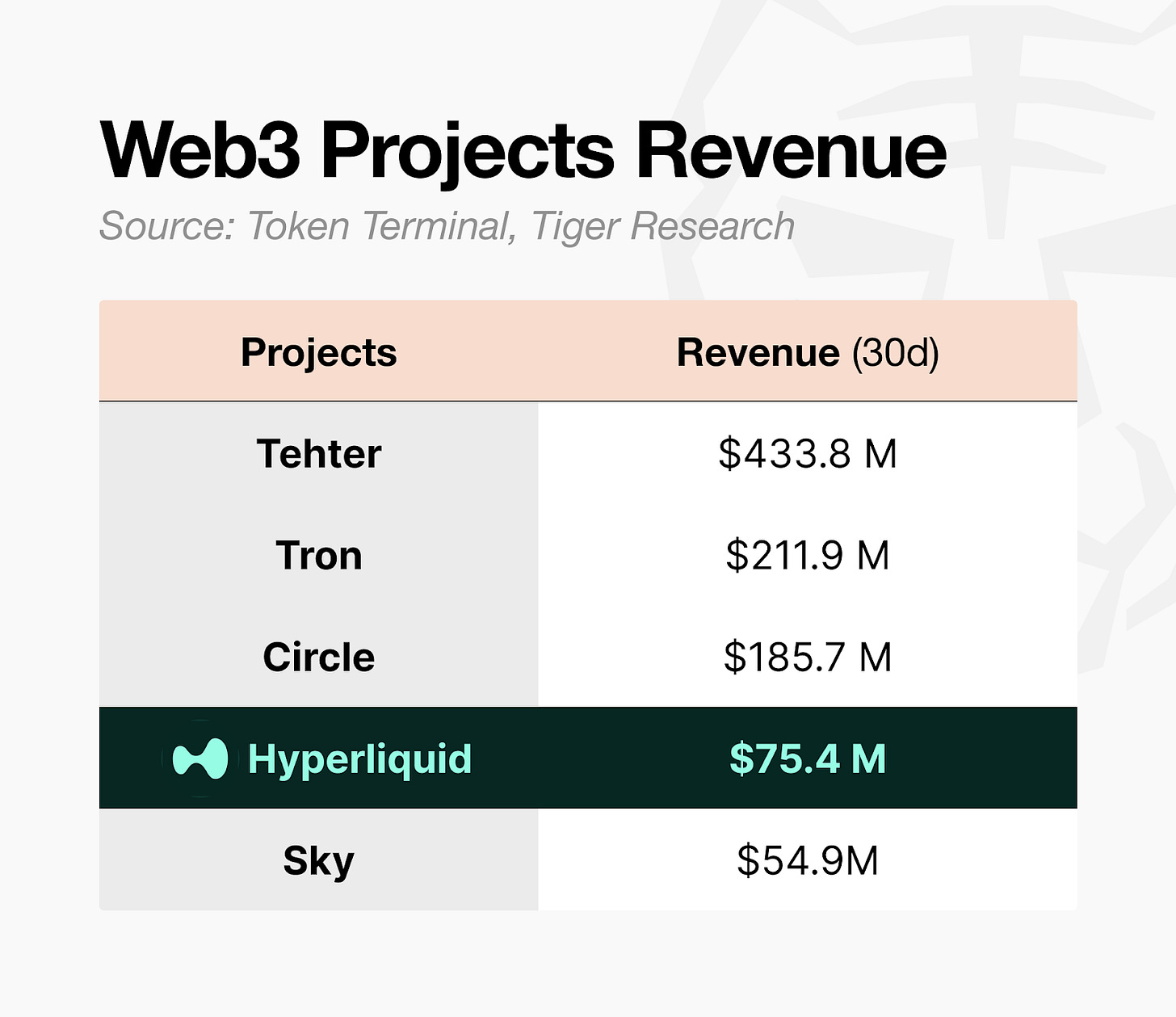

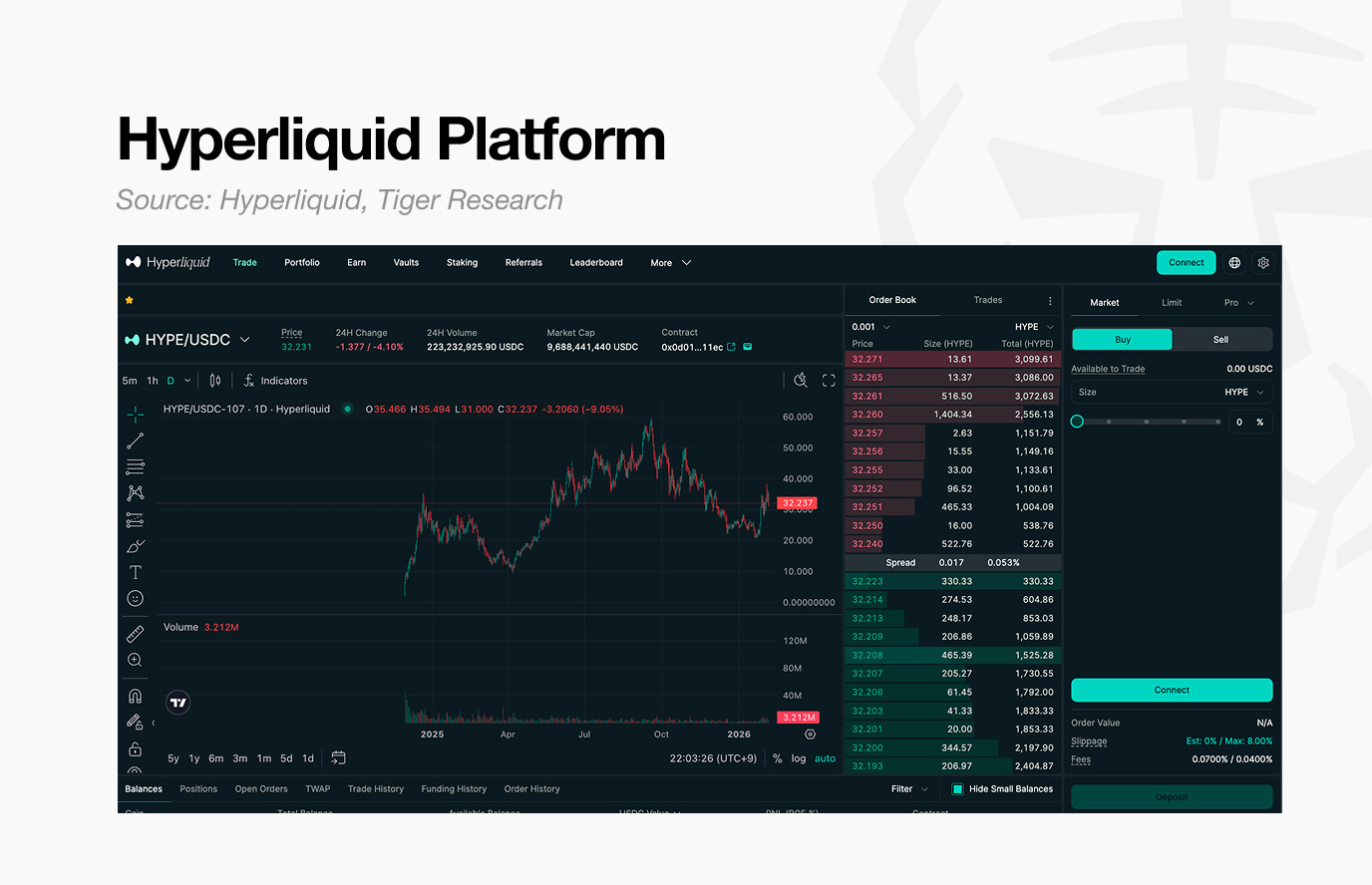

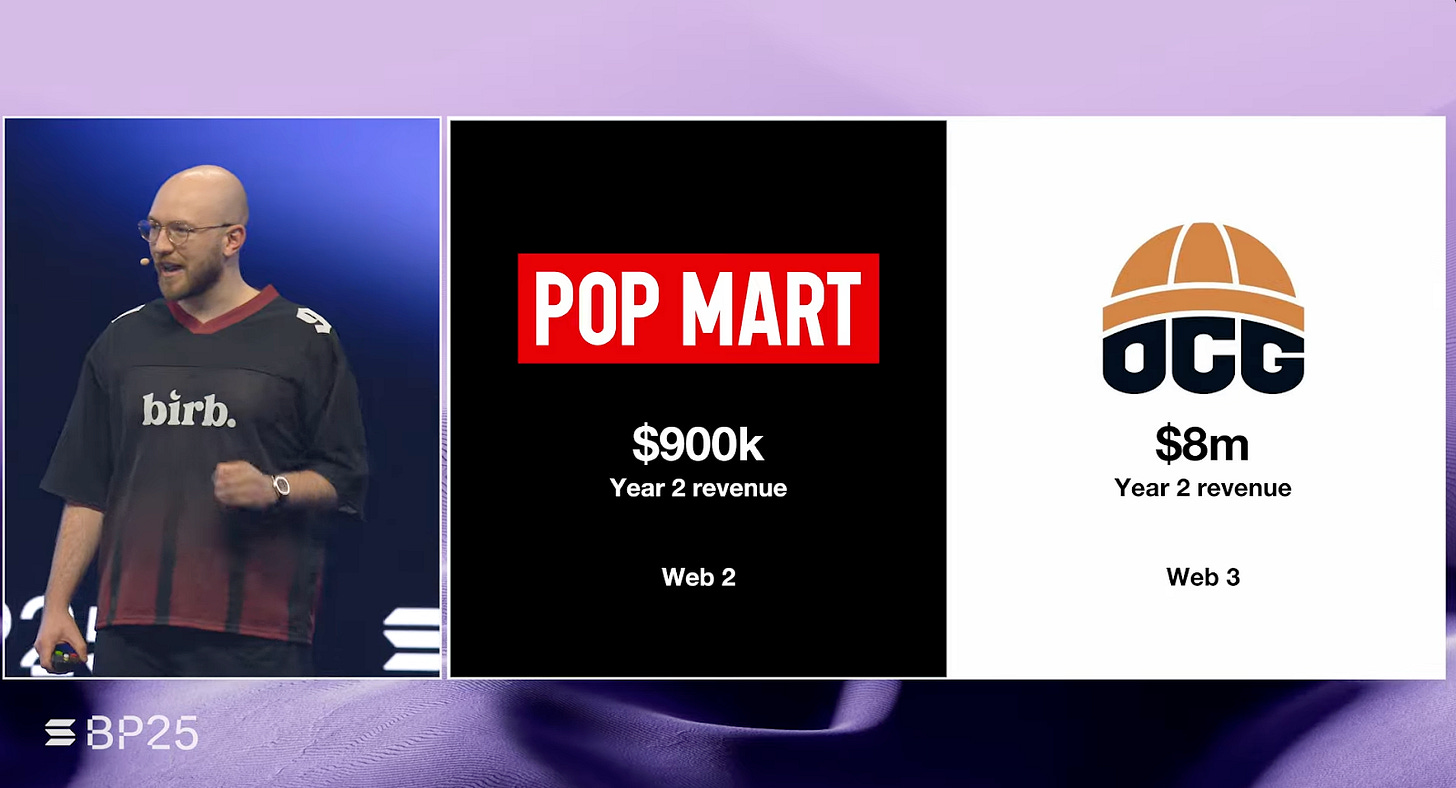

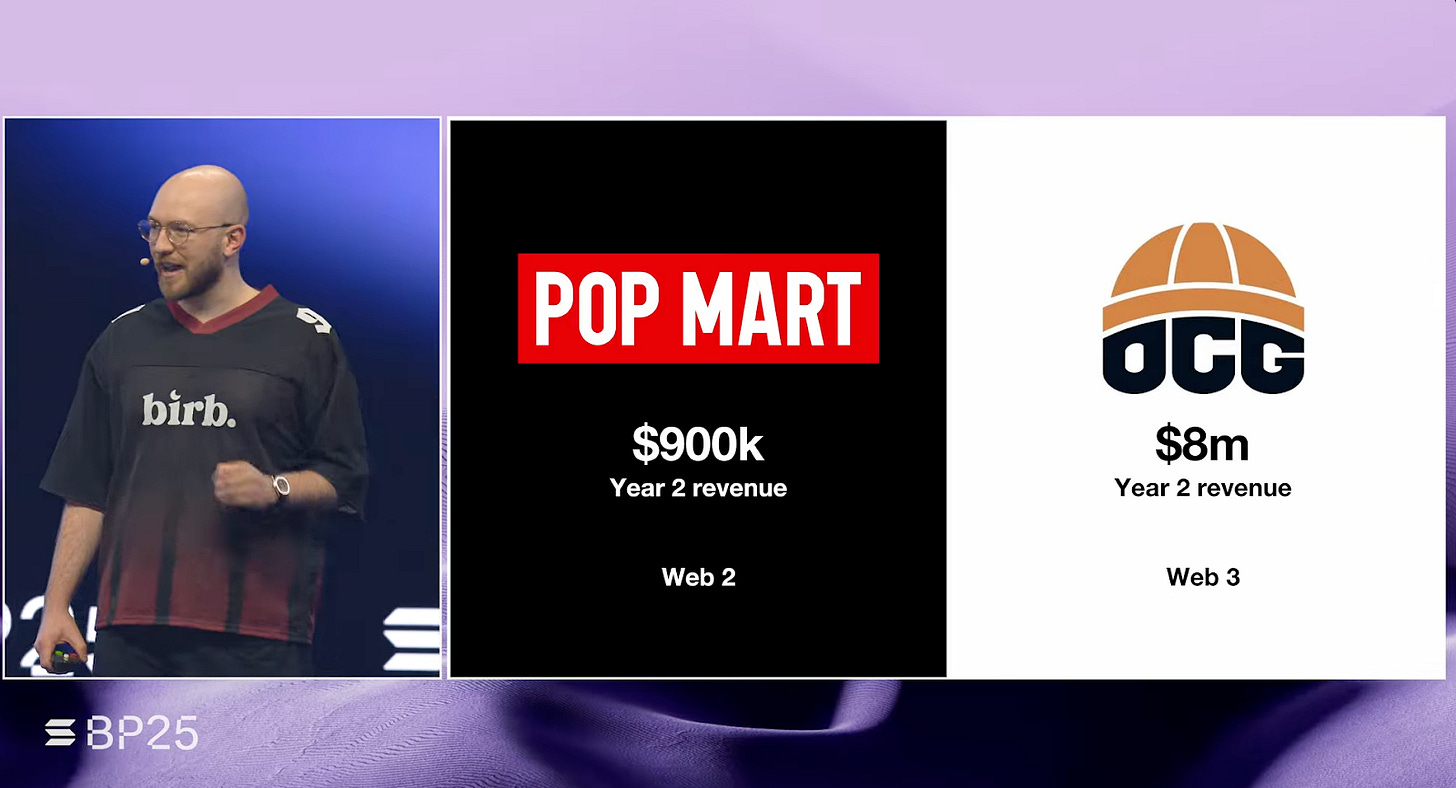

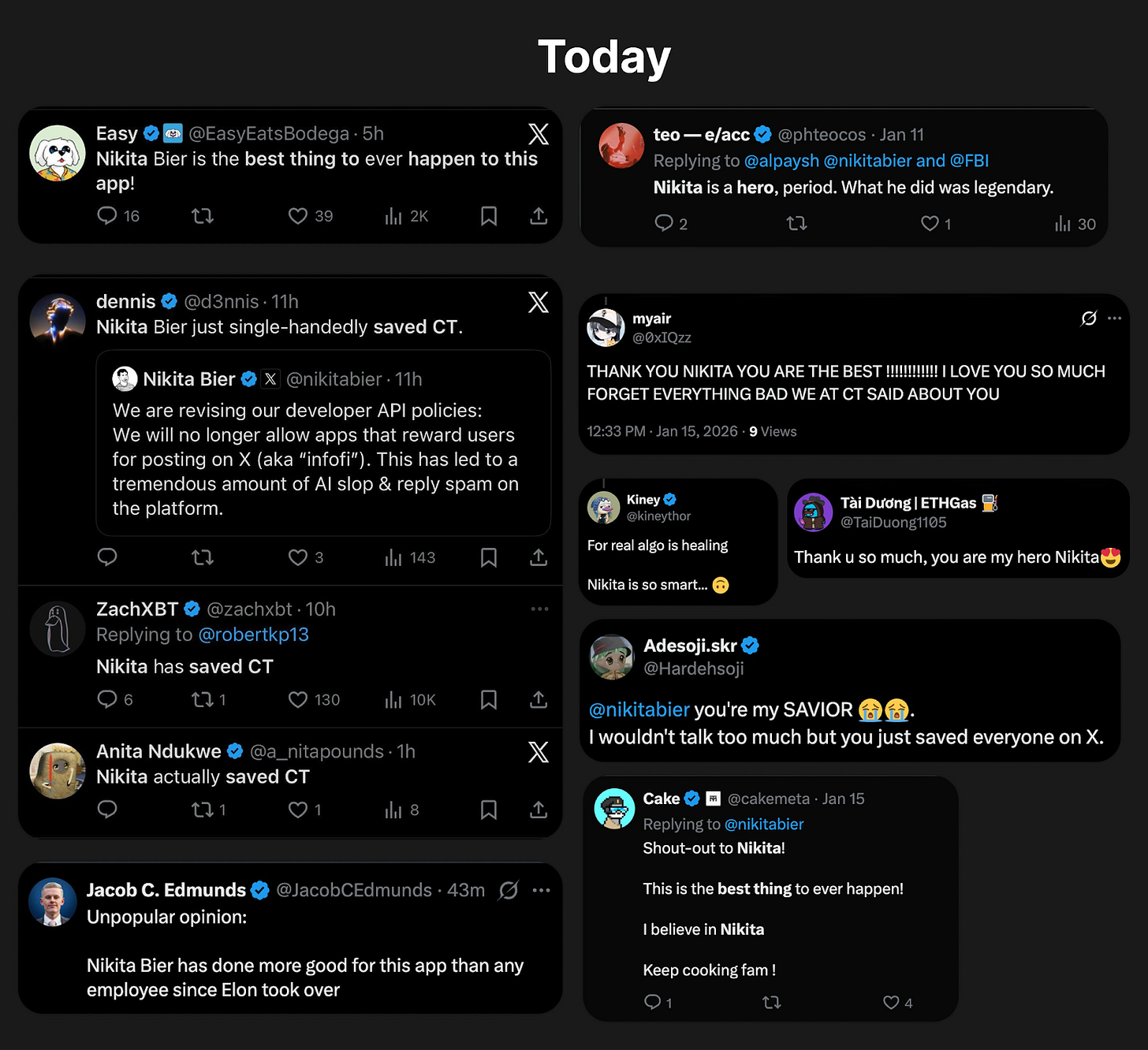

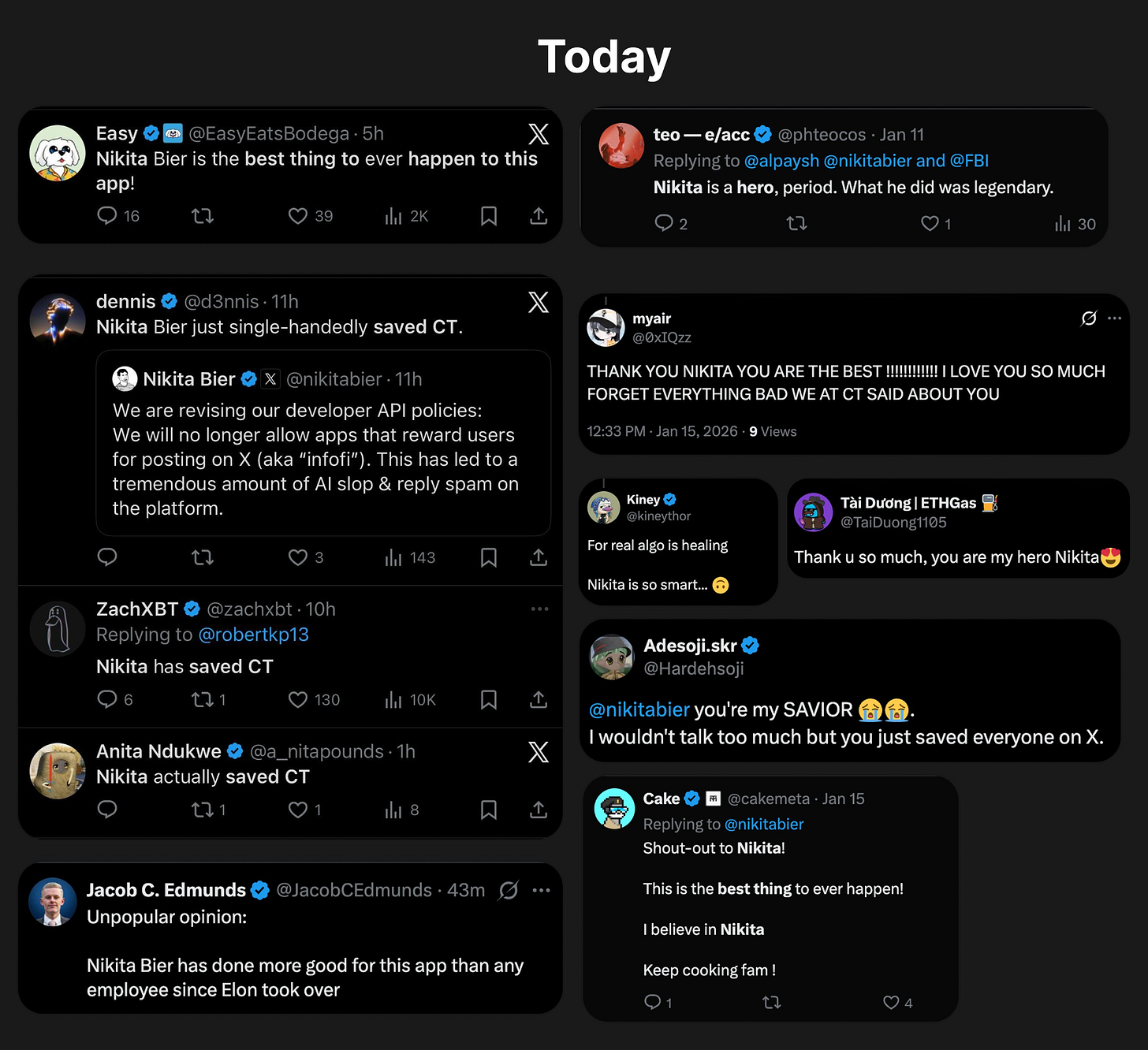

Hyperliquid is a clear example. The team’s own perpDEX became one of crypto’s standout successes. The Web3 market looks quite different before and after Hyperliquid. Before, teams relied on grant programs to attract killer apps from external builders. After, the new formula became: build it yourself and prove it.

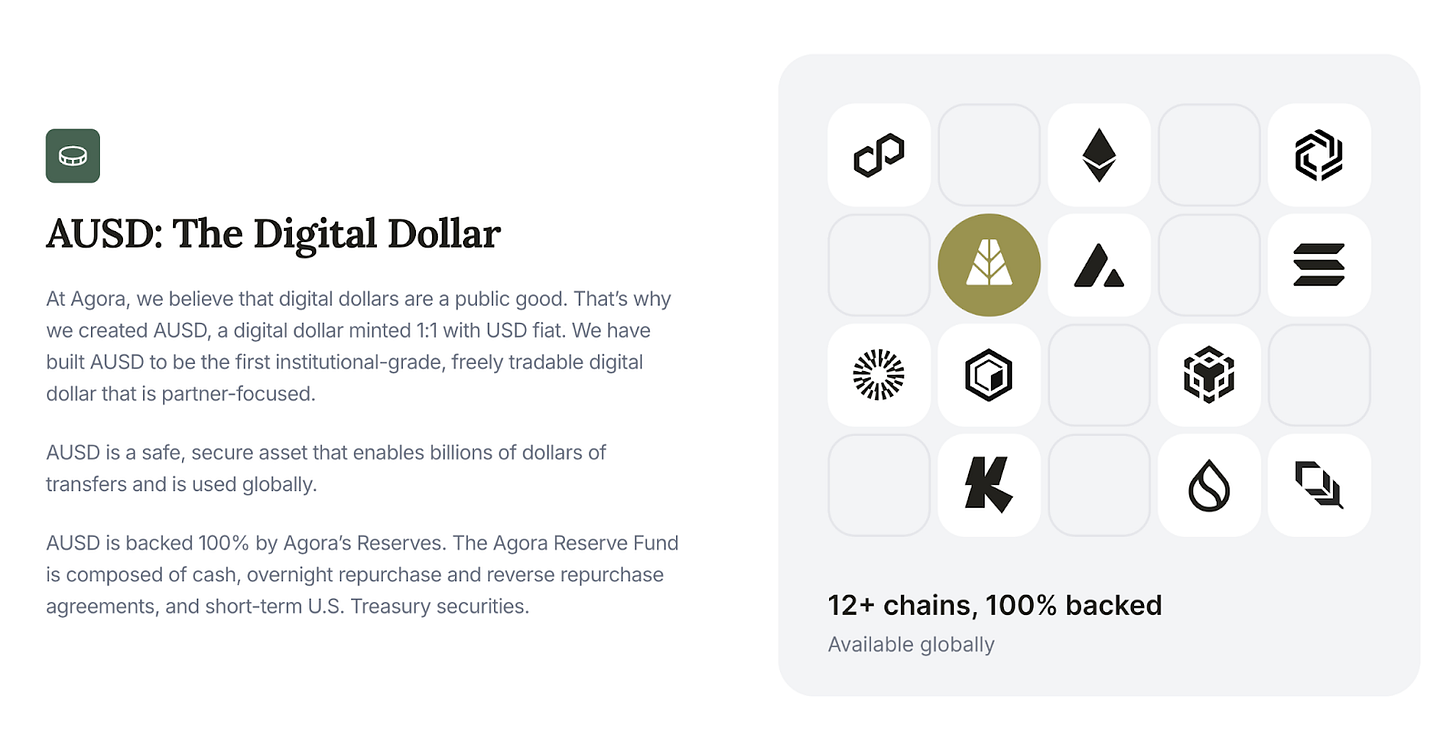

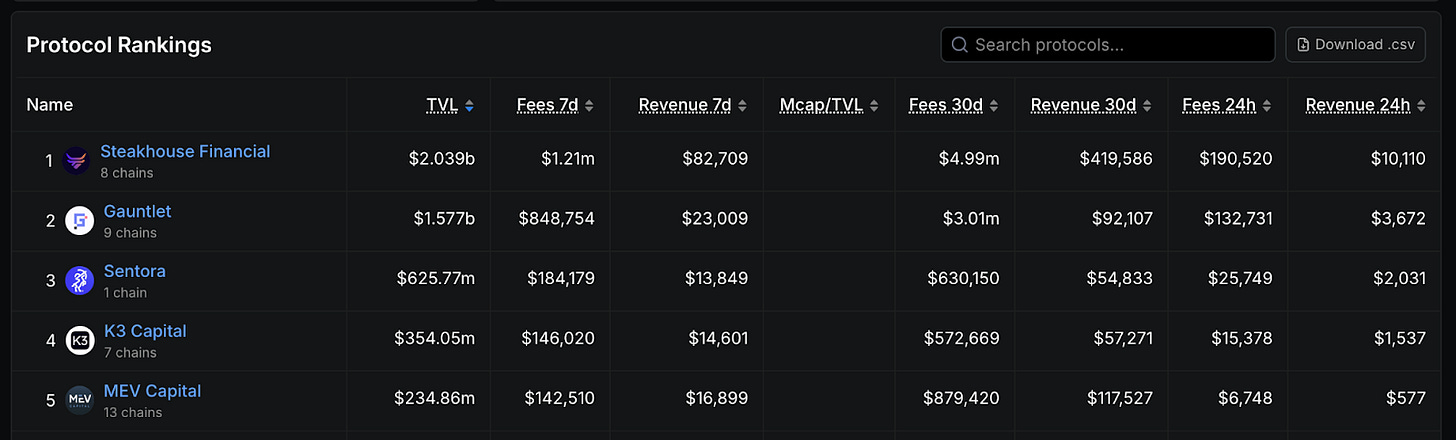

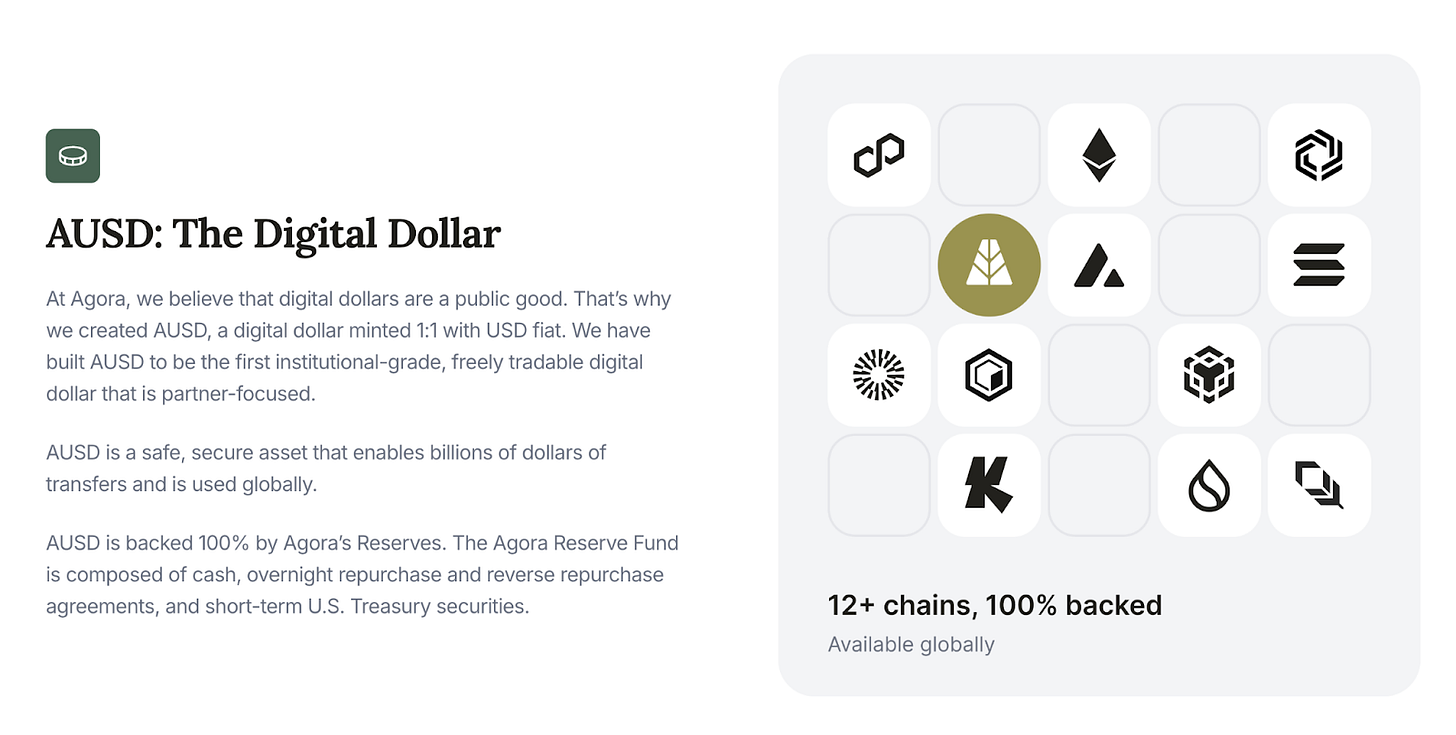

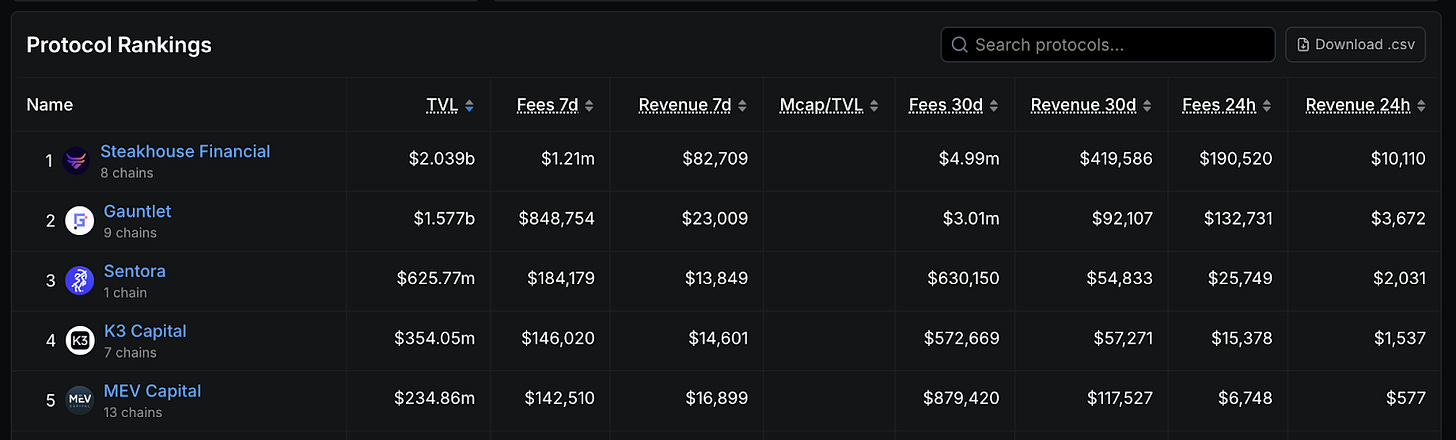

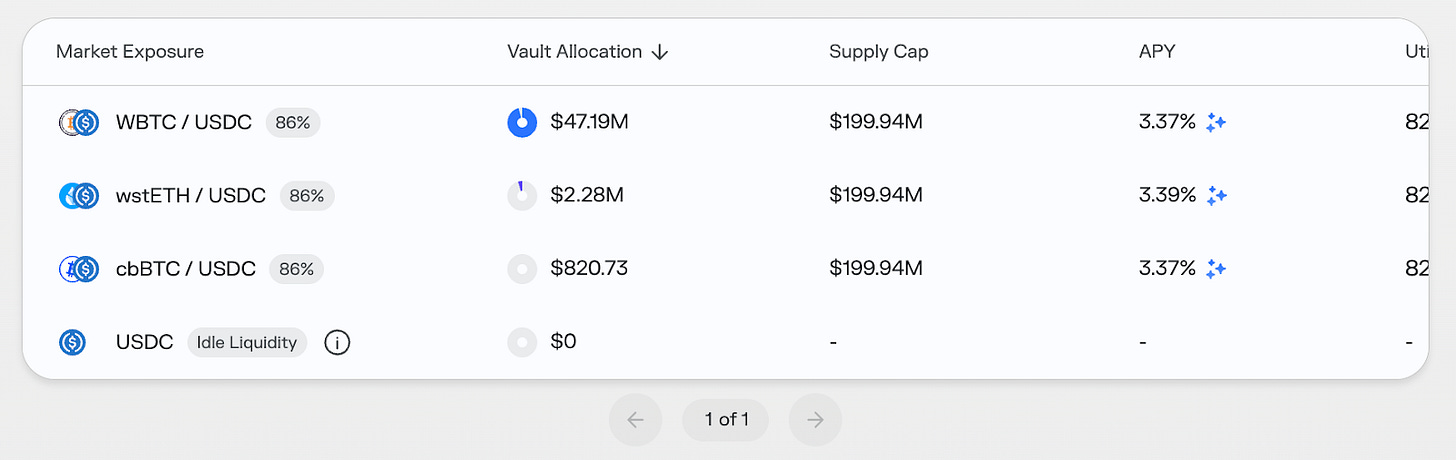

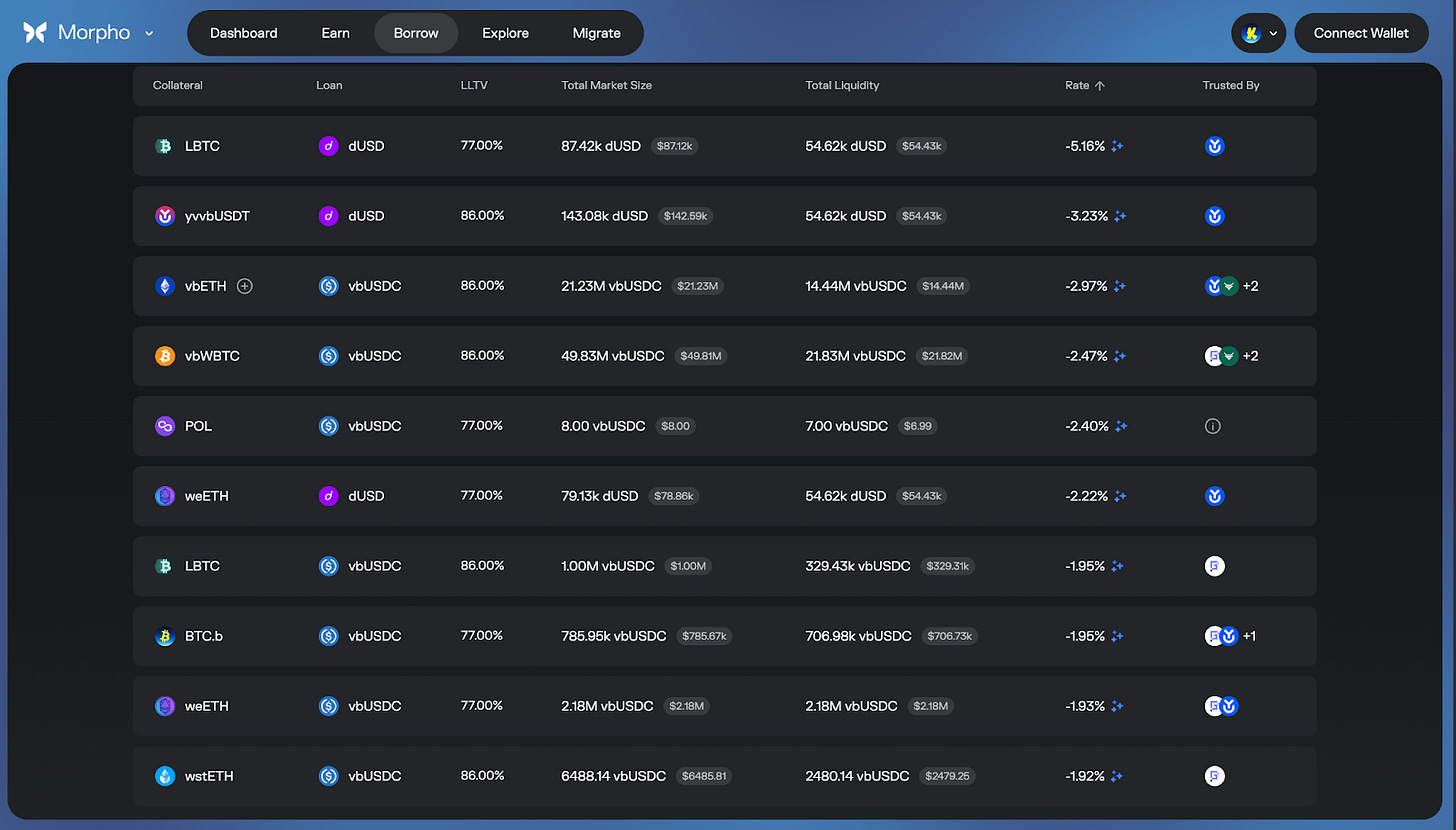

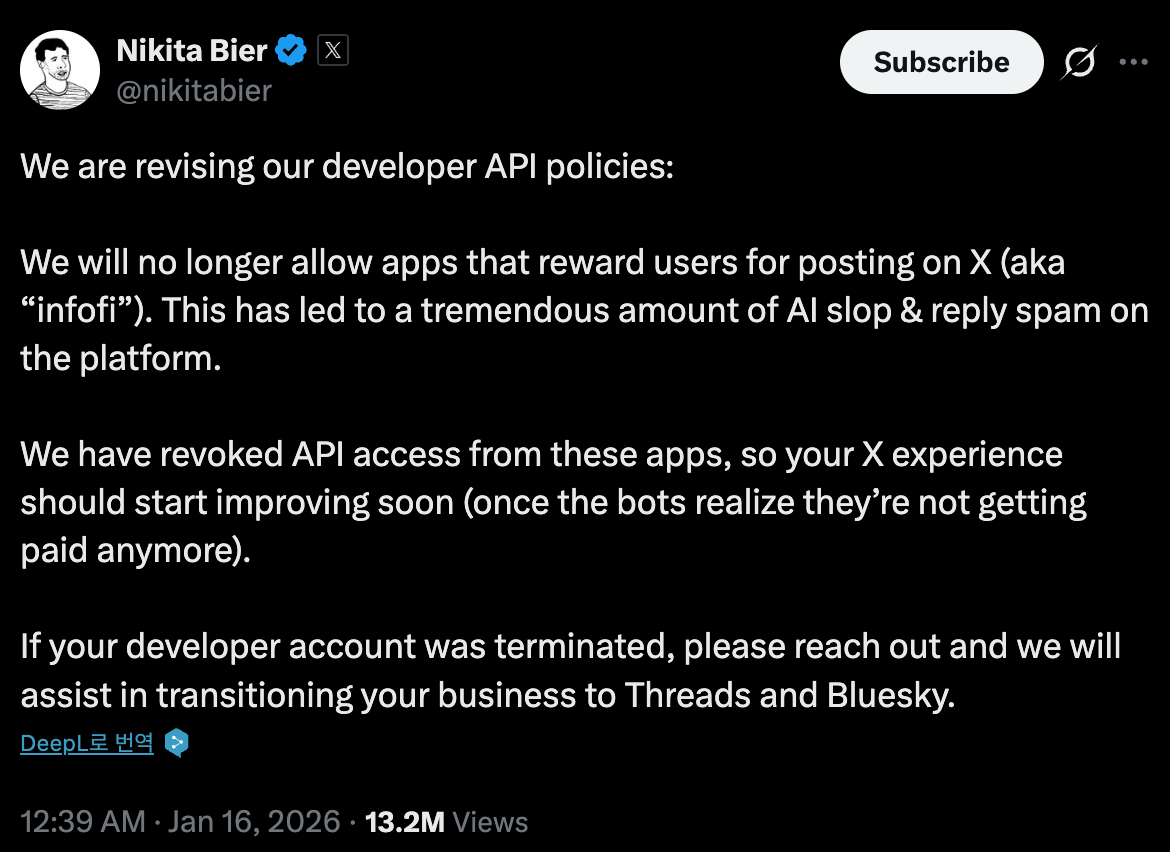

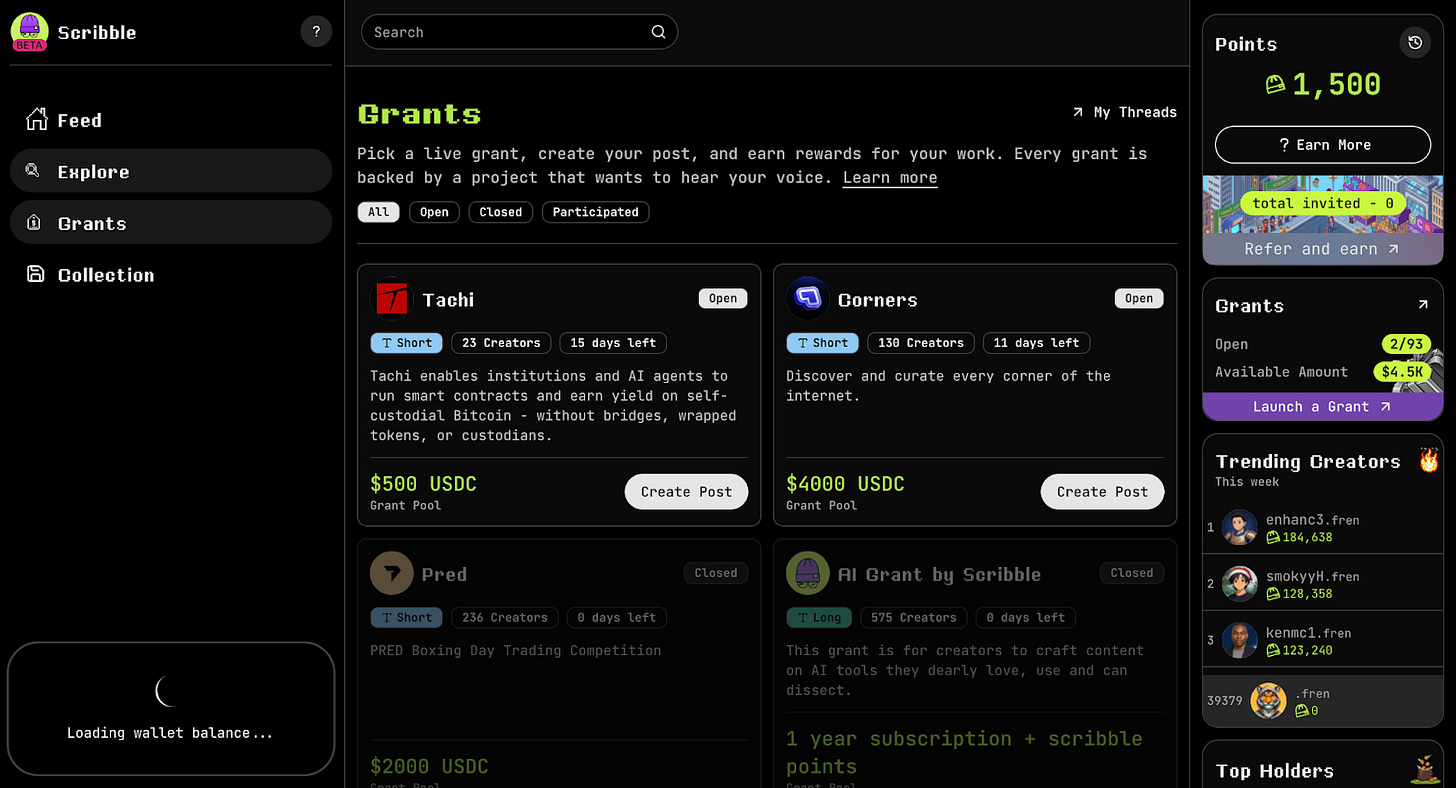

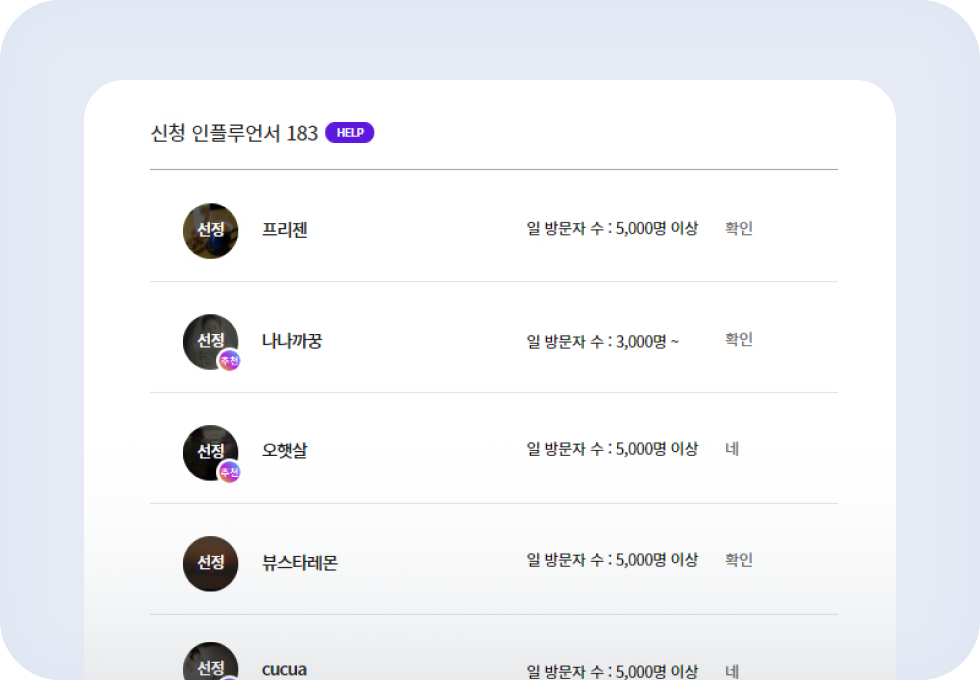

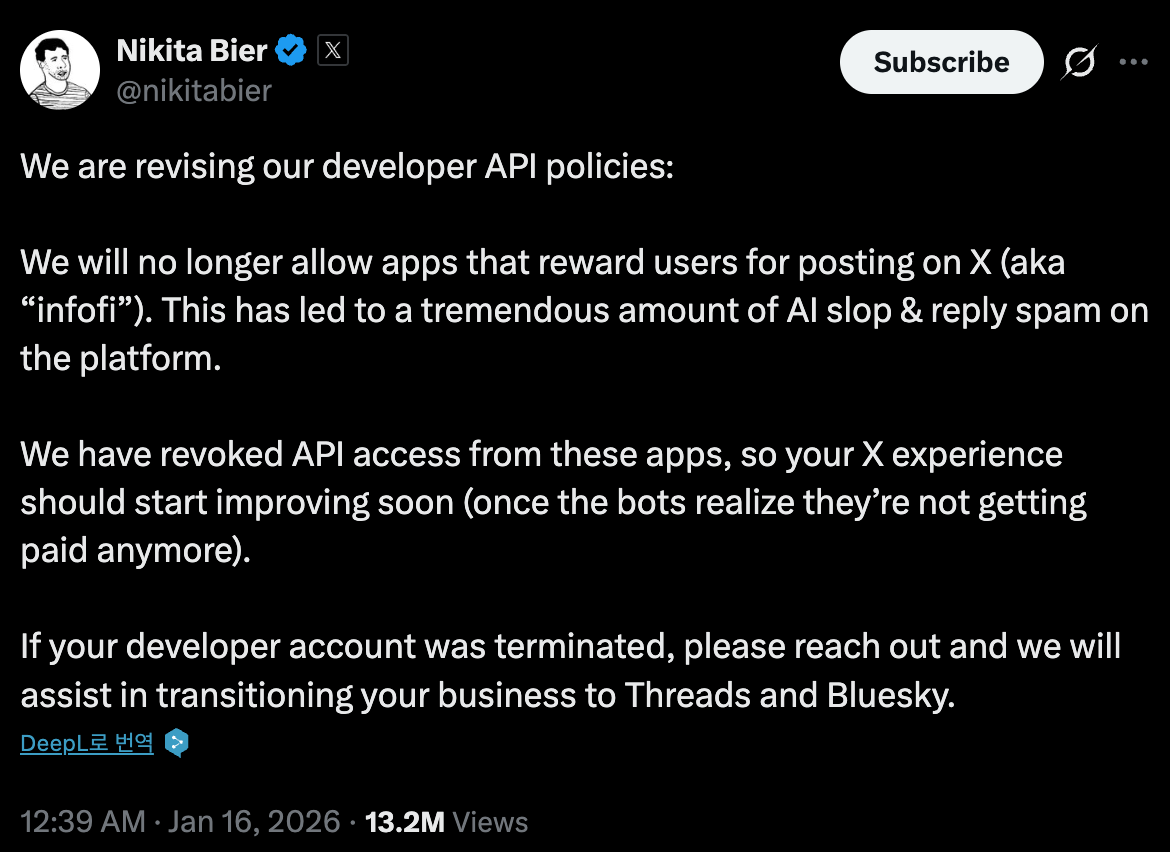

Following this shift, Fluent is building its own service called Prints. Prints is a tool that aggregates “reputation” scattered across the internet, verifying who is real and who is trustworthy. In simple terms, it is a reputation aggregator for the info-fi era, pulling together reputation scores from multiple platforms into one view.

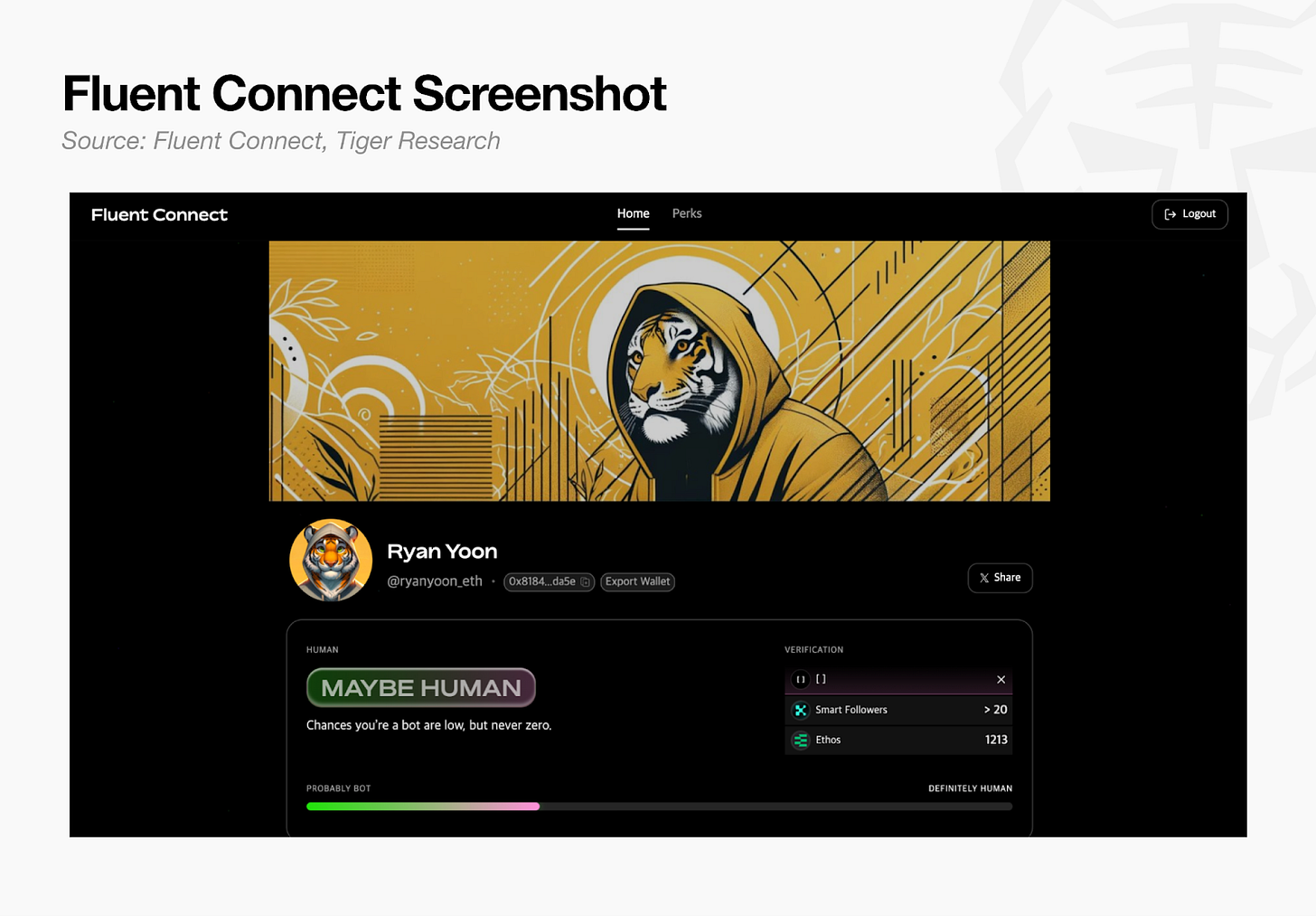

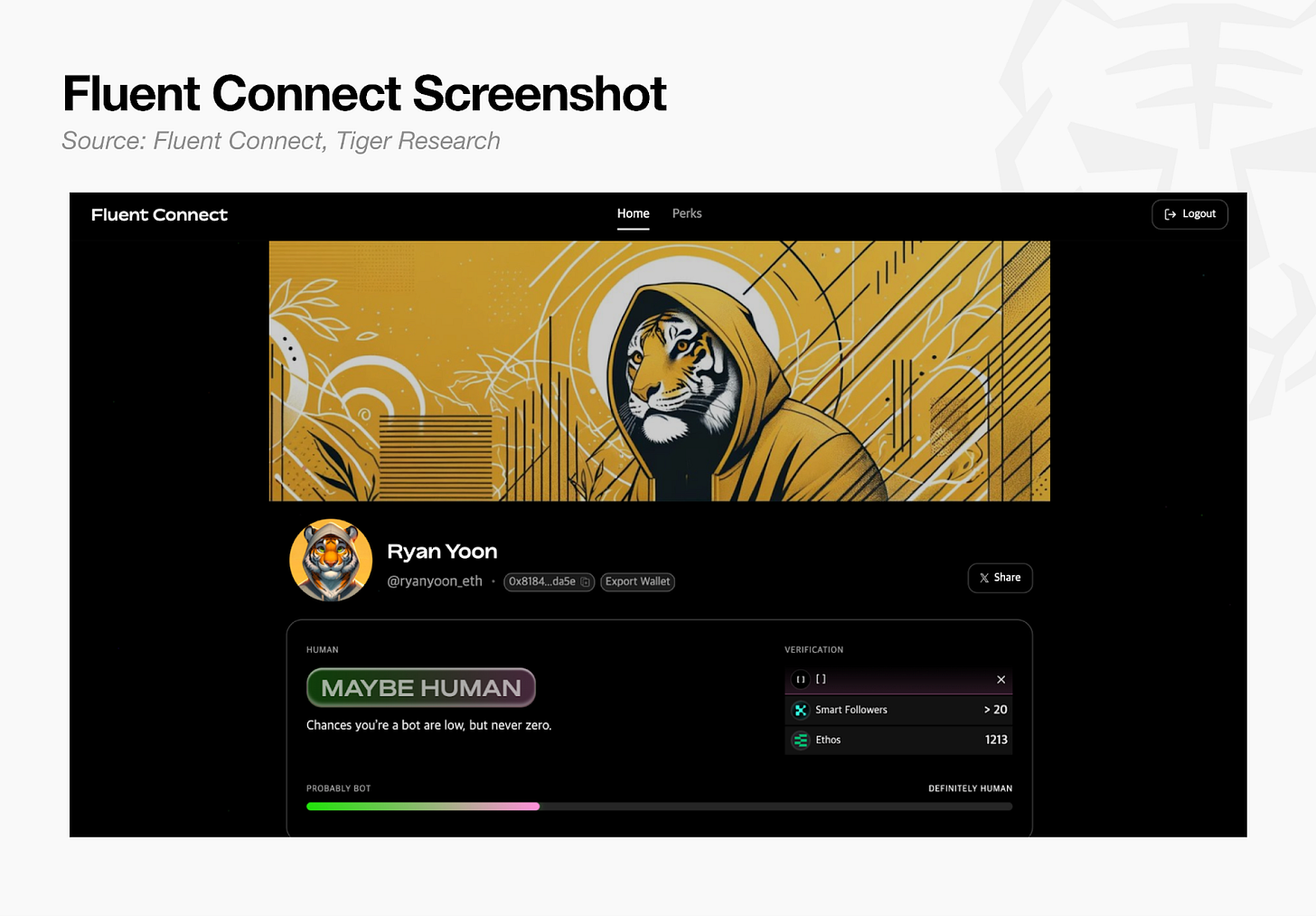

It currently integrates Ethos trust scores, Kaito smart followers, and Talent Protocol builder scores in one place. Any single metric alone is vulnerable to gaming. But while one score can be manipulated, faking several at once is far more difficult.

For users, Prints serves as a Web3 reputation resume, proving credibility across domains on a single page. For builders, it is a reputation tool that can be directly integrated into their apps.

On top of Prints sits Fluent Connect, a service where builders can use Prints’ reputation data to find users matching specific criteria and distribute early access or token benefits through a feature called Perks. In short, it is a matching tool connecting builders with genuine users.

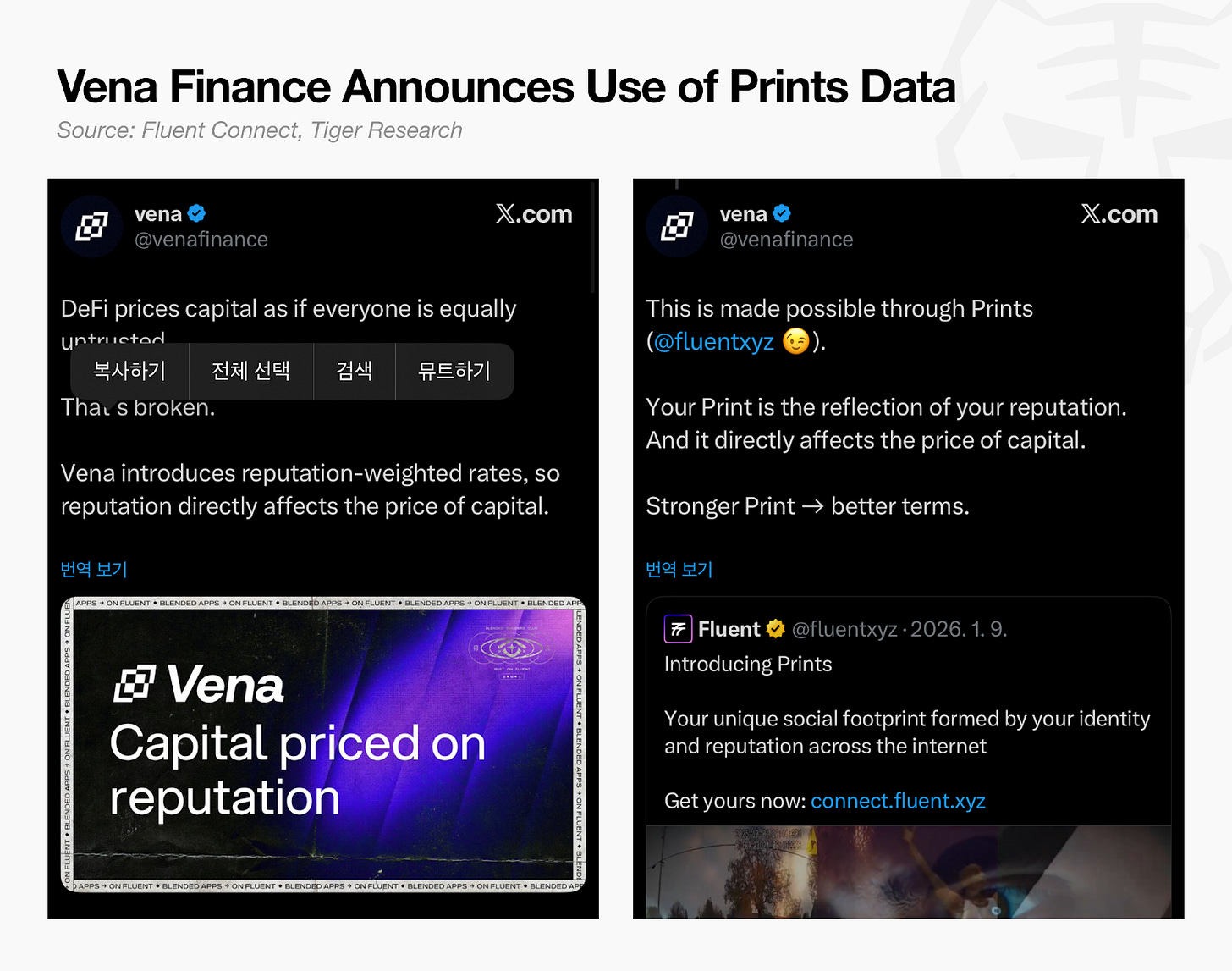

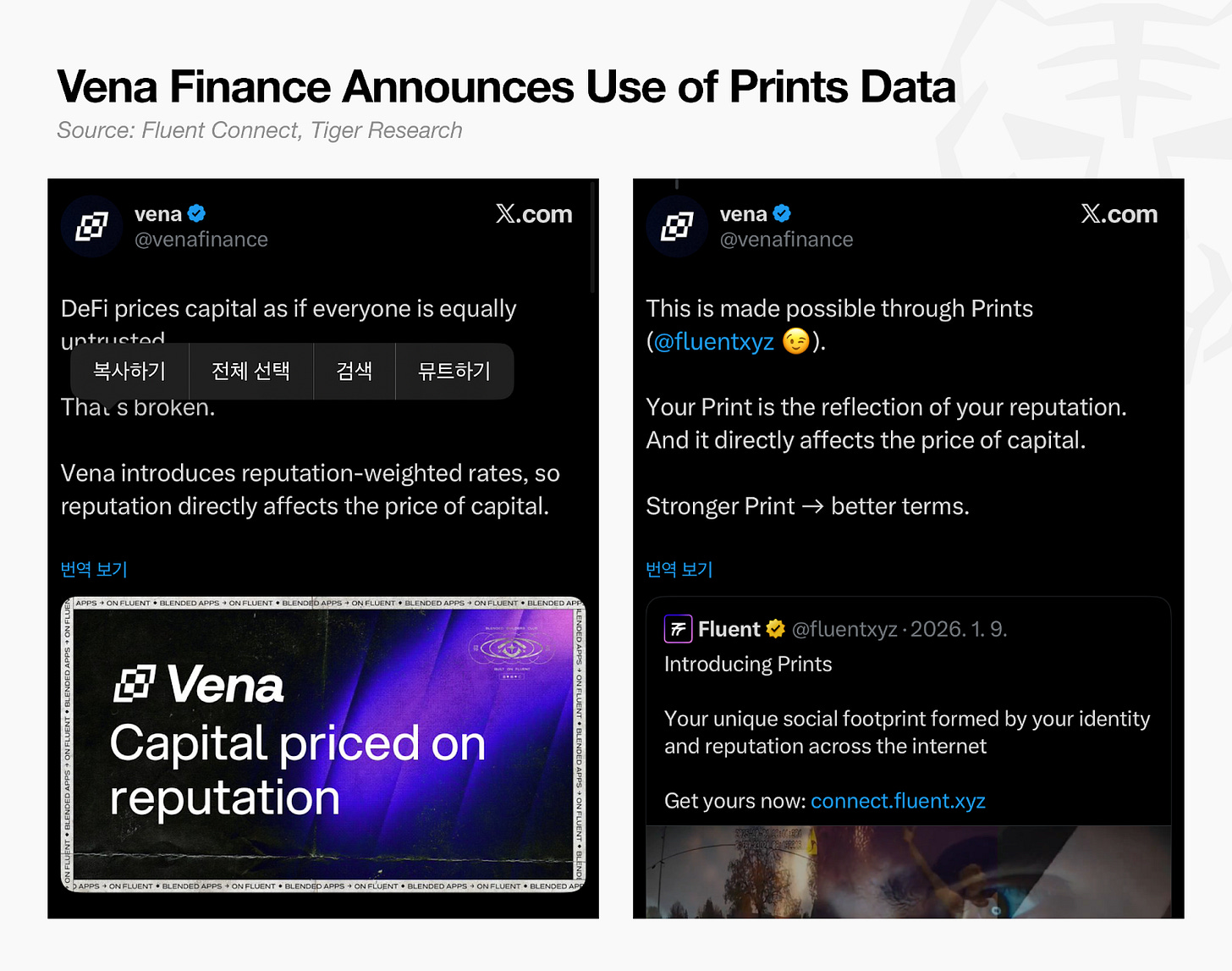

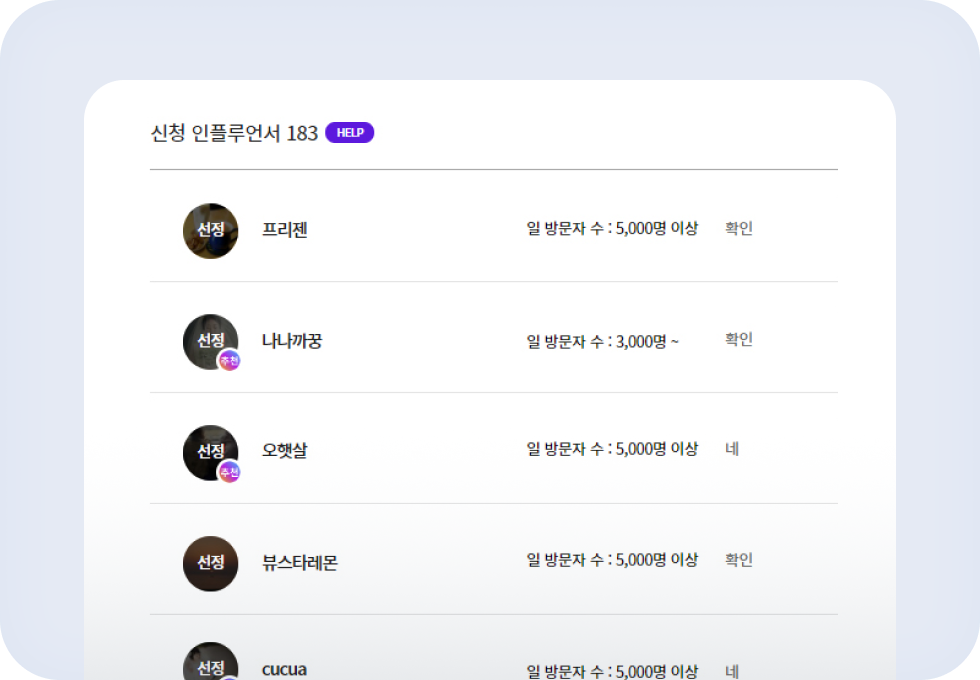

Third-party adoption is already emerging.

Vena Finance announced it will use Prints data to introduce reputation-based interest rates, offering better lending terms to higher-reputation users. The service has launched with approximately 40,000 sign-ups, and a builder API is under development.

However, since Prints aggregates external services, it lacks proprietary reputation signals of its own. To address this, Fluent has created an internal feedback score and plans to integrate additional signals such as prediction market performance, yield curator track records, and AI agent reputation over time.

4. Fluent’s Ecosystem

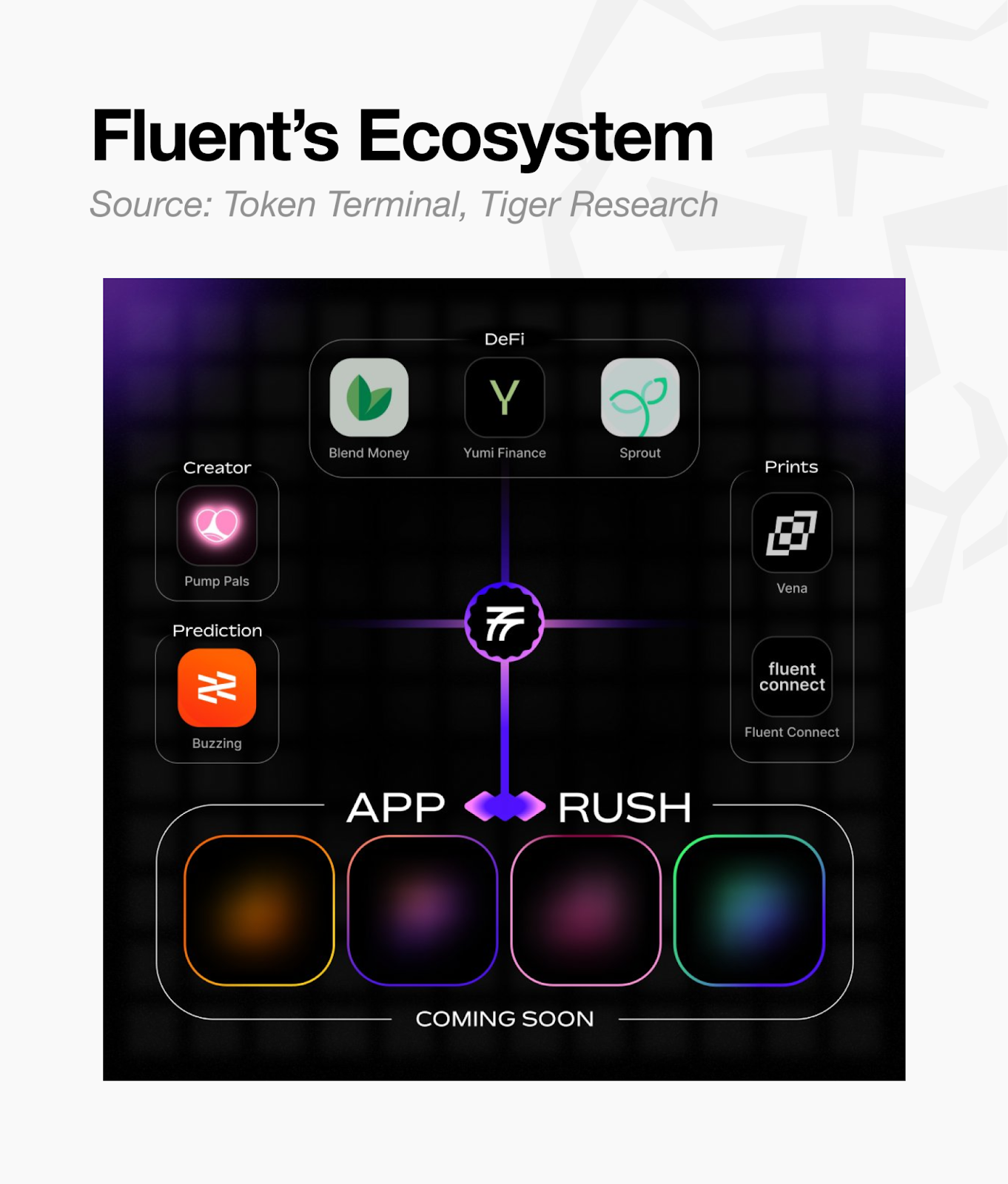

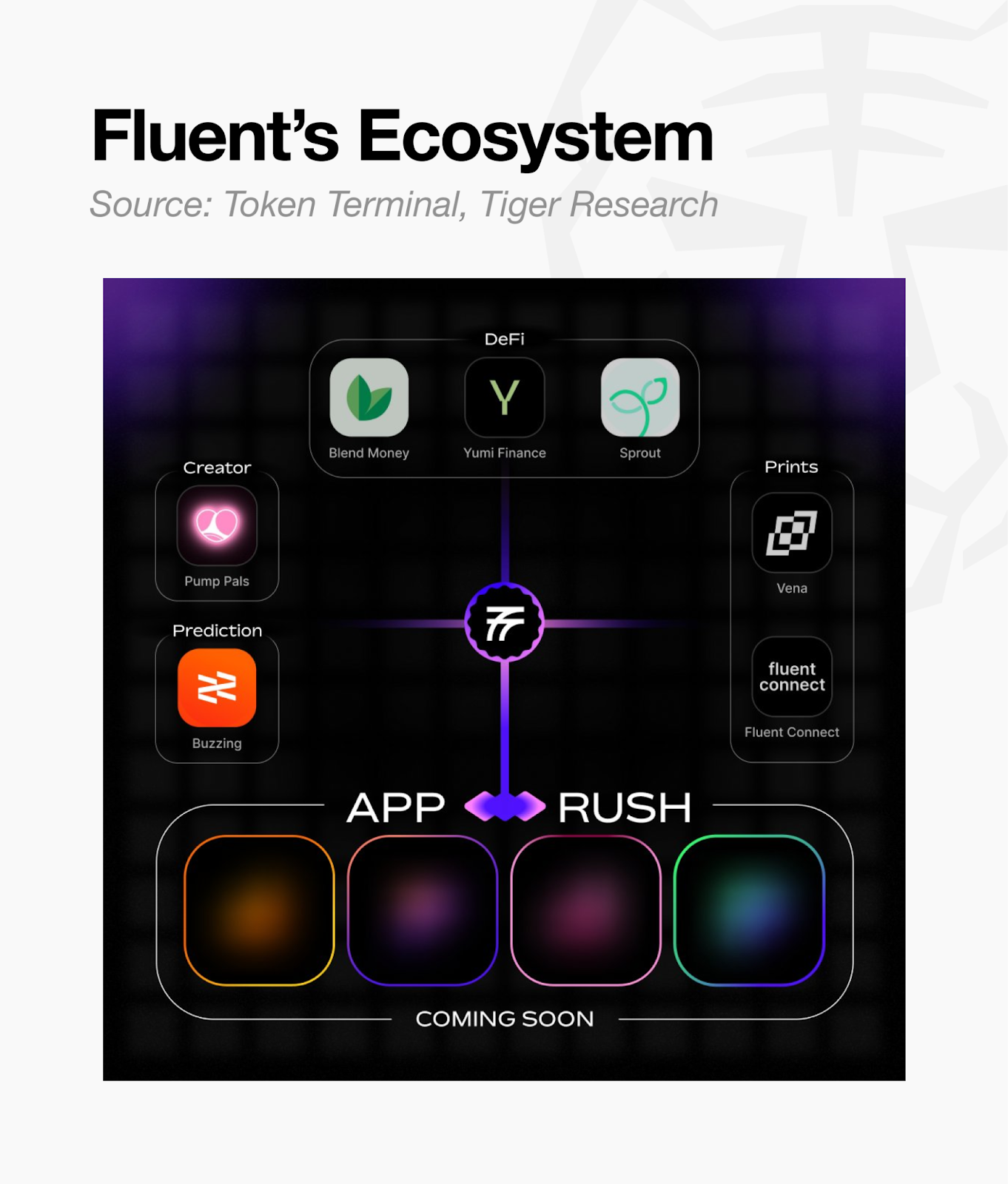

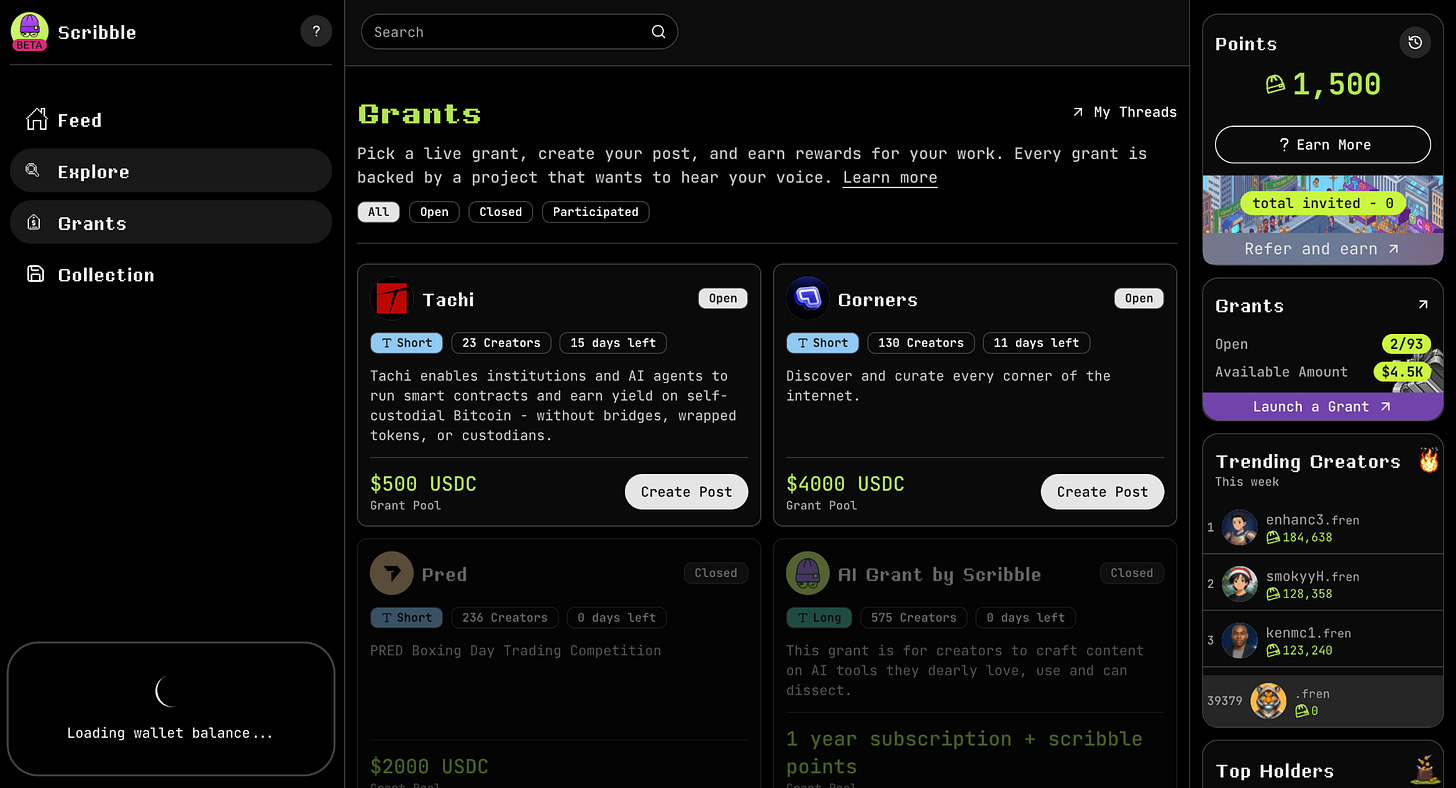

Prints is still in its expansion phase and needs time to become a complete reputation system. Fluent is not simply waiting. It is building its ecosystem by nurturing external builders in parallel. The vehicle for this is the Blended Builders Club (BBC), Fluent’s own accelerator.

Five teams were selected for the first cohort:

Pump Pals: A social trading platform enabling community-driven trading experiences

Sprout: An automated yield optimization platform that matches strategies to user risk profiles

Buzzing: A prediction market platform where users create their own markets and bet on outcomes

Yumi Finance: On-chain credit infrastructure that attaches credit scoring to crypto cards, enabling buy-now-pay-later

Blend Money: An on-chain savings platform that automatically applies yield strategies and currency hedging when users deposit in local currency

Among these, PumpPals, Sprout, and Buzzing have already completed user testing on testnet. The testnet approach itself is worth noting. On most chains, testnets function as airdrop farming tools. Users repeat meaningless transactions expecting rewards, and teams mistake inflated metrics for real demand.

Fluent reframed the testnet’s purpose around feedback collection. User feedback is delivered directly to builder teams, who use it to improve their products. Users who provide quality feedback earn reputation scores in Prints, gaining priority for future benefits. Apps are not launched all at once but featured one at a time over several weeks, ensuring each team receives focused feedback.

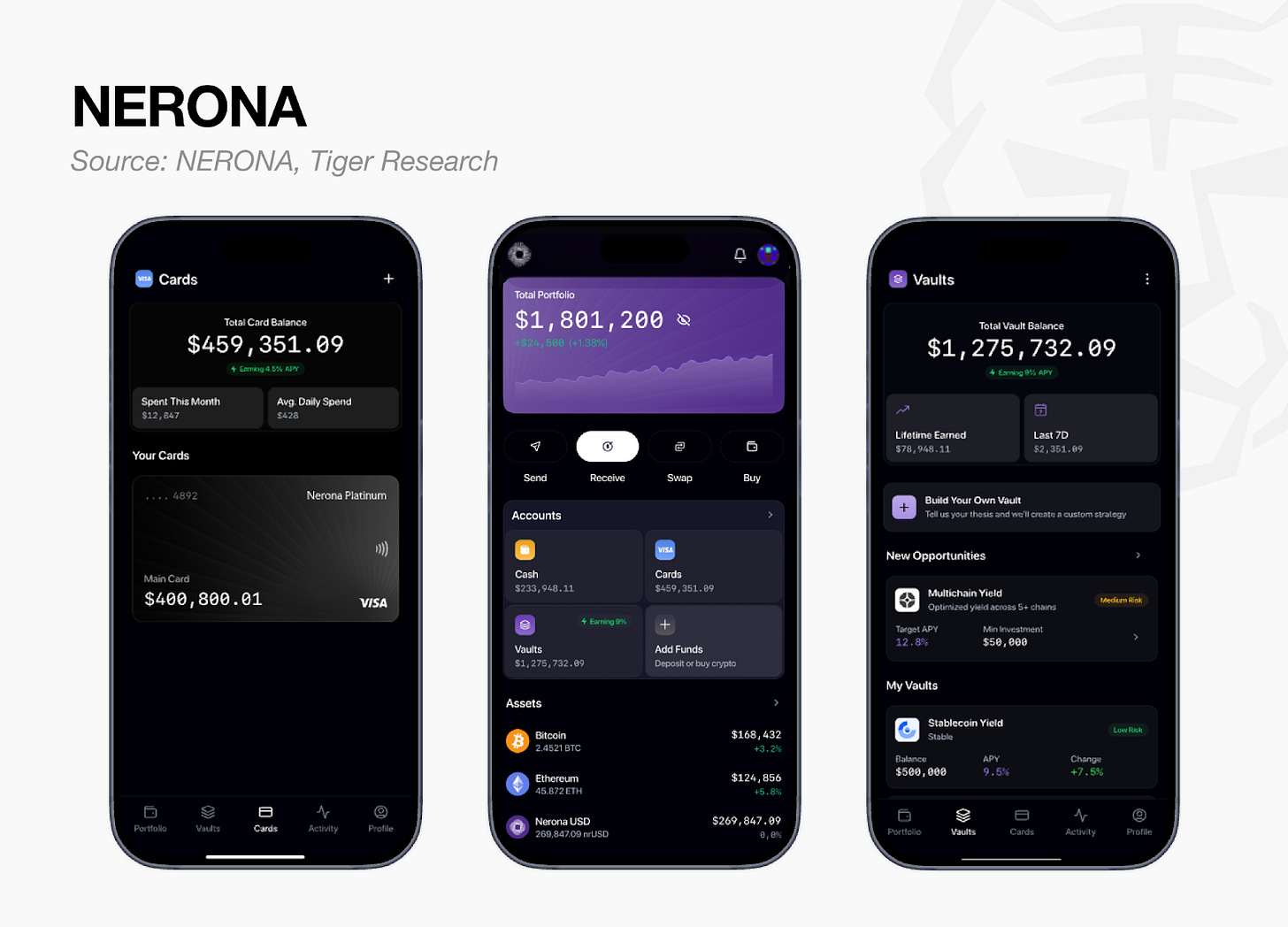

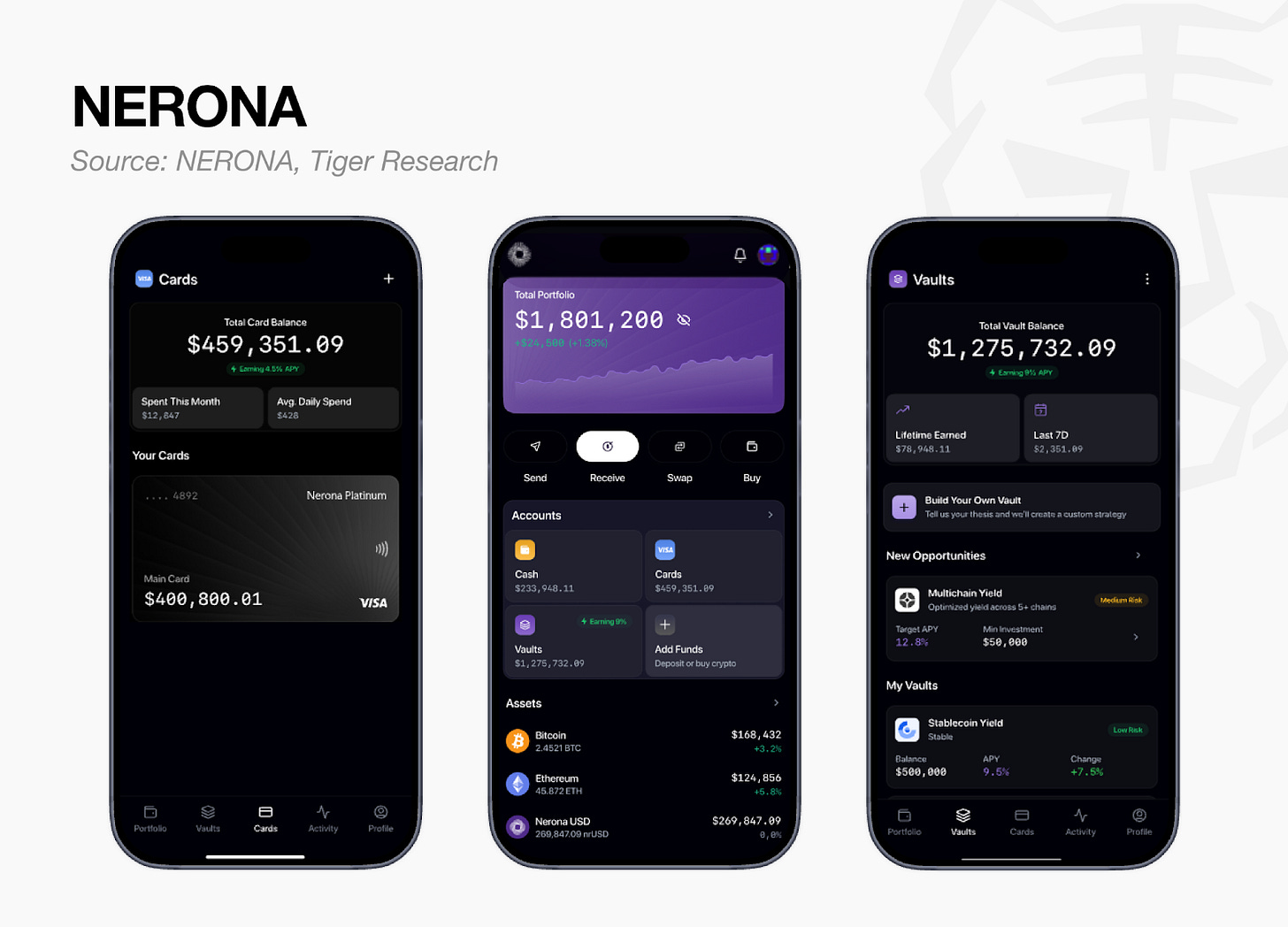

Beyond BBC, additional ecosystem growth is emerging. Nerona is an on-chain asset management platform that bundles a mobile app, crypto card, stablecoin yield, and lending into one place. Previously, these functions were scattered across separate services, leaving capital idle. Nerona consolidates them so capital is always working.

When combined with Prints’ reputation data, it becomes possible to offer differentiated interest rates or service terms based on user trustworthiness. This aligns with the same direction as Vena Finance’s reputation-based interest rates introduced earlier.

5. The Picture Fluent Is Drawing

Fluent is building three things simultaneously.

First, the chain. Blended Execution enables EVM, SVM, and Wasm apps to be composed on a single chain. The technical direction is clear, and EVM-Wasm blended execution is already working on testnet. However, SVM integration is still in the optimization phase, and whether all three VMs run stably in a mainnet environment remains to be verified.

Second, Prints. The design of aggregating multiple reputation signals for cross-verification is compelling. One metric can be gamed, but faking several at once is far harder. That said, the number of integrated signals is still small, and most depend on external services. Whether Prints can reach the stage of generating and verifying reputation on its own is something to watch.

Third, the ecosystem. BBC is cultivating builders, and services like Vena Finance and Nerona are attempting to link reputation to financial terms. Most are still at an early stage or closer to concept, so how each service achieves real user acquisition will need to be observed.

Fluent is still early, but by designing chain, service, and ecosystem as a single integrated structure from the start, it sets expectations for what the completed picture could look like. Early execution has been demonstrated: blended execution works on testnet, and Prints-based services are beginning to attach.

In the last cycle, dozens of L2s launched, but most led with performance metrics alone and ended up as empty chains without users. Whether Fluent can break this pattern will be answered by real user numbers and on-chain activity after mainnet.

🐯 More from Tiger Research

Read more reports related to this research.Disclaimer

This report was partially funded by Fluent. It was independently produced by our researchers using credible sources. The findings, recommendations, and opinions are based on information available at publication time and may change without notice. We disclaim liability for any losses from using this report or its contents and do not warrant its accuracy or completeness. The information may differ from others’ views. This report is for informational purposes only and is not legal, business, investment, or tax advice. References to securities or digital assets are for illustration only, not investment advice or offers. This material is not intended for investors.

Terms of Usage

Tiger Research allows the fair use of its reports. ‘Fair use’ is a principle that broadly permits the use of specific content for public interest purposes, as long as it doesn’t harm the commercial value of the material. If the use aligns with the purpose of fair use, the reports can be utilized without prior permission. However, when citing Tiger Research’s reports, it is mandatory to 1) clearly state ‘Tiger Research’ as the source, 2) include the Tiger Research logo following brand guideline. If the material is to be restructured and published, separate negotiations are required. Unauthorized use of the reports may result in legal action.

]]>Key Takeaways

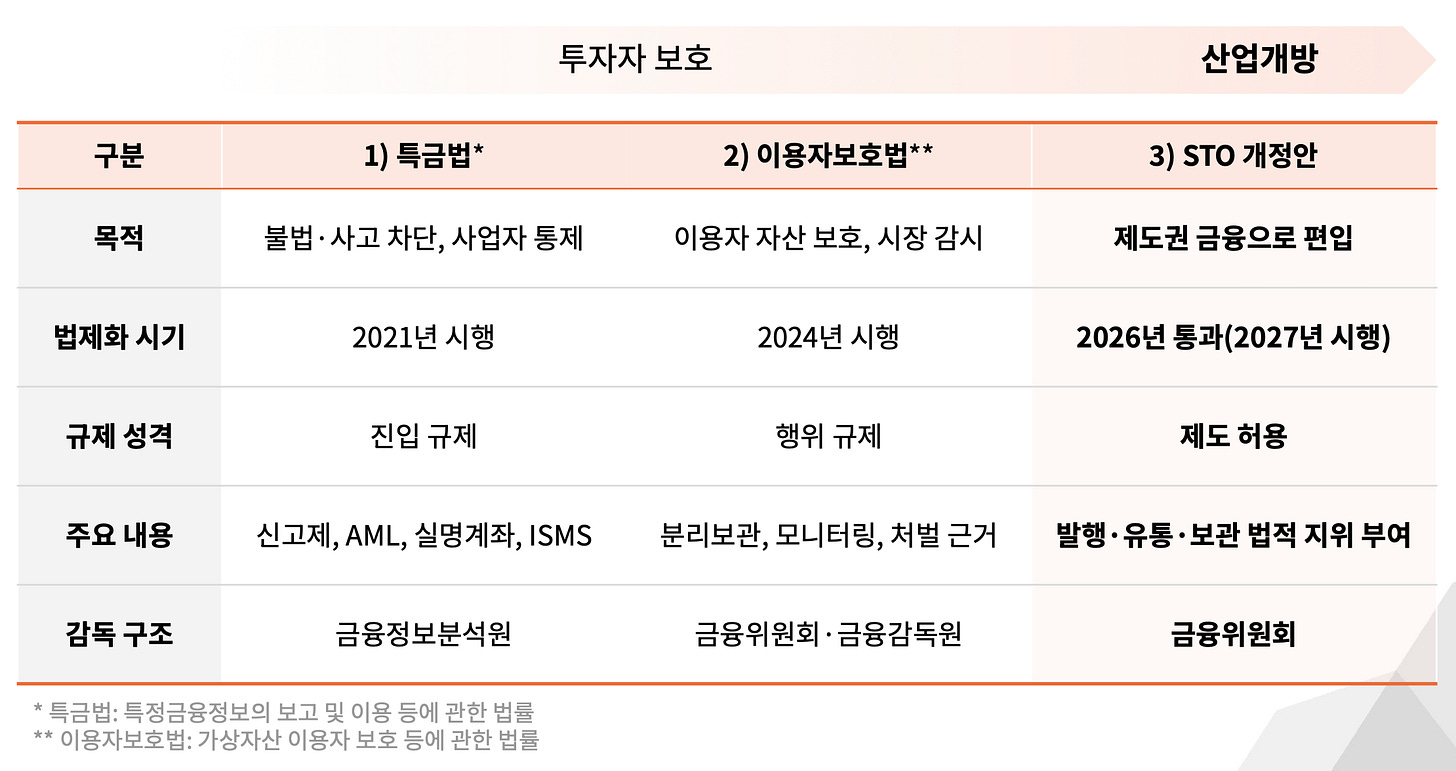

이제 체인별 성능 전쟁은 끝났고, 다음 승부는 VM 간 조합 가능성에서 갈릴 것

플루언트의 Blended Execution은 EVM, SVM, Wasm을 하나의 체인에서 실행해 조합성(Composability)을 극대화

시장은 기술력을 넘어서 자체적으로 만든 서비스를 원하기에 플루언트는 인포파이 어그리게이터 프린트(Prints)를 구축하고 있음

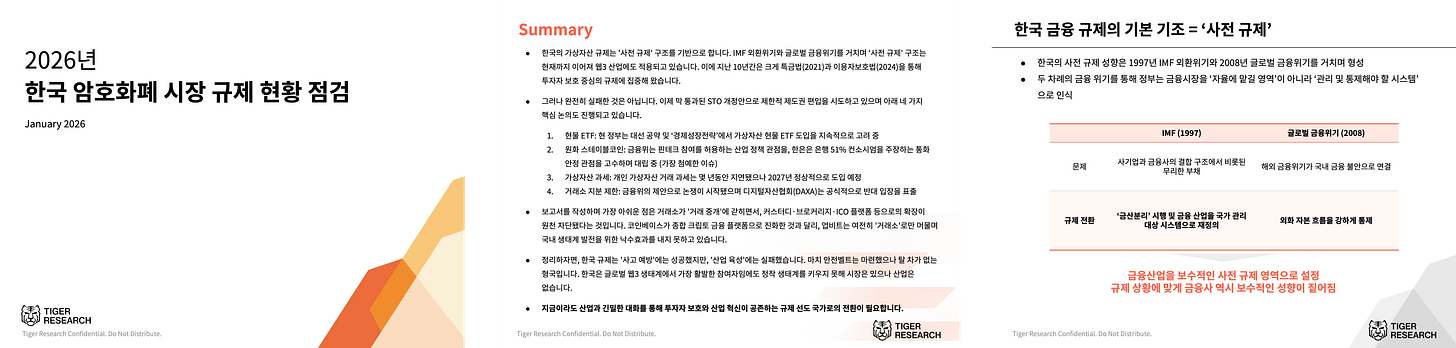

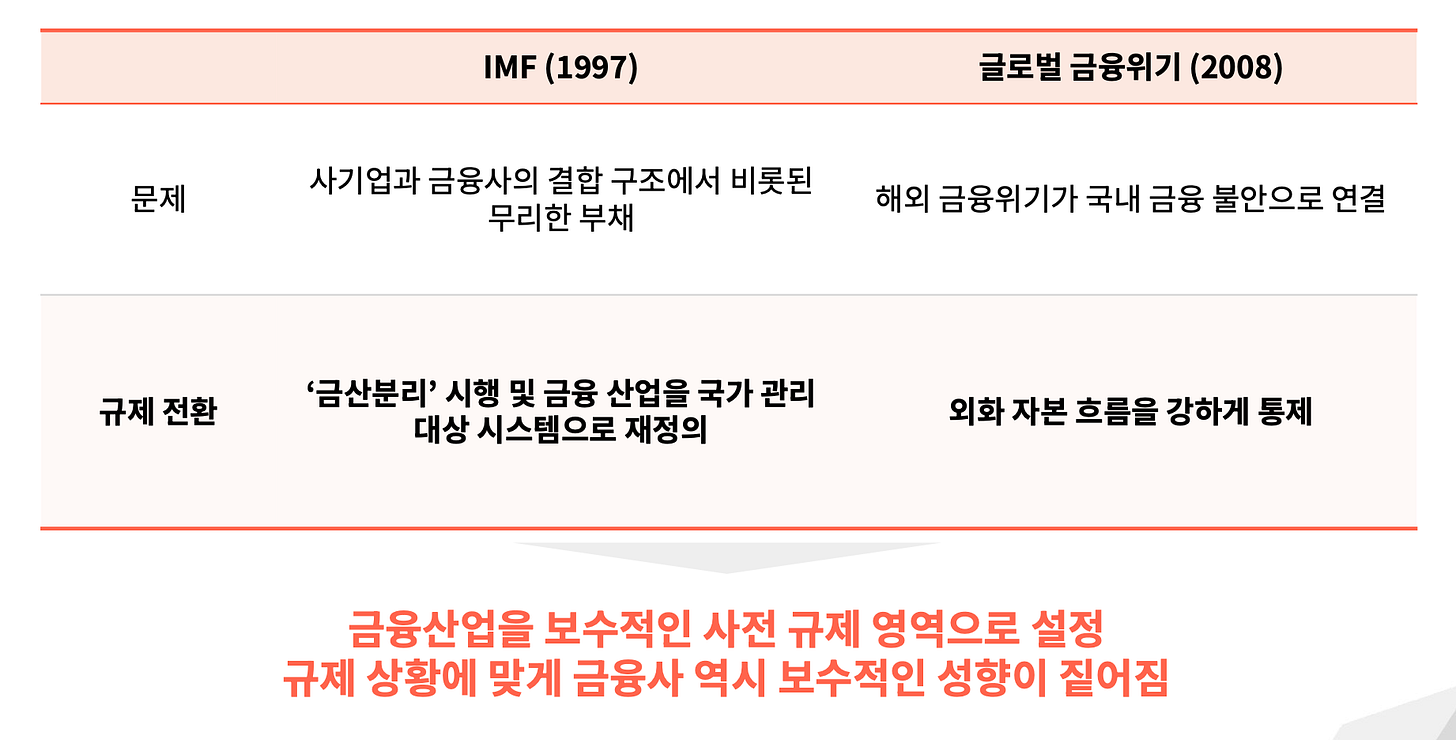

1. 성능 다음의 싸움

블록체인 인프라 경쟁은 성능에서 시작됐다. 더 빠르게, 더 싸게, 더 많은 트랜잭션을 처리하는 것이 핵심이었다. 하지만 이 경쟁은 사실상 끝났다. 이미 수십 개의 체인이 존재하고, 극단적인 금융 서비스를 제외하면 대부분의 용도에 충분한 성능을 갖추고 있다.

돌이켜보면 블록체인의 가장 큰 도약은 성능이 아니라 결합성(Composability)에서 나왔다. 2020년 디파이 서머(DeFi Summer)가 대표적이다. 대출 프로토콜 위에 토큰 스왑이 얹히고, 그 위에 다시 이자 농사(Yield Farming)가 쌓였다.

즉, 핵심은 서로 다른 앱들이 레고 블록처럼 맞물려 돌아간 것에 있다.

문제는 이 조합 가능성이 하나의 가상머신(VM) 안에서만 작동했다는 점이다. 이더리움의 레고 블록은 솔라나에서 쓸 수 없었고, 솔라나의 레고 블록 역시 이더리움에서는 무용지물이었다. Fluent는 바로 이 VM 간 단절을 제거하기 위해 설계된 인프라다.

2. 플루언트(Fluent)가 꿈꾸는 레고

플루언트는 이 경계를 없애려는 프로젝트다. 서로 다른 VM의 앱을 하나의 체인 안에서 섞어 쓰는 “블렌디드 실행”이라는 접근이다.

먼저 지금 상황을 레고로 설명하면 이렇다. 이더리움 레고는 네모 블록이고, 솔라나 레고는 동그란 블록이다. 둘 다 같은 블록인데 규격이 달라서 끼울 수가 없다. 이더리움 위에서 만든 렌딩 앱과 솔라나 위에서 만든 트레이딩 앱을 하나로 조합하고 싶어도, 서로 다른 상자에 담긴 장난감이라 불가능하다.

Fluent는 이 서로 다른 규격의 블록들을 하나의 판 위에서 조립할 수 있게 만드는 보드다. 이더리움 L2로서 이더리움의 보안을 그대로 이어받으면서, 그 위에 새로운 실행 환경을 구축했다. 구조만 놓고 보면 Arbitrum이나 Base 같은 기존 이더리움 L2와 크게 다르지 않다. 차이는 실행 단계에서 드러난다.

다른 점은 하나다. 플루언트 안에서는 EVM, SVM, Wasm으로 만든 컨트랙트가 같은 체인, 같은 상태 위에 올라간다. Wasm(웹어셈블리)은 원래 웹 브라우저에서 고성능 프로그램을 돌리기 위해 만들어진 기술로, 러스트, C++, 타입스크립트 등 다양한 언어로 짠 코드를 하나의 공통 형식으로 변환해준다.

플루언트는 이 Wasm을 활용해 모든 컨트랙트를 rWasm(reduced Wasm)이라는 공통 형식으로 바꿔 실행한다. 네모 블록이든 동그란 블록이든 같은 규격으로 변환되니까, 하나의 판 위에서 자유롭게 조합할 수 있는 것이다.

그래서 솔리디티로 만든 앱이 러스트로 만든 앱의 함수를 직접 호출할 수 있다. 중간에 브릿지도, 메시지 릴레이도 없다. 하나의 트랜잭션 안에서 실행된다. 플루언트는 이걸 “블렌디드 실행(Blended Execution)”이라고 부른다.

현재 테스트넷에서 EVM과 Wasm 간 블렌디드 실행이 작동하고 있다. SVM 지원은 기능 개발이 완료됐고 최적화 단계에 있다. SVM까지 합류하면 EVM과 SVM 앱을 하나의 체인에서 조합하는 최초의 사례가 된다.

3. 프린트(Prints)로 증명하려는 플루언트

좋은 체인을 만들면 좋은 앱이 따라올까.

현실은 그렇지 않다.

하이퍼리퀴드가 좋은 예다. 팀이 직접 만든 perpDEX는 크립토에서 손꼽히는 성공 사례가 됐다. 실제로 웹3 시장에서 하이퍼리퀴드 이전과 이후는 꽤 다르다. 이전에는 그랜트 프로그램으로 킬러 앱을 외부에 기대서 만들었다면, 이후에는 팀이 직접 만들어서 증명하는 것이 기본 공식이 됐다.

이 흐름에 맞게 플루언트도 자체 서비스 프린트(Prints)를 만들고 있다. 프린트는 인터넷에 흩어진 “평판”을 한곳에 모아, 누가 진짜이고 누가 믿을 만한지를 증명하는 도구다. 쉽게 말하면 인포파이 시대의 평판 어그리게이터다. 여러 플랫폼에 흩어져 있는 평판 점수를 하나로 모아서 보여준다.

현재 에토스(Ethos) 신뢰 점수, 카이토(Kaito) 스마트 팔로워, 탤런트 프로토콜(Talent Protocol) 빌더 점수 등을 한 곳에서 활용한다. 이 중 어떤 지표든 하나뿐이라면 알고리즘을 속여 점수를 인위적으로 높이는 사람이 나타나기 마련이다. 하지만 하나는 속일 수 있어도 여러 개를 동시에 속이기는 훨씬 어렵다.

즉, 유저에게 프린트는 웹3 서비스에서의 평판 이력서다. 어떤 분야에서 신뢰를 쌓아왔는지를 한 페이지로 증명할 수 있다. 빌더에게는 자기 앱에 바로 통합할 수 있는 평판 도구다.

프린트 위에는 플루언트 커넥트(Fluent Connect)가 올라가 있다. 빌더가 프린트의 평판 데이터를 기반으로 원하는 조건의 유저를 찾고, 퍽스(Perks) 기능으로 얼리 액세스나 토큰 혜택을 직접 분배할 수 있는 서비스다. 쉽게 말해 빌더와 진짜 유저를 연결해주는 매칭 도구다.

이미 서드파티 활용 사례도 나오고 있다.

베나 파이낸스(Vena Finance)는 프린트 데이터를 활용해 평판 기반 금리를 도입하겠다고 발표했다. 평판이 높은 유저에게 더 유리한 조건으로 자본을 빌려주는 구조다. 현재 서비스가 출시되어 약 15,000명이 가입했고, 빌더 API는 개발 중이다.

다만 외부 서비스를 모아서 보여주는 구조인 만큼, 프린트 자체의 독자적인 평판 신호가 부족하다는 한계도 있다. 이를 보완하기 위해 플루언트는 자체 피드백 점수를 만들었고, 향후 예측 시장 성과, 수익률 큐레이터 실적, AI 에이전트 평판 등도 신호로 통합해 나갈 계획이다.

4. 플루언트의 생태계

하지만 프린트 역시도 이제 확장하는 단계고, 완전한 평판 시스템이 되기 위해서는 시간이 필요하다. 플루언트는 이 시간을 기다리기만 하지 않고, 생태계를 만들기 위해 외부 빌더 육성을 병렬로 진행하고 있다. 그 축이 블렌디드 빌더스 클럽(BBC)이라는 자체 액셀러레이터다.

첫 번째 코호트로 선발된 팀은 5개다.

펌프 팔스(Pump Pals): 소셜 트레이딩 플랫폼으로 커뮤니티와 함께 매매하는 경험 제공

스프라우트(Sprout): 자동 수익 최적화 플랫폼으로 유저 리스크 성향에 맞는 전략 자동 매칭

버징(Buzzing): 예측 시장 플랫폼으로 유저가 직접 마켓을 만들고 결과에 베팅

유미 파이낸스(Yumi Finance): 온체인 신용 인프라로 크립토 카드에 신용 평가를 붙여 후불 결제 지원

블렌드 머니(Blend Money): 온체인 저축 플랫폼으로 자국 통화 입금 시 수익 전략과 환헤지 자동 처리

이 중 펌프팔스, 스프라우트, 버징은 이미 테스트넷에서 유저 테스트를 마쳤다. 테스트넷 운영 방식도 눈여겨볼 부분이다. 대부분의 체인에서 테스트넷은 에어드랍 파밍 도구에 가깝다. 유저는 보상을 기대하며 의미 없는 트랜잭션을 반복하고, 팀은 부풀려진 지표를 실제 수요로 착각한다.

플루언트는 테스트넷의 목적 자체를 피드백 수집으로 잡았다. 유저가 남긴 피드백은 빌더 팀에 곧바로 전달되고, 빌더는 이를 바탕으로 제품을 고친다. 양질의 피드백을 남긴 유저는 프린트의 평판 점수에 반영돼, 이후 혜택에서 우선순위를 받는다. 앱도 한꺼번에 올리지 않고 몇 주 간격으로 하나씩 피처링해서, 각 팀이 집중적으로 피드백을 받을 수 있게 했다.

BBC 외에도 생태계 확장 사례가 나오고 있다. 네로나(Nerona)는 온체인 자산관리 플랫폼으로, 모바일 앱, 크립토 카드, 스테이블코인 수익, 렌딩을 하나로 묶는다. 기존에는 이 기능들이 전부 다른 서비스에 흩어져 있어서 자본이 놀고 있었다. 네로나는 이걸 한 곳에 모아 자본이 항상 일하게 만드는 구조다.

여기에 프린트의 평판 데이터가 결합되면, 유저의 신뢰도에 따라 금리나 서비스 조건을 차등 적용하는 것도 가능해진다. 앞서 소개한 베나 파이낸스의 평판 기반 금리와 같은 방향이다.

5. 마무리: 플루언트가 그리는 그림

플루언트는 세 가지를 동시에 만들고 있다.

첫째, 체인이다. 블렌디드 실행으로 EVM, SVM, Wasm 앱을 하나의 체인에서 조합할 수 있게 했다. 기술적 방향은 명확하고, EVM-Wasm 간 블렌디드 실행은 테스트넷에서 실제로 작동하고 있다. 다만 SVM 통합은 아직 최적화 단계이고, 메인넷 환경에서 세 VM이 안정적으로 돌아가는지는 검증이 남아 있다.

둘째, 프린트다. 여러 평판 신호를 한곳에 모아 교차 검증한다는 설계는 설득력이 있다. 하나의 지표는 속일 수 있어도 여러 개를 동시에 속이기는 어렵다는 논리다. 하지만 현재 통합된 신호의 수가 적고, 대부분 외부 서비스에 의존한다. 프린트가 자체적으로 평판을 생성하고 검증하는 단계까지 가는 과정을 지켜봐야 할 것이다.

셋째, 생태계다. BBC를 통해 빌더를 키우고, 베나 파이낸스와 네로나 같은 서비스가 평판을 금융 조건에 연결하려는 시도를 하고 있다. 아직 대부분 초기 단계거나 구상에 가깝기에 각 서비스가 실제 유저 획득을 어떻게 해나가는지 확인할 필요가 있다.

플루언트는 아직 초기 단계지만, 체인-서비스-생태계를 처음부터 하나의 구조로 설계하며 완성된 모습을 기대하게 한다. 테스트넷에서 블렌디드 실행이 실제로 작동하고, 프린트 기반 서비스들이 붙기 시작했다는 점에서 초기 실행력도 확인됐다.

지난 사이클에서 수십 개의 L2가 쏟아졌지만, 대부분은 성능 지표만 내세우다 유저 없는 빈 체인이 됐다. 플루언트가 이 패턴을 벗어날 수 있는지는 메인넷 이후 실제 유저 수와 온체인 활동이 말해줄 것이다.

🐯 More from Tiger Research

이번 리서치와 관련된 더 많은 자료를 읽어보세요.Disclaimer

이 보고서는 플루언트(Fluent)로부터 일부 원고료 지원을 받았으나, 신뢰할 수 있는 자료를 바탕으로 독립적인 조사를 통해 작성되었습니다. 하지만 이 보고서의 결론과 권고사항, 예상, 추정, 전망, 목표, 의견 및 관점은 작성 당시의 정보를 바탕으로 하며 예고 없이 변경될 수 있습니다. 이에 당사는 본 보고서나 그 내용을 이용함에 따른 모든 손실에 대해 책임을 지지 않으며 정보의 정확성, 완전성, 그리고 적합성을 명시적으로나 암시적으로 보증하지 않습니다. 또한 타인 및 타조직의 의견과 일치하지 않거나 반대될 수 있습니다. 이 보고서는 정보 제공의 목적으로 작성되었으며, 법률, 사업, 투자, 또는 세금에 관한 조언으로 간주되어서는 안 됩니다. 또한 증권이나 디지털 자산에 대한 언급은 설명을 위한 것일 뿐, 투자 권고나 투자 자문 서비스 제공을 제안하는 것이 아닙니다. 이 자료는 투자자나 잠재적 투자자를 대상으로 하지 않았습니다.

Terms of Usage

타이거리서치는 리포트의 공정 사용을 지지합니다. 이는 공익적 목적으로 콘텐츠를 인용하되 상업적 가치에 영향을 주지 않는 범위에서의 넓은 사용을 허용하는 원칙입니다. 공정 사용 규칙에 따라, 리포트를 사전 허가 없이 사용할 수 있으나, 타이거리서치 리포트를 인용 시에는 1) 출처로 ‘타이거리서치’를 분명히 밝히고, 2) 타이거리서치의 브랜드 가이드라인에 맞는 로고(Black/White)를 포함시켜야 합니다. 자료를 재구성하여 출판할 경우에는 별도의 협의가 요구됩니다. 사전 허가 없는 사용은 법적 조치를 초래할 수 있습니다.

]]>Key Takeaways

The payer is shifting from humans to AI agents, making payment infrastructure a central requirement for true autonomy

Big Tech, including Google AP2 and OpenAI Delegated Payment, is designing approval-based automated payment systems on top of existing platform infrastructure

Crypto, through ERC-8004 and x402, enables intermediary-free payment models using NFT-based identity and smart contracts

Big Tech prioritizes convenience and consumer protection, while crypto emphasizes user sovereignty and broader agent-level execution

The key question ahead is whether payments will be controlled by platforms or executed by open protocols

1. Payments Are No Longer Exclusive to Humans

Recently, “OpenClaw” drew attention. Unlike AI systems such as ChatGPT or Gemini that primarily retrieve and organize information, OpenClaw enables AI agents to execute tasks directly on a user’s local PC or server.

Through messaging platforms such as WhatsApp, Telegram, and Slack, users can issue commands, and the agent autonomously performs tasks including email management, calendar coordination, and web browsing.

Because it operates as open-source software and is not tied to a specific platform, OpenClaw functions more like a personal AI assistant. This architecture has attracted interest for its flexibility and user-level control.

However, a critical limitation remains. For AI agents to operate with full autonomy, they must be able to execute payments. At present, agents can search for products, compare options, and add items to a cart, but final payment authorization still requires human approval.

Historically, payment systems have been designed around human actors. In an AI agent–driven environment, this assumption no longer holds. If automation is to become fully autonomous, agents must be able to assess, authorize, and complete transactions independently within defined constraints.

In anticipation of this shift, both major technology firms and crypto-native projects have introduced technical frameworks over the past year aimed at enabling agent-level payments.

2. Big Tech: Agent Payments Built on Existing Infrastructure

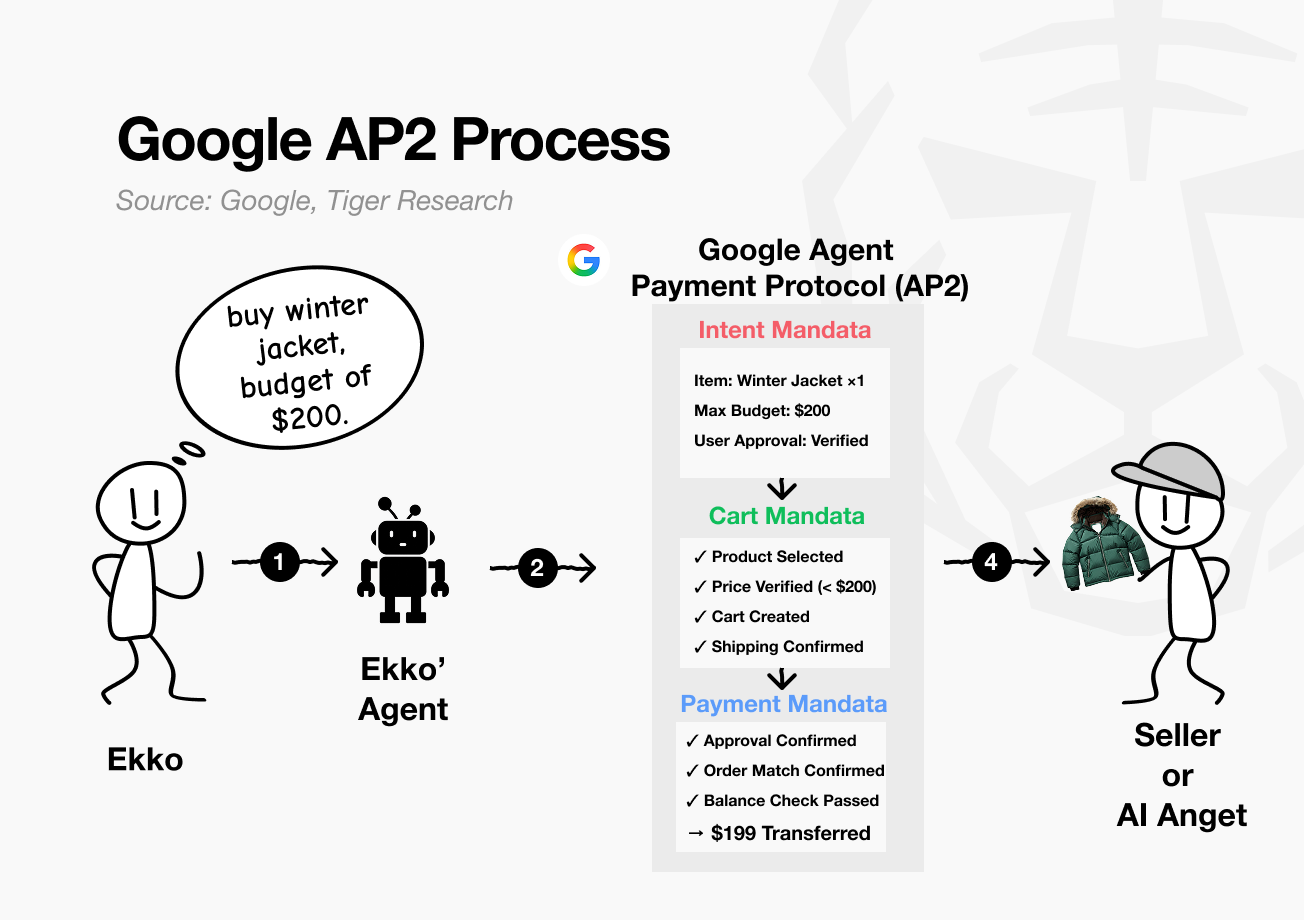

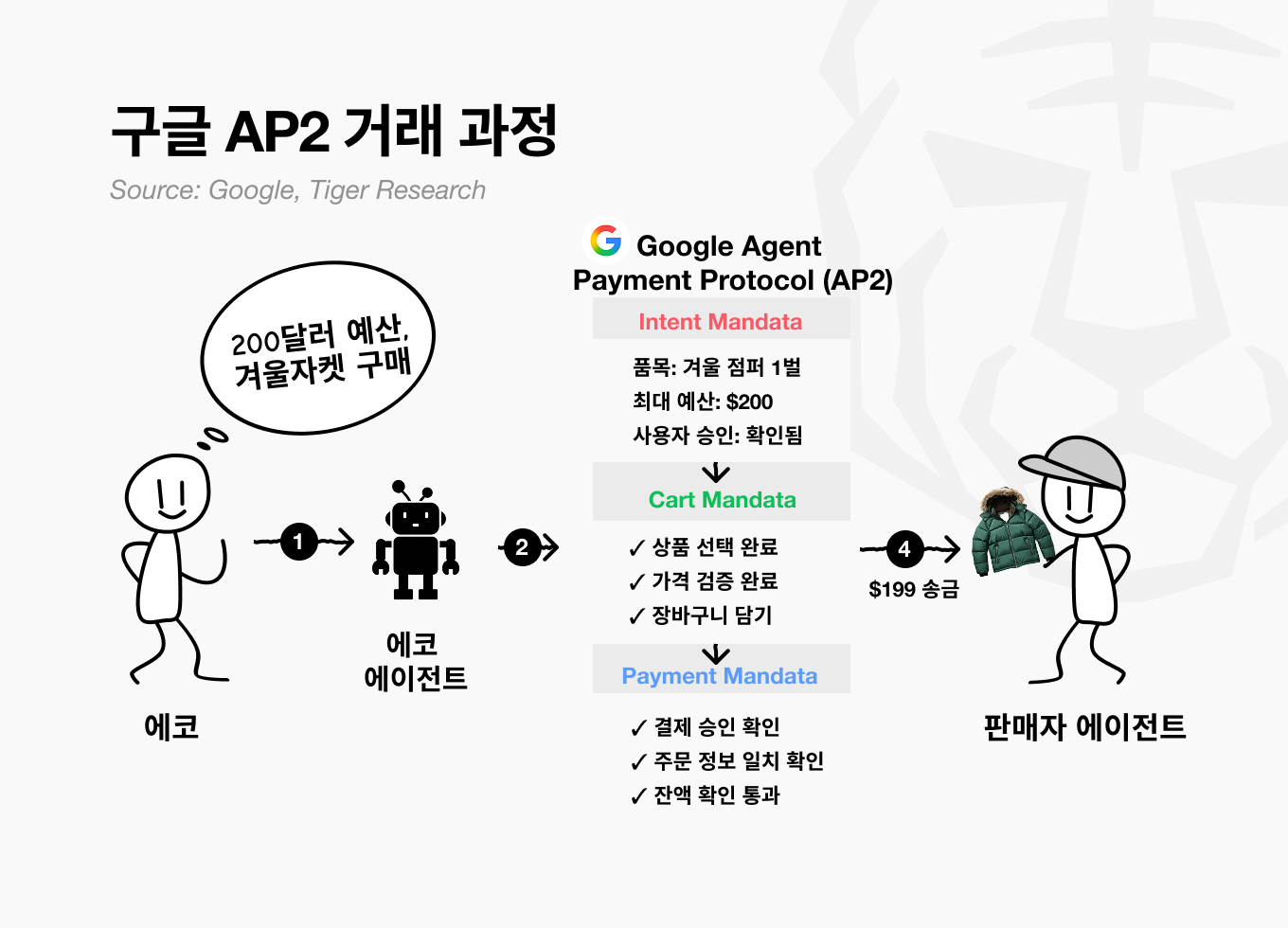

In January 2025, Google introduced AP2, Agent Payment Protocol 2.0, expanding its AI agent payment infrastructure. While OpenAI and Amazon have outlined related initiatives, Google is currently the only major firm with a structured implementation framework.

AP2 separates the transaction process into three mandate layers. This structure allows each stage to be monitored and audited independently.

Intent Mandate: Records what the user wants to do

Cart Mandate: Defines how the purchase should be executed under preset rules

Payment Mandate: Executes the actual transfer of funds

Assume Ekko asks an AI agent on Google Shopping to “find and purchase a winter jacket under $200.”

Intent Mandate: Ekko instructs the AI agent to purchase “one winter jacket with a maximum budget of $200.”

This information is recorded on-chain as a digital contract, referred to as the Intent Mandate.

Cart Mandate: The AI agent follows the stated intent, searches partner merchants for products that match “one winter jacket” and “maximum budget of $200,” and adds a qualifying item to the cart.

“Item selected: Winter jacket”, “Price verified: $199 (within budget ✓)”

“Added to cart”, “Shipping address confirmed.”

Payment Mandate: Ekko reviews the item selected by the AI agent and clicks the payment approval button. The $199 is processed through Google Pay. Alternatively, the AI agent may complete the payment automatically within predefined parameters.

Throughout this process, the user does not need to input additional information. In the case of Google AP2, the system operates on top of Google Pay and utilizes pre-registered card details and shipping addresses. Because AP2 relies on existing user credentials, it reduces onboarding friction and simplifies adoption.

However, Google currently supports agent-based payments only for companies within its partner network. As a result, usage remains confined to a controlled ecosystem, limiting broader interoperability and open access.

3. Crypto: Self-Custody and Open Exchange

Crypto is also developing payment infrastructure for AI agents, but the approach differs from that of Big Tech. While large platforms build trust within controlled ecosystems, crypto begins with a different question: can AI agents be trusted without relying on a central platform?

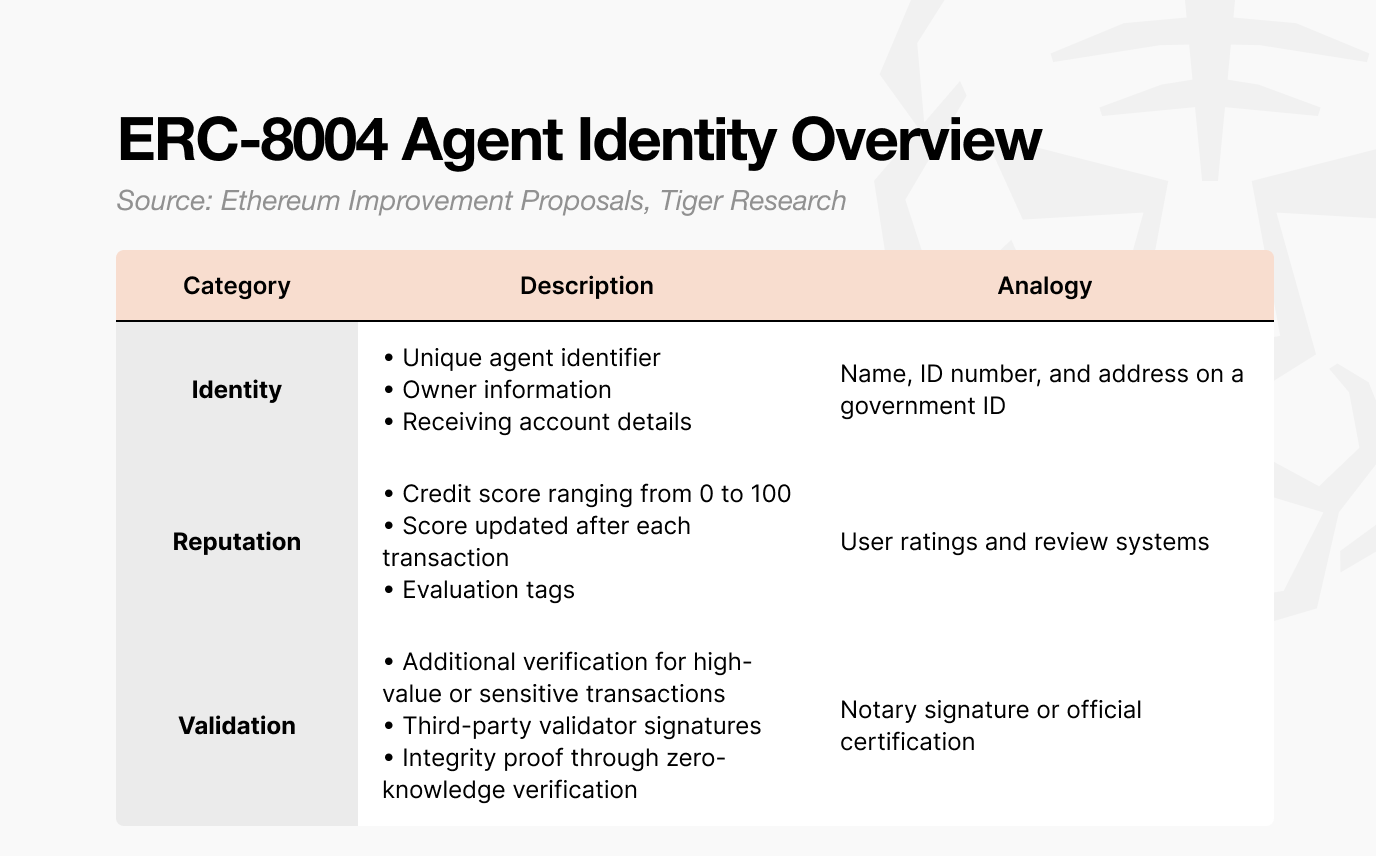

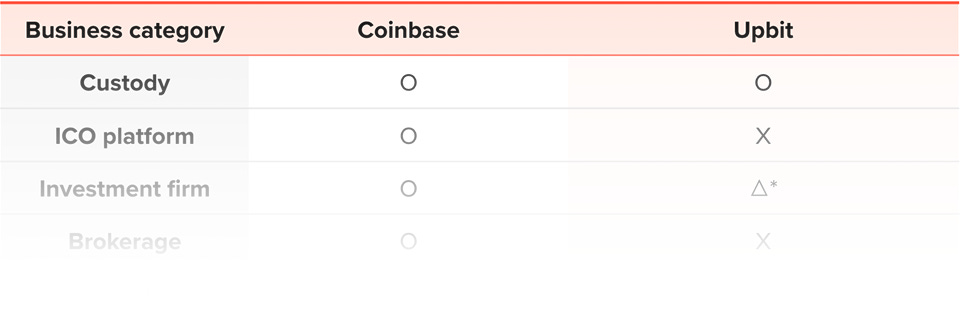

Two core standards aim to address this objective: Ethereum’s ERC-8004 and Coinbase’s x402.

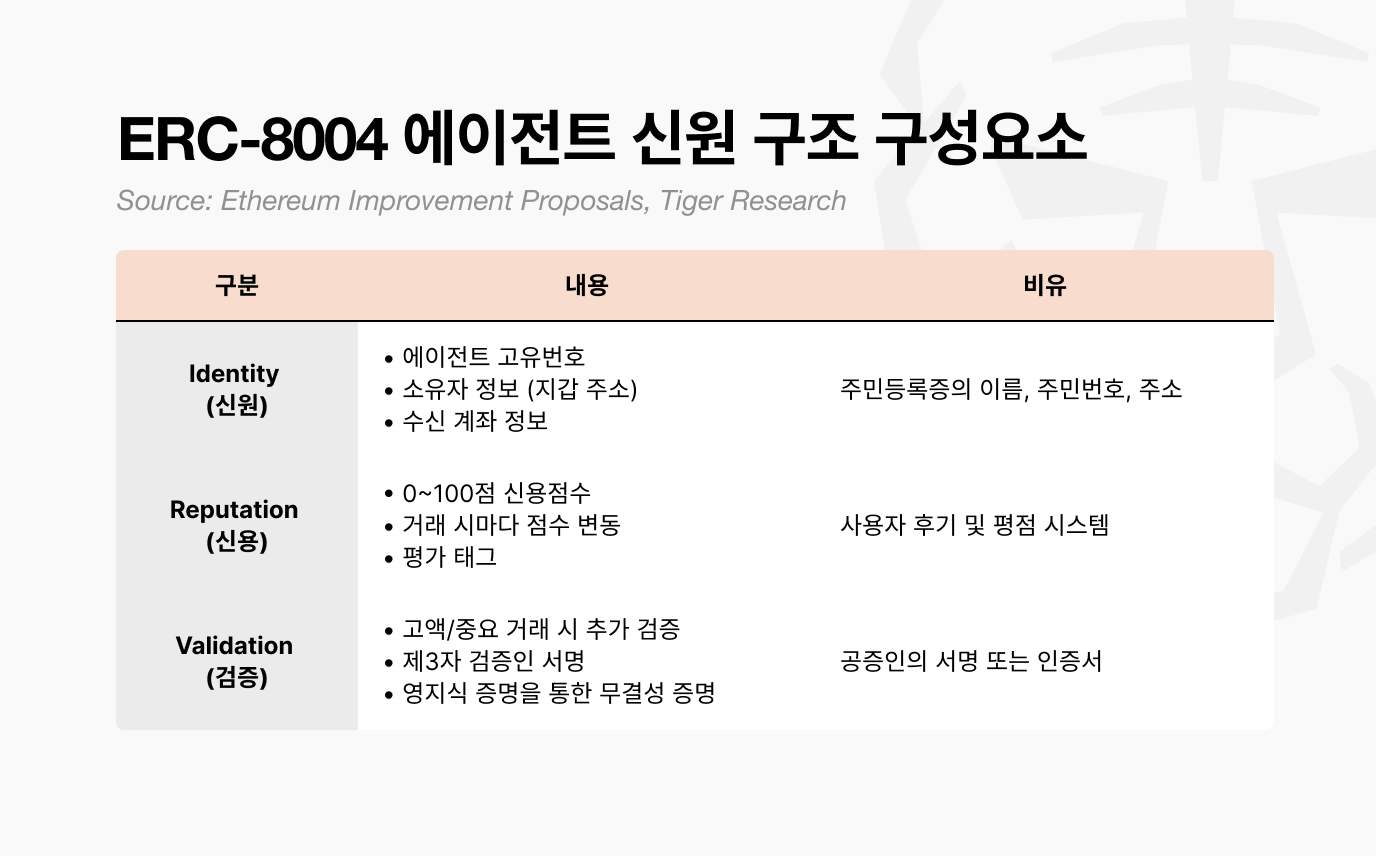

First, consider the identity layer. Just as users require an ID to access digital services, AI agents operating on blockchain networks must also be identifiable. ERC-8004 serves this function.

It is issued as an NFT, not as a media-based collectible. Instead, it is a credential NFT that contains structured identity data. Each token includes three components:

Identity

Reputation

Validation

Together, these elements function as a verifiable on-chain identity certificate.

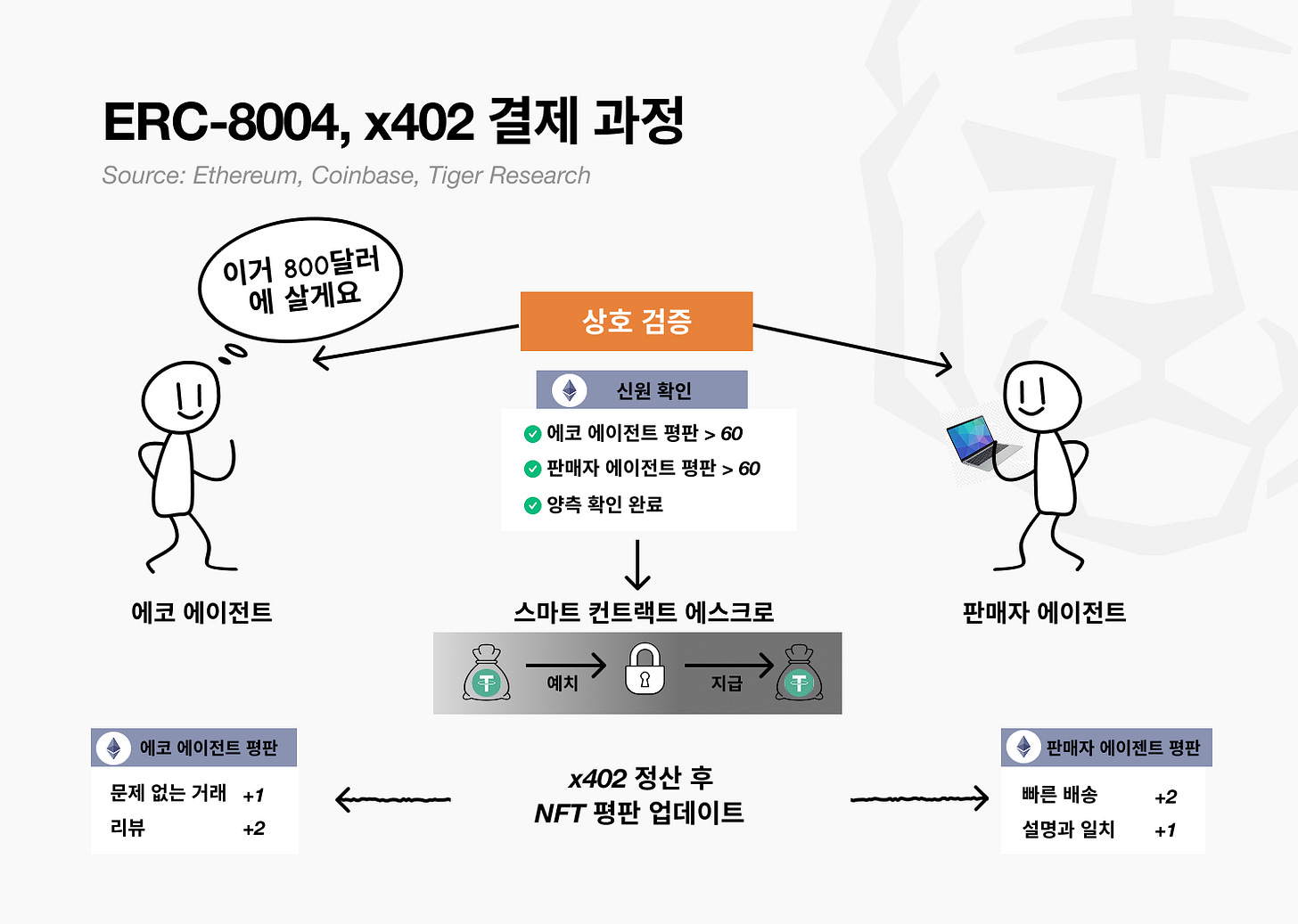

In online commerce, participants review ratings and transaction history before engaging with a counterparty. The same logic applies to AI agents. ERC-8004 provides agents with verifiable credentials, allowing other agents to assess whether a transaction is appropriate based on transparent data.

However, identity alone does not enable value transfer. A payment mechanism is required for funds to move. That role is fulfilled by x402.

If ERC-8004 functions as a digital identity card, x402 operates as the payment rail. Developed by Coinbase, x402 is a crypto-native payment standard for AI agents. It enables agents to transact autonomously in stablecoins.

Its core feature is automated smart contract execution. Conditional logic such as automatic transfer upon fulfillment of predefined criteria is embedded directly in code. Once conditions are met, settlement occurs without human intervention.

When ERC-8004 for identity and x402 for payment are combined, AI agents can verify counterparties and execute transactions without relying on a central platform. Trust and settlement are handled at the protocol level rather than through platform control.

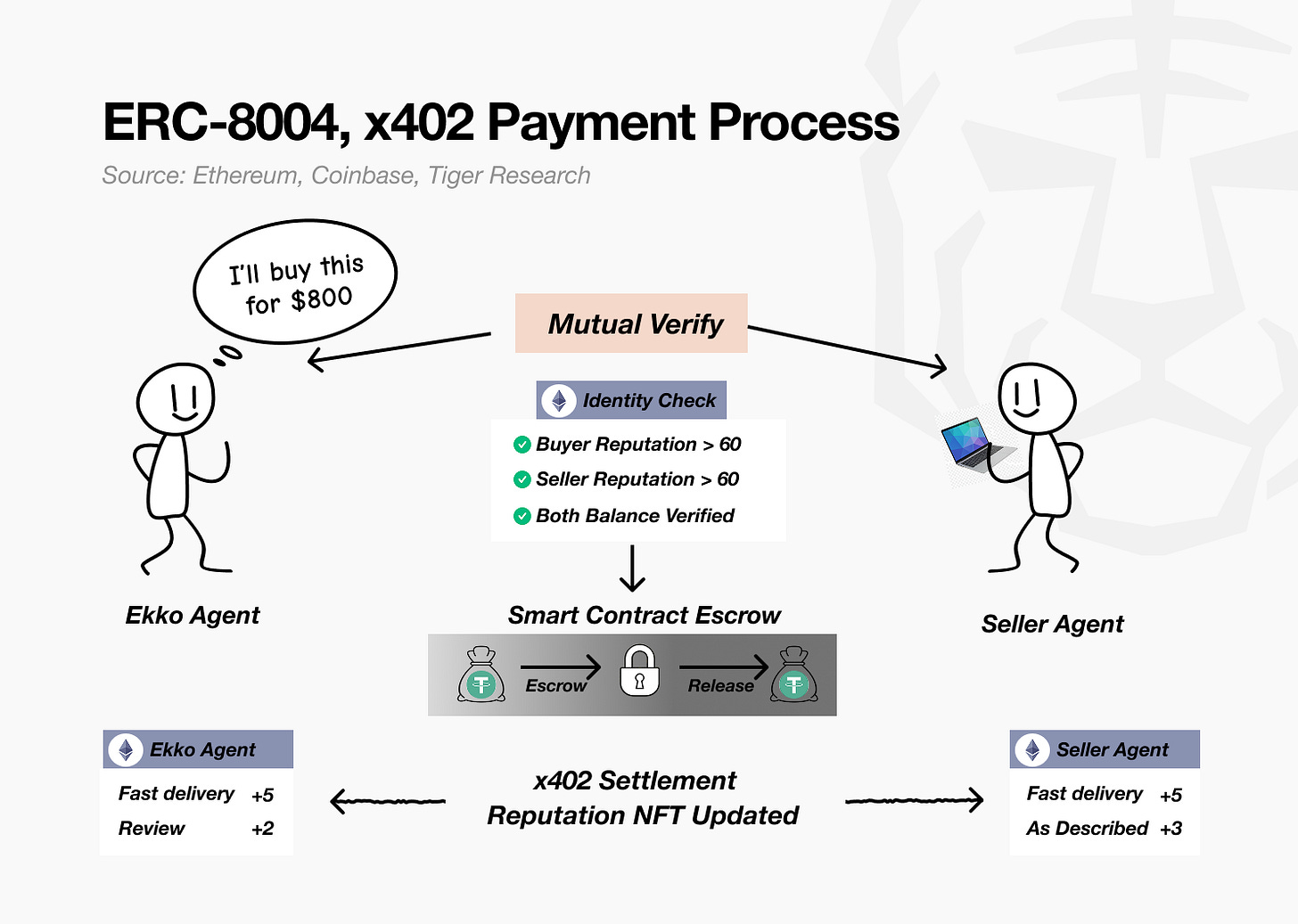

Assume a near-future AI agent environment.

Ekko instructs his AI agent (Agent A) to purchase a used laptop with a maximum budget of $800. The marketplace operates its own AI agent (Agent B), which communicates directly with Ekko’s agent to execute the transaction.

Mutual Verification

Before the transaction, both agents verify each other’s credentials and confirm that the product meets the specified requirements.

* Identity Check: Verification via ERC-8004 NFT

* Ekko’s agent: Reputation score 72, $800 balance confirmed

* Seller’s agent: Reputation score 70, qualifying laptop inventory confirmed

→ Result: Both agents approved for the transactionSmart Contract Escrow

Once verification is complete, the transaction proceeds. Each agent interacts through the x402 protocol to transfer and confirm funds.

* Escrow: $800 is transferred from Ekko’s agent wallet to a smart contract

* Conditional Hold: Funds remain locked until delivery confirmation

→ Release: Upon confirmation of delivery, $800 is automatically transferred to the sellerSettlement and Reputation Update(x402 Settlement & Reputation NFT Updated)

After settlement, both agents’ reputation records are updated.

* Ekko’s agent: Reputation 72 → 80 (+5 Fast delivery, +3 As described)

* Seller’s agent: Reputation 70 → 78 (+5 Fast delivery, +3 As described)

→ The updated evaluation records are written to each agent’s ERC-8004 NFT

Throughout this process, no intermediary is involved. No platform approval is required. The two AI agents transact directly through blockchain-based verification and settlement. This reflects the crypto-native model for agent-to-agent commerce.

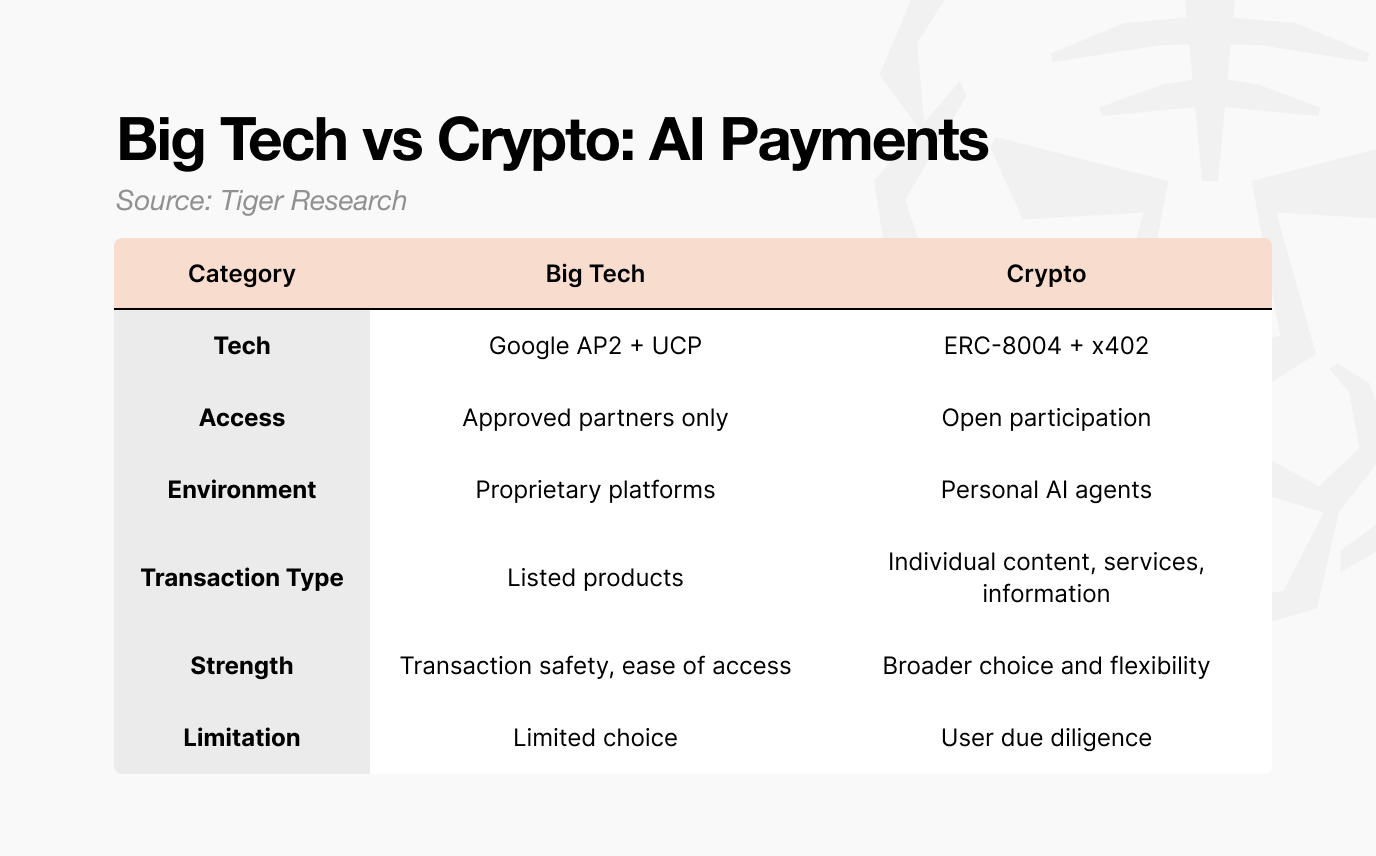

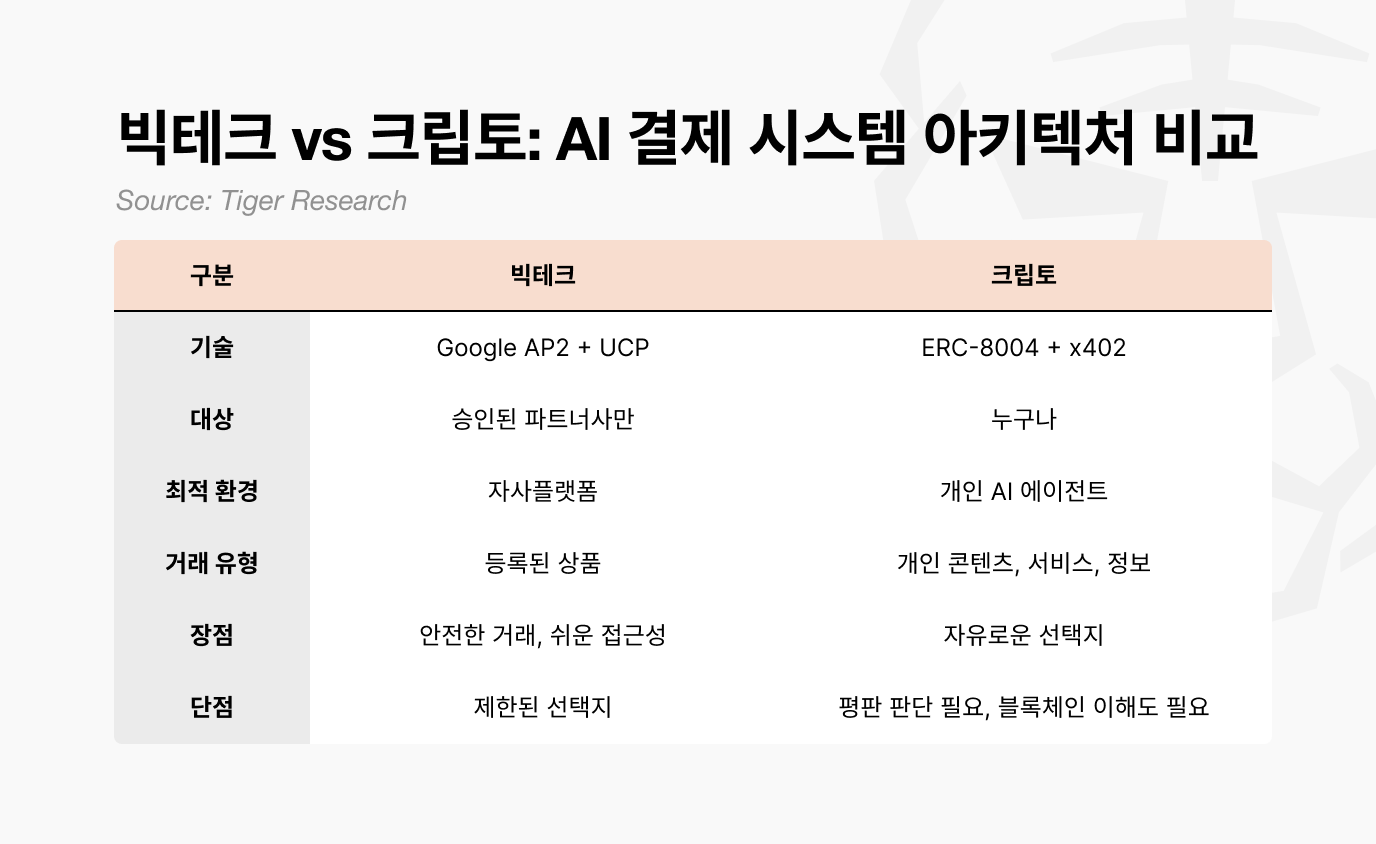

4. Big Tech vs Crypto: Diverging Operational Domains for AI Agents

Google AP2 represents a controlled model designed for approved partners.

Google limits marketplace participation to vetted merchants, citing consumer protection. Even with a structured mandate framework, agent behavior cannot be fully guaranteed. Unlike deterministic systems where input and output are directly matched, AI agent execution introduces probabilistic outcomes.

If an agent connects to an unreliable partner and a transaction error occurs, liability may ultimately fall on the payment infrastructure provider. To reduce even a marginal failure probability, such as 0.01 percent, Google has an incentive to narrow its ecosystem.

A restricted ecosystem improves stability and oversight. However, it may also limit the agent’s ability to operate autonomously across broader markets and optimize across a wide range of options.

In contrast, ERC-8004 and x402 reflect a more open architecture. The crypto model is designed to be permissionless and interoperable rather than platform-bound.

AI agents remain in an early stage of development. End-to-end execution, from complex request to autonomous payment, is not yet seamless.

However, the anticipated long-term scenario involves agents independently managing routine consumption. For example, a user may instruct an agent to restock groceries, and the agent would assess inventory gaps and complete purchases automatically.

Large platforms may attempt to aggregate major retail channels to support this model within a unified environment. This approach could enable reliable, everyday use cases within a controlled framework.

However, integrating all potential counterparties, including small online merchants, independent websites, decentralized finance protocols, and trading venues, presents structural limits for a closed ecosystem.

In addition, if digital content increasingly shifts toward paid access models, agents may need to execute high-frequency microtransactions.

Open crypto standards may offer structural advantages. For example, an AI agent could purchase 1,000 creator-generated images at $0.01 per unit or pay $1 to access a research article. For small-denomination, programmable payments, crypto-native rails may offer operational efficiency.

That said, the absence of a central authority introduces trade-offs. Identity evaluation standards must be established in a decentralized manner, and no single entity bears ultimate responsibility for failure. Balancing openness with accountability remains a key design challenge that will depend on both technical maturity and usability improvements.

In summary, both Big Tech and crypto pursue the same objective: enabling autonomous AI agent commerce. The distinction lies in architecture. Big Tech favors closed, controlled systems, while crypto advances open, protocol-based models.

Rather than a zero-sum outcome, the more plausible trajectory is interoperability between the two approaches. Continued development must prioritize reliability and user experience at the current stage of technical progress.

🐯 More from Tiger Research

Read more reports related to this research.Disclaimer

This report has been prepared based on materials believed to be reliable. However, we do not expressly or impliedly warrant the accuracy, completeness, and suitability of the information. We disclaim any liability for any losses arising from the use of this report or its contents. The conclusions and recommendations in this report are based on information available at the time of preparation and are subject to change without notice. All projects, estimates, forecasts, objectives, opinions, and views expressed in this report are subject to change without notice and may differ from or be contrary to the opinions of others or other organizations.

This document is for informational purposes only and should not be considered legal, business, investment, or tax advice. Any references to securities or digital assets are for illustrative purposes only and do not constitute an investment recommendation or an offer to provide investment advisory services. This material is not directed at investors or potential investors.

Terms of Usage

Tiger Research allows the fair use of its reports. ‘Fair use’ is a principle that broadly permits the use of specific content for public interest purposes, as long as it doesn’t harm the commercial value of the material. If the use aligns with the purpose of fair use, the reports can be utilized without prior permission. However, when citing Tiger Research’s reports, it is mandatory to 1) clearly state ‘Tiger Research’ as the source, 2) include the Tiger Research logo. If the material is to be restructured and published, separate negotiations are required. Unauthorized use of the reports may result in legal action.

]]>Key Takeaways

결제의 주체가 인간에서 AI 에이전트로 이동하고 있으며, 진정한 자율성을 위해 결제 인프라가 핵심 이슈로 부상

빅테크(Google AP2, OpenAI Delegated Payment)는 기존 플랫폼 인프라 위에서 승인 기반 자동 결제 구조를 설계

크립토(ERC-8004 + x402)는 NFT 신원과 스마트 컨트랙트를 통해 중개자 없는 분산 결제 모델을 구현

빅테크는 편리함과 소비자 보호를, 크립토는 사용자 주권과 에이전트 활용 범위를 중심 가치로 둠

향후 핵심 쟁점은 “플랫폼이 통제하는 결제인가, 프로토콜이 실행하는 결제인가”에 달려 있음

1. 결제는 더 이상 인간의 것만이 아니다

최근 “OpenClaw”가 화제였다. 이는 챗GPT나 제미니처럼 단순히 검색한 정보를 정리해주는 AI와는 달랐다.

OpenClaw는 사용자의 개인 PC나 서버에서 직접 실행되어 AI 에이전트가 실제로 작업을 수행할 수 있게 했다. 메신저 어플인 왓츠앱, 텔레그램, 슬랙과 같은 메신저 플랫폼을 통해 명령을 내리면, 에이전트가 자율적으로 이메일 관리, 일정 조정, 웹 브라우징 등의 작업을 처리한다.

이는 특정 플랫폼에 종속되지 않고 오픈소스로 제공되어, 마치 개인 AI 비서처럼 작동하면서 사람들의 관심을 끌었다.

그런데 AI 에이전트가 정말로 자율적으로 작동하려면 한 가지 문제가 남아 있다. 바로 결제다. 현재 에이전트는 상품을 검색하고 비교하며 장바구니까지 담을 수 있지만, 실제 결제 승인은 여전히 사람의 손을 거쳐야 한다.

왜냐하면 지금까지 결제 시스템의 주체는 사람이었기 때문이다. 하지만 모든 것이 자동화되는 AI 에이전트 시대에는, 에이전트가 스스로 판단하고 결제하는 완전한 자율성이 필요하다.

이러한 미래를 대비해 작년부터 빅테크 기업과 크립토 기업이 기술들을 발표하면서 준비하고 있다.

2. 빅테크: 기존 인프라 위에 쌓은 에이전트 결제

2025년 1월, 구글이 AP2(Agent Payment Protocol 2.0)를 발표하며 본격적인 AI 에이전트 결제 인프라를 확장하기 시작했다. 물론, 오픈AI와 아마존 등이 있으나 실질적인 움직임을 보이는 곳은 구글이 유일하다.

세부적으로 구글의 AP2는 각 과정을 나눠 어떤 단계에서 문제가 발생했는지 확인하기 위해 세 가지 위임(Mandate) 구조를 가진다.

Intent Mandate(의도): 사용자가 “뭘 하고 싶은지” 기록

Cart Mandate(장바구니): “어떻게 살지” 정해진 규칙

Payment Mandate(결제) : “돈이 실제로 움직이는” 곳

예시로 Ekko가 구글 쇼핑에서 AI 에이전트에게 “200달러 이하 겨울 재킷 찾아서 사줘”라고 요구했다 가정하자.

Intent Mandate: 에코가 AI 에이전트에게 “겨울 재킷 1개, 최대 예산 $200”을 요구한다.

해당 정보가 디지털 계약서(Intent Mandate)로 블록체인에 기록됨

Cart Mandate: AI 에이전트는 에코의 의도에 따라 “겨울 재킷 1개”, “최대 예산 $200”에 맞춰 파트너 회사들이 판매하는 상품 중에서 조건에 맞는 상품을 찾아 장바구니에 담는다.

“상품 선택됨: 겨울 재킷”, “가격 확인: $199 (예산 이하 ✓)”

“장바구니 담기 완료”, “배송지 확인됨”

Payment Mandate: 에코는 AI 에이전트가 담아 놓은 상품을 보고 결제 승인 버튼을 누른다. 그러면 $199의 금액이 Google Pay에서 결제된다. 혹은 AI 에이전트가 자동으로 결제한다.

위 과정 속에서 유저는 별도의 정보를 입력할 필요가 없다. 구글 AP2의 경우 구글 페이를 기반으로 작동해, 이미 등록된 카드 정보, 배송지 주소 등을 활용할 수 있다. 결국 AP2는 이미 등록한 사용자 정보를 기반으로 작동하기 때문에 유저 온보딩에 용이한 장점이 있다.

하지만 구글은 자사에서 파트너십을 맺은 기업에게만 에이전트 결제를 지원하고 있어, 제한된 범위 내에서만 활용할 수 있다는 제약점이 존재한다.

3. 크립토: 자기 소유와 자유로운 거래

크립토 역시 빅테크처럼 AI 에이전트 결제 기술을 개발하고 있다. 하지만 접근 방식이 다르다. 빅테크가 자사 플랫폼 내에서 신뢰를 구축한다면, 크립토는 “중앙 플랫폼 없이도 AI 에이전트를 신뢰할 수 있을까?”라는 문제에서 출발했다.

그 목적을 구현하기 위한 두 가지 핵심 표준이 있다. 이더리움의 “ERC-8004“와 코인베이스의 “x402“이다.

먼저 신원 문제부터 살펴보자. 일반적으로 서비스를 사용하기 위해서는 ID가 필요하듯, 블록체인에서도 AI 에이전트를 식별할 방법이 필요하다. 이때, ERC-8004는 에이전트의 신원 역할을 한다. NFT 형태로 발급되지만, 우리가 아는 그림 파일 NFT가 아니라 신원 정보를 담은 NFT다.

이 NFT는 1) Identity(신원) 2) Reputation(신용) 3) Validation(검증)의 세 가지 정보가 포함되어, 일종의 신원 증명서가 된다.

온라인에서 누군가와 거래할 때 우리는 상대방의 평점과 후기를 확인한다. “이 판매자를 신뢰할 만한가?”를 판단하는 것이다. AI 에이전트도 마찬가지다. ERC-8004는 에이전트에게 검증 가능한 신원을 부여해서, 다른 에이전트가 “이 에이전트와 거래해도 안전한가?”를 판단할 수 있게 한다.

하지만 신분증만 있다고 거래가 되는 건 아니다. 실제로 돈이 오가려면 결제 시스템이 필요하다. 그게 x402다. ERC-8004가 신분증이라면, x402는 결제 단말기다.

x402는 코인베이스가 만든 AI 에이전트 암호화폐 결제 표준이다. 구글 AP2의 크립토 확장 버전으로, 에이전트가 스테이블코인으로 자율적으로 결제할 수 있게 한다. 핵심은 스마트 계약 자동 실행이다. “조건 충족 시 자동 송금”이라는 규칙이 코드로 박혀 있어서, 사람 개입 없이도 거래가 즉시 완료된다.

ERC-8004(신원)와 x402(결제)가 결합되면, AI 에이전트는 중앙 플랫폼 없이도 에이전트 간에 서로 신뢰하고 자율적으로 거래할 수 있다.

앞으로 다가올 AI 에이전트 시대를 엿보는 상황을 가정해보자.

Ekko는 최대 800달러의 상한선을 두고 중고 노트북을 구매하라고 자기의 AI 에이전트(A)에게 명령했다. 이제 쇼핑몰에서 만든 AI 에이전트(B)는 Ekko의 AI 에이전트와 서로 소통하며 구매를 진행한다.

상호 검증(Mutual Verify)

거래 전, 양쪽 에이전트(A, B)가 서로 평판과 상세 요구사항에 맞는 상품을 보유했는지를 검증한다.

* Identity Check: ERC-8004 NFT로 신원 확인

* Ekko 에이전트 신용점수 72점 ✓ $800 보유 ✓

* 판매자 에이전트 신용점수 70점 ✓ 가성비 좋은 노트북 보유 ✓

→ 결과: 양쪽 모두 거래 가능 판정스마트 계약 에스크로(Smart Contract Escrow)

검증이 완료되면 거래가 진행된다. 각 AI 에이전트는 x402 프로토콜을 통해 금액을 보내거나 확인한다.

* Escrow: Ekko 에이전트 지갑에서 $800이 스마트 계약(중간 금고)으로 이동

* 조건 대기: “노트북 배송 완료”라는 조건이 충족될 때까지 보관

→ Release: 배송 확인되면 자동으로 판매자에게 $800 송금결제 완료 및 평가 업데이트(x402 Settlement & Reputation NFT Updated)

거래가 완료되면 AI 에이전트 평판이 업데이트된다.

* Ekko 에이전트: Reputation 72점 → 80점 (+5 Fast delivery, +3 As described)

* 판매자 에이전트: Reputation 70점 → 78점 (+5 Fast delivery, +3 As described)

→ 평가 기록이 각자의 ERC-8004 NFT에 업데이트 됨

이 모든 과정에서 중개자가 없다. 플랫폼 승인도 필요 없다. AI 에이전트 둘이 블록체인을 통해 직접 거래한다. 이것이 크립토가 추구하는 AI 에이전트 간 거래 프로세스다.

4. 빅테크 vs 크립토: 서로 다른 AI 에이전트 활동 영역

빅테크의 대표주자인 구글 AP2는 승인된 파트너사를 위한 시스템이다.

구글은 소비자 보호를 이유로 승인된 파트너만 입점시킨다. 에이전트의 행동 경로는 위임(Mandate) 구조를 만든다고 해도 이를 100% 보장할 수 없다. 기존 시스템과 달리 요청에 따른 결과가 1:1로 매칭되는 구조가 아닌 것이다.

만약 결과값이 보장되지 않은 파트너사와 연결됐을 때, 오류로 인해 잘못된 결제가 일어난다면 이는 결국 결제 시스템을 제공한 구글의 책임이 된다. 때문에 에이전트가 구동하는 중에 오류가 발생하는 단 0.01%의 확률이라도 줄이기 위해 생태계를 좁힐 수밖에 없는 것이다.

좁은 생태계의 장점 역시도 안정성이지만 보다 AI 에이전트가 자율적으로 행동하고 많은 선택지에서 최선의 결과값을 가져오는 데에는 한계가 있을 수밖에 없다.

반면 크립토의 ERC-8004, x402는 모두를 위한 시스템에 가깝다.

현재 AI 에이전트는 여전히 발전 단계에 있고 a-z 단계 요청부터 결제까지 처리는 어렵다. 하지만 모두가 예상하는 미래는 마치 영화와 같이 출근하며 나의 AI 에이전트에게 장을 보라고 주문하면 냉장고 안에 부족한 재료를 알아서 고민해서 사오는 미래이다.

물론 이러한 미래까지 빅테크, 구글은 핵심적인 소매 사이트를 모두 통합해서 모두가 만족할 수 있는 일상적 사용을 독려할 것이다.

하지만 빅테크에서 일반 소매 판매자, 혹은 작은 인터넷 사이트, 나아가서는 DeFi, 트레이딩 등등 수많은 것들을 모두 고려해서 결제 파트너사에 통합하는 것은 한계가 있다. 또한 지난 리포트에서 언급한 것과 같이 웹사이트가 사라지고 모든 정보가 유료가 되는 시대에는 에이전트가 마이크로 결제를 시도해야 할 수도 있다.

이런 경우에는 오픈소스에 가까운 크립토 표준이 채택되는 것이 합리적이다.

예를 들어, 웹사이트 개발을 맡기면 나의 AI 에이전트는 개인 크리에이터가 만든 이미지를 1,000장을 장당 $0.01에 구매하거나, 리서치 글을 한 편 읽는데 $1의 비용을 납부하는 등에는 도입과 결제 단위 모두 크립토 표준이 편리할 수 있다.

다만 위에서 언급한 것과 같이 신원 평가의 기준을 각자가 마련해야하며 중앙화된 주체가 없기에 이를 책임지는 주체 역시 없다는 것이 제약이 될 수 있다. 이는 기술의 발전과 사용성이 발맞춰 가며 중간점을 찾아야 할 이슈로 보인다.

정리하자면, 빅테크와 크립토는 같은 목적을 갖고 미래를 대비하고 있으나 현실에 따라 폐쇄형과 개방형의 차이를 두고 있다. 어느 한 진영이 승리하는 미래보다는 조화롭게 두 진영이 연결될 것으로 보이며, 현재 기술 수준에서 지속적으로 사용성을 고려하며 개발해야 할 것으로 생각된다.

🐯 More from Tiger Research

이번 리서치와 관련된 더 많은 자료를 읽어보세요.Disclaimer

이 보고서는 신뢰할 수 있는 자료를 바탕으로 작성되었습니다. 그러나 정보의 정확성, 완전성, 그리고 적합성을 명시적으로나 암시적으로 보증하지 않습니다. 당사는 본 보고서나 그 내용을 이용함에 따른 모든 손실에 대해 책임을 지지 않습니다. 이 보고서의 결론과 권고사항, 예상, 추정, 전망, 목표, 의견 및 관점은 작성 당시의 정보를 바탕으로 하며 예고 없이 변경될 수 있습니다. 또한 타인 및 타조직의 의견과 일치하지 않거나 반대될 수 있습니다. 이 보고서는 정보 제공의 목적으로 작성되었으며, 법률, 사업, 투자, 또는 세금에 관한 조언으로 간주되어서는 안 됩니다. 또한 증권이나 디지털 자산에 대한 언급은 설명을 위한 것일 뿐, 투자 권고나 투자 자문 서비스 제공을 제안하는 것이 아닙니다. 이 자료는 투자자나 잠재적 투자자를 대상으로 하지 않았습니다.

타이거리서치 리포트 이용 안내

타이거리서치는 리포트의 공정 사용을 지지합니다. 이는 공익적 목적으로 콘텐츠를 인용하되 상업적 가치에 영향을 주지 않는 범위에서의 넓은 사용을 허용하는 원칙입니다. 공정 사용 규칙에 따라, 리포트를 사전 허가 없이 사용할 수 있으나, 타이거리서치 리포트를 인용 시에는 1) 출처로 ‘타이거리서치’를 분명히 밝히고, 2) 타이거리서치 로고를 포함시켜야 합니다. 자료를 재구성하여 출판할 경우에는 별도의 협의가 요구됩니다. 사전 허가 없는 사용은 법적 조치를 초래할 수 있습니다.

]]>Key Takeaways

AI is already part of daily life, but users overlook how their data passes through central servers

Even CISA’s acting director unknowingly exposed classified documents to ChatGPT

Nesa restructures this by transforming data before transmission (EE) and splitting it across nodes (HSS-EE) so no single party ever sees the original

Academic validation (COLM 2025) and live enterprise deployment (P&G) give Nesa a head start

Whether the broader market adopts decentralized privacy AI over familiar centralized APIs remains the key question

1. Is Your Data Safe?

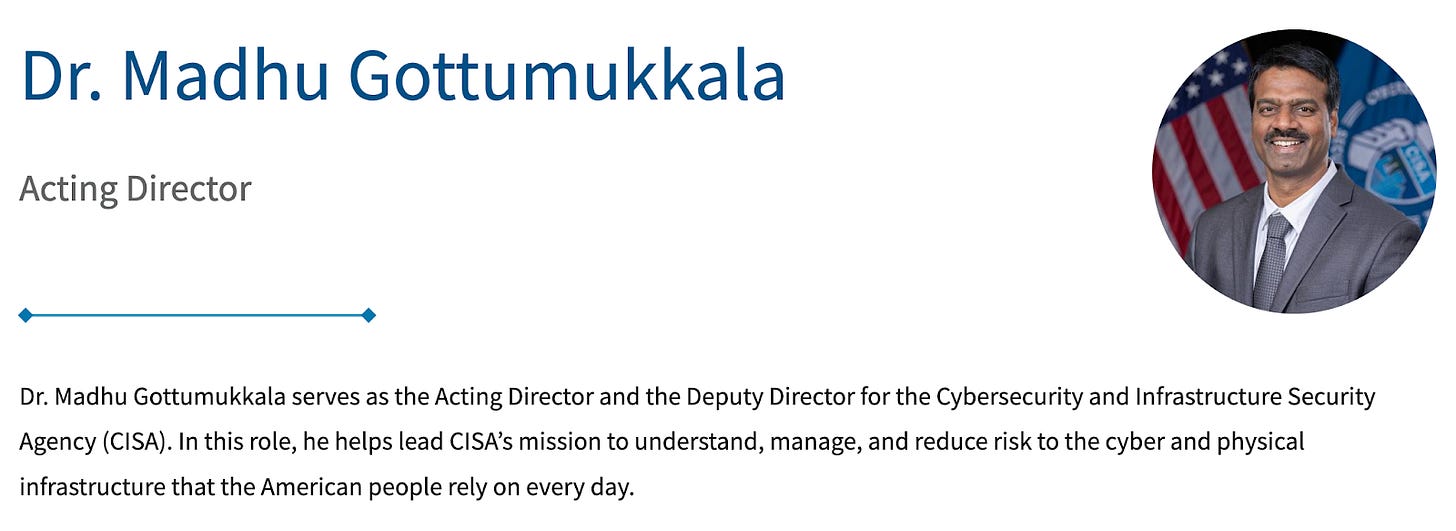

In January 2026, Madhu Gottumukkala, Acting Director of CISA, the lead U.S. cybersecurity agency, uploaded sensitive government documents to ChatGPT simply to summarize and organize contract-related files.

The breach was not detected by ChatGPT or reported to the government by OpenAI. It was flagged by the agency’s own internal security systems, leading to an investigation for violating security protocols.

Even America’s top cybersecurity official was using AI routinely, to the point of uploading classified material.

We know. Most AI services store user input on central servers in encrypted form. But this encryption is reversible by design. Data can be decrypted and disclosed under valid warrants or emergency circumstances, and users have no visibility into what happens behind the scenes.

2. Privacy AI for Everyday Use: Nesa

AI is already part of daily life. It summarizes articles, writes code, and drafts emails. The real concern is that, as shown in the previous case, even classified documents and personal data are being handed to AI with little awareness of the risk.

The core problem is that all of this data passes through the service provider’s central servers. Even when encrypted, the decryption keys are held by the provider. How can users trust that arrangement?

User input data can be exposed to third parties through multiple channels: model training, safety reviews, and legal requests. On enterprise plans, organization admins can access chat logs. On personal plans, data can still be turned over under a valid warrant.

Now that AI is deeply embedded in everyday life, it is time to ask serious questions about privacy.

Nesa is a project designed to change this structure entirely. It builds a decentralized infrastructure that enables AI inference without entrusting data to a central server. User input is processed in an encrypted state, and no single node can view the original data.

3. How Nesa Solves This

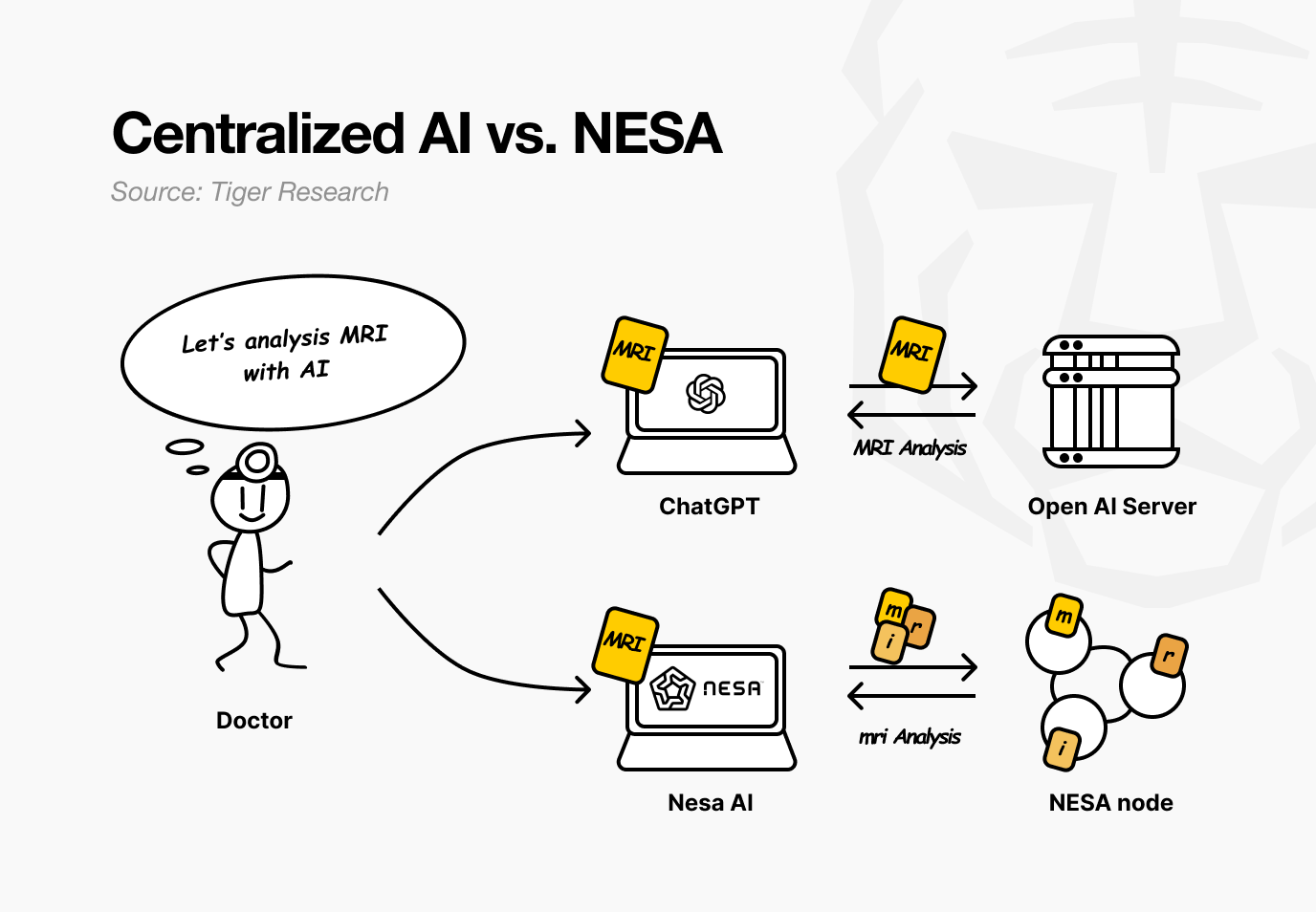

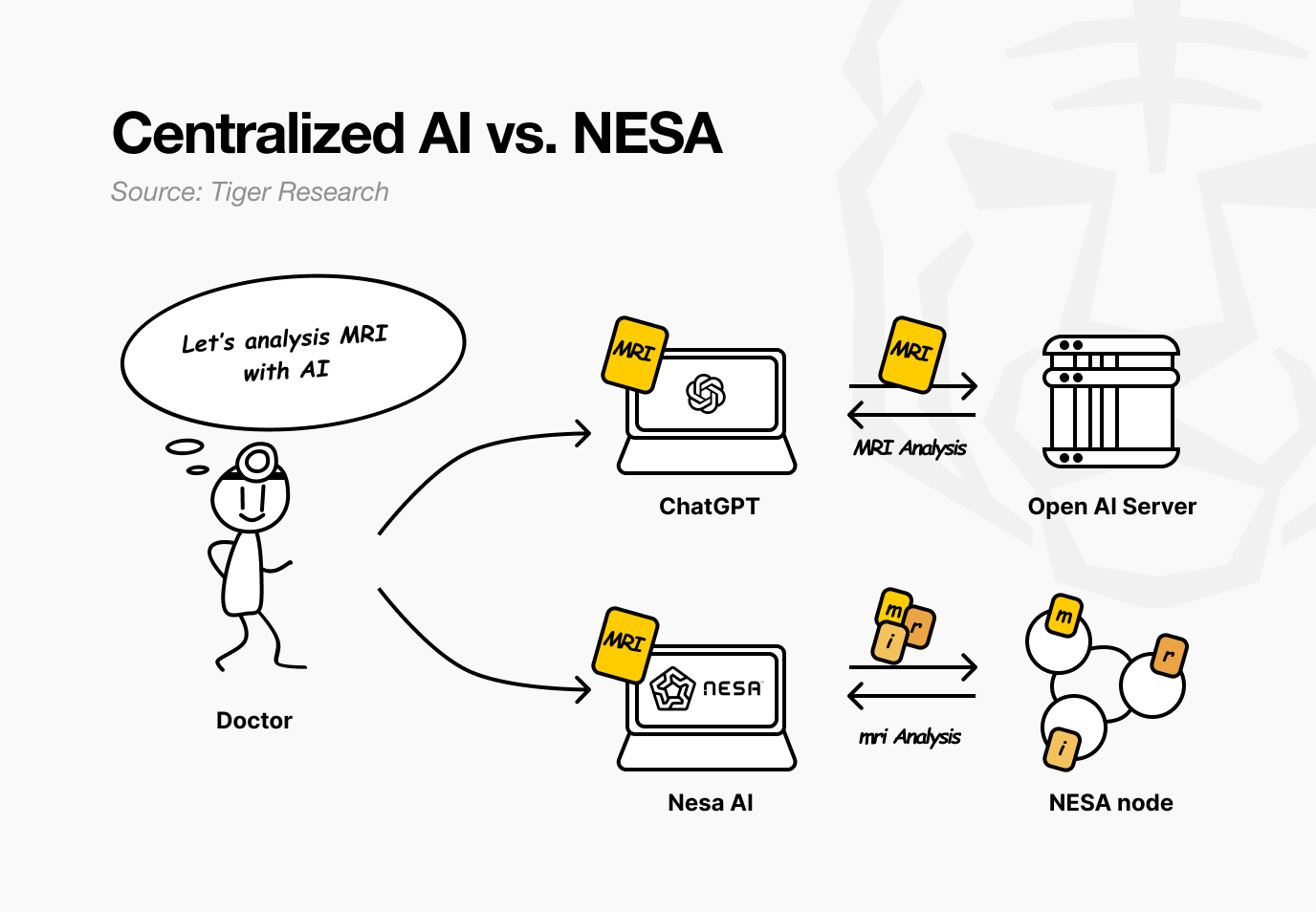

Imagine a hospital using Nesa. A doctor wants an AI to analyze a patient’s MRI for tumors. With current AI services, the image is sent directly to OpenAI or Google servers.

With Nesa, the image is mathematically transformed before it ever leaves the doctor’s computer.

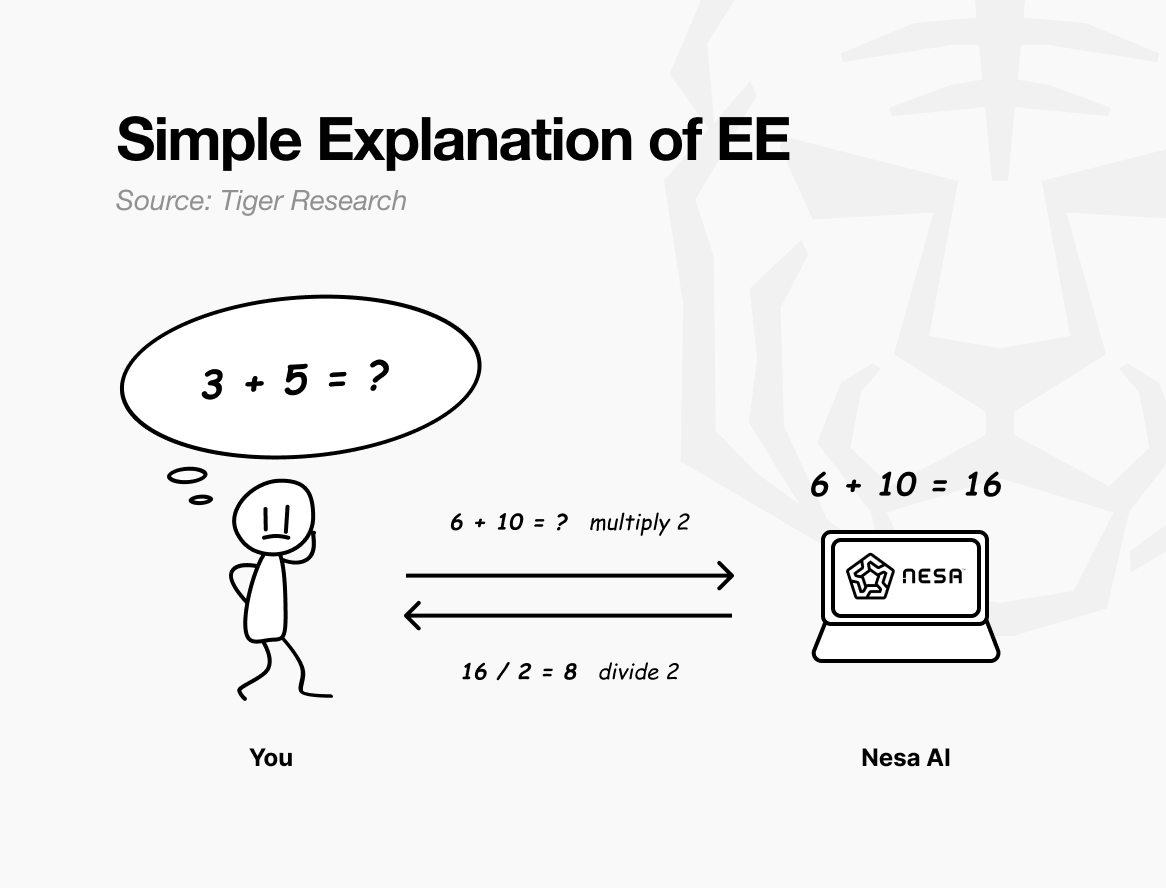

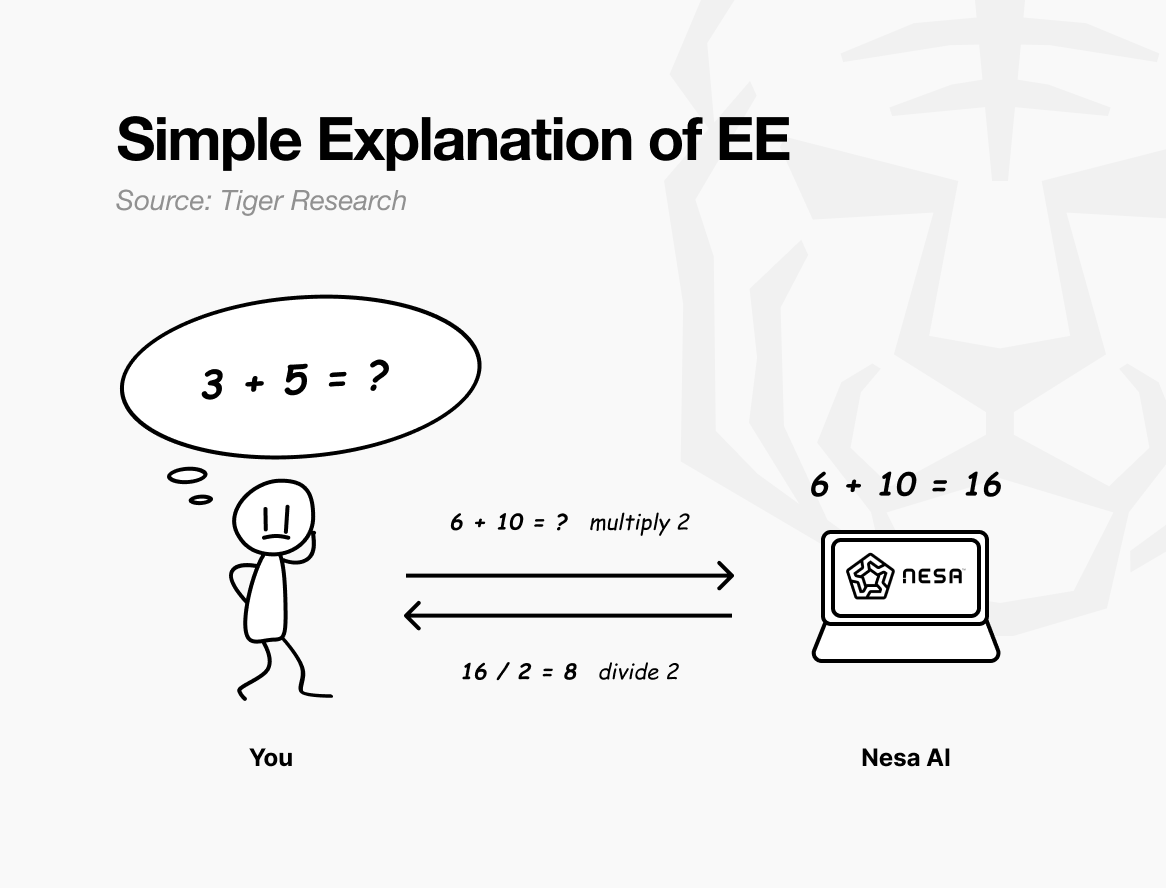

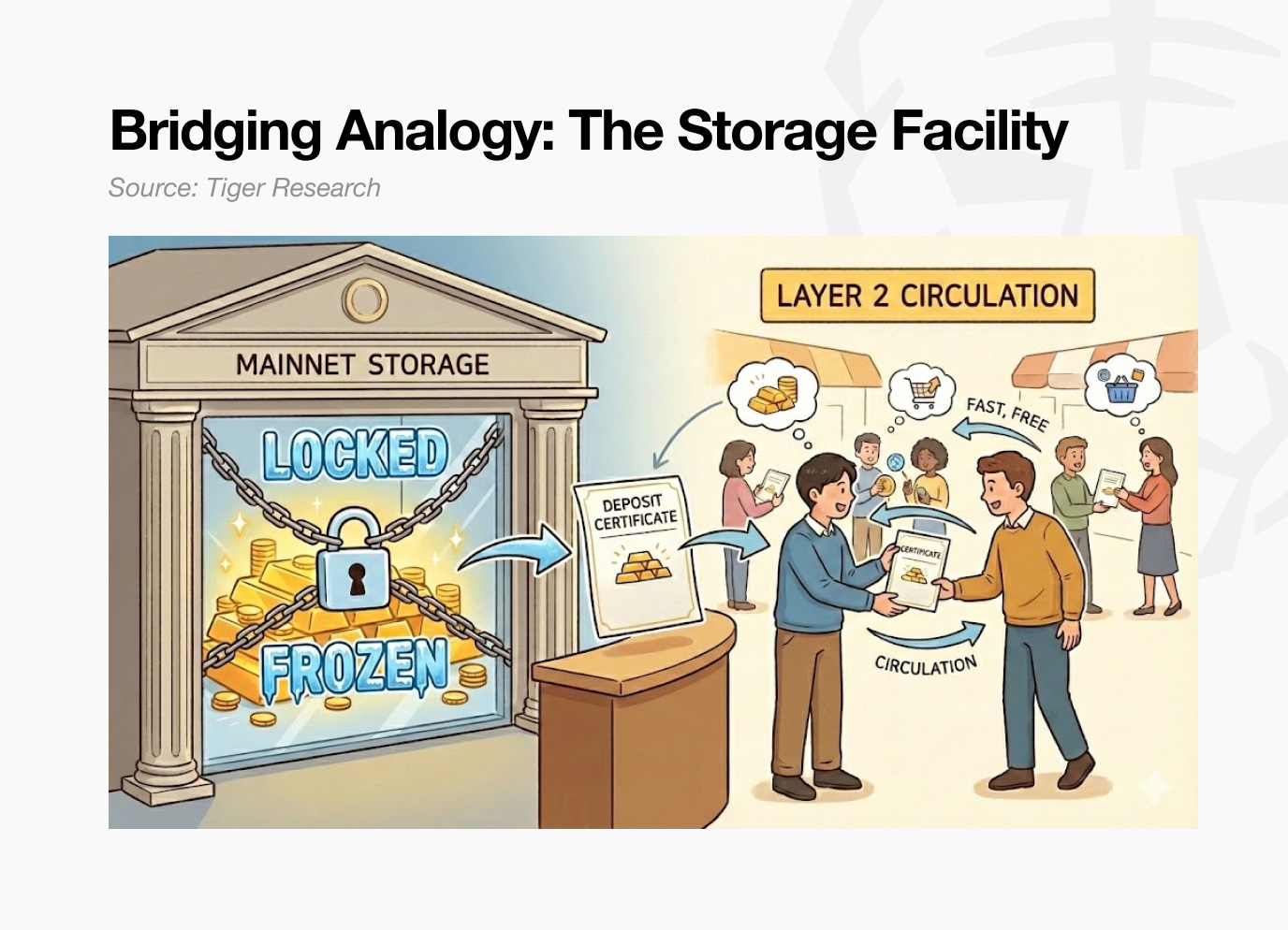

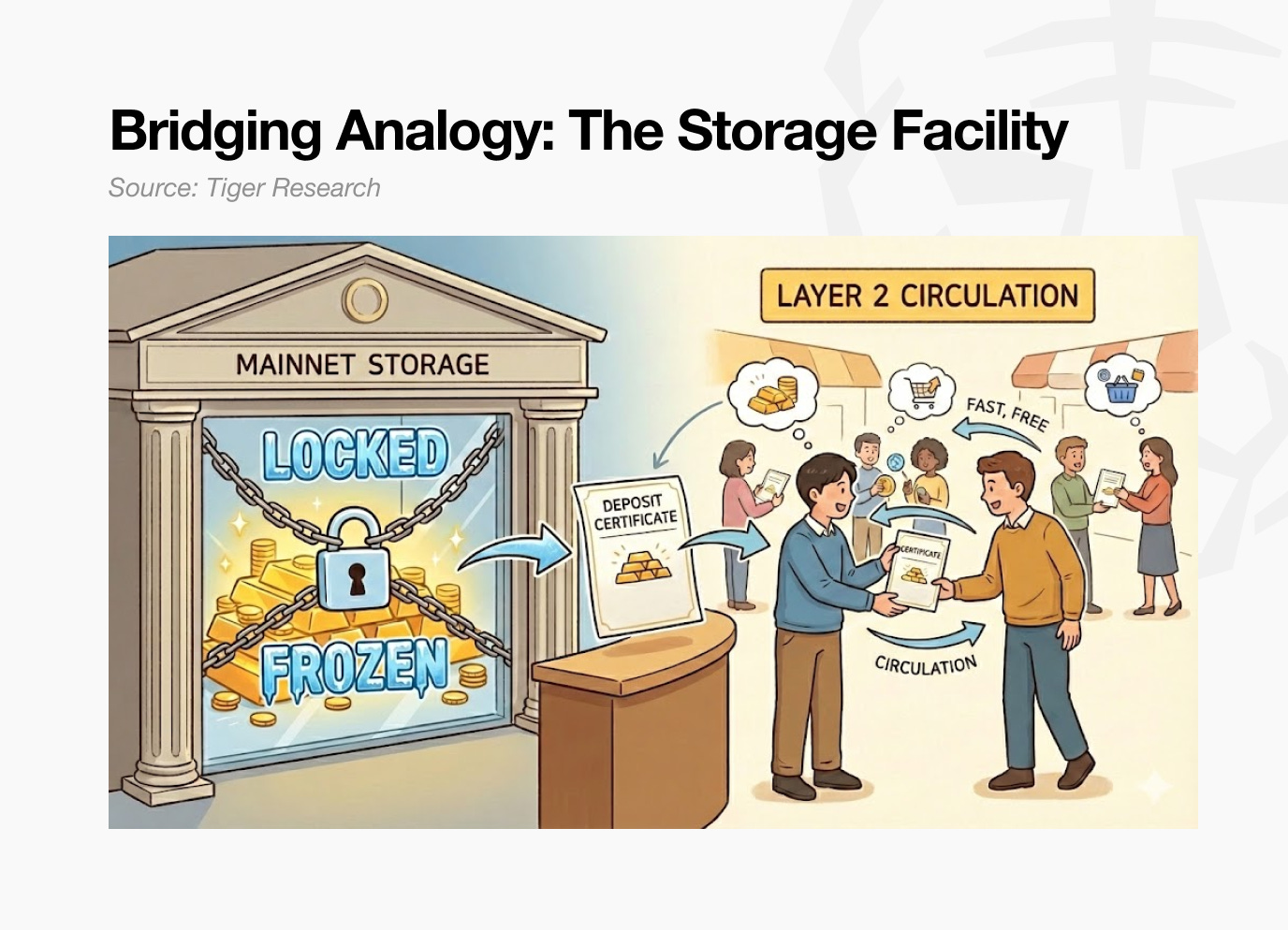

A simple analogy: suppose the original problem is “3 + 5 = ?” If you send it as is, the recipient knows exactly what you are calculating.

But if you multiply every number by 2 before sending, the recipient sees “6 + 10 = ?” and returns 16. You divide by 2 and get 8, the same answer as solving the original. The recipient performed the computation but never learned your original numbers were 3 and 5.

This is exactly what Nesa’s Equivariant Encryption (EE) does. Data is mathematically transformed before transmission. The AI model computes on the transformed data.

The user applies the inverse transformation and gets the same result as if the original data had been used. In mathematics, this property is called equivariance: whether you transform first or compute first, the final result is identical.

In practice, the transformation is far more complex than simple multiplication. It is tailored to the internal computation structure of the AI model. Because the transformation aligns with the model’s processing flow, accuracy is not compromised.

Back at the hospital, the doctor notices no difference. The workflow of uploading an image and receiving a result stays the same. What changes is that no node in between can see the patient’s original MRI.

Nesa goes one step further. EE alone prevents any node from viewing the original data, but the transformed data still exists in full on a single server.

HSS-EE (Homomorphic Secret Sharing over Encrypted Embeddings) splits even the transformed data.

Return to the analogy. EE was applying a multiplication rule before sending the exam sheet. HSS-EE tears that transformed sheet in half, sending the first part to Node A and the second part to Node B.

Each node solves only its own fragment. Neither can see the full problem. Only when both partial answers are combined does a complete result emerge, and only the original sender can perform that recombination.

In summary, EE transforms data so the original cannot be seen. HSS-EE splits even the transformed data so it never exists in one place. Privacy protection is layered twice.

4. Does Privacy Mean Slower Performance?

Stronger privacy means slower performance. This has been a long-standing rule in cryptography. Fully Homomorphic Encryption (FHE), the most widely known approach, is 10,000 to 1,000,000 times slower than standard computation. It is unusable for real-time AI services.

Nesa‘s Equivariant Encryption (EE) works differently. Returning to the math analogy, the cost of applying x2 before sending and ÷ 2 after receiving is minimal.

Unlike FHE, which converts the entire problem into a fundamentally different mathematical system, EE adds only a lightweight transformation on top of existing computations.

Performance benchmarks:

EE: less than 9% latency increase on LLaMA-8B, with accuracy matching the original at over 99.99%.

HSS-EE: 700 to 850 milliseconds per inference on LLaMA-2 7B.

On top of this, MetaInf, a meta-learning scheduler, optimizes efficiency across the network. It evaluates model size, GPU specifications, and input characteristics to automatically select the fastest inference method.

MetaInf achieved 89.8% selection accuracy and a 1.55x speedup over conventional ML-based selectors. It was published at the COLM 2025 main conference, providing academic validation.

The figures above are from controlled test environments. However, Nesa’s inference infrastructure is already deployed in real enterprise settings, confirming production-level performance.

5. Who Uses It and How

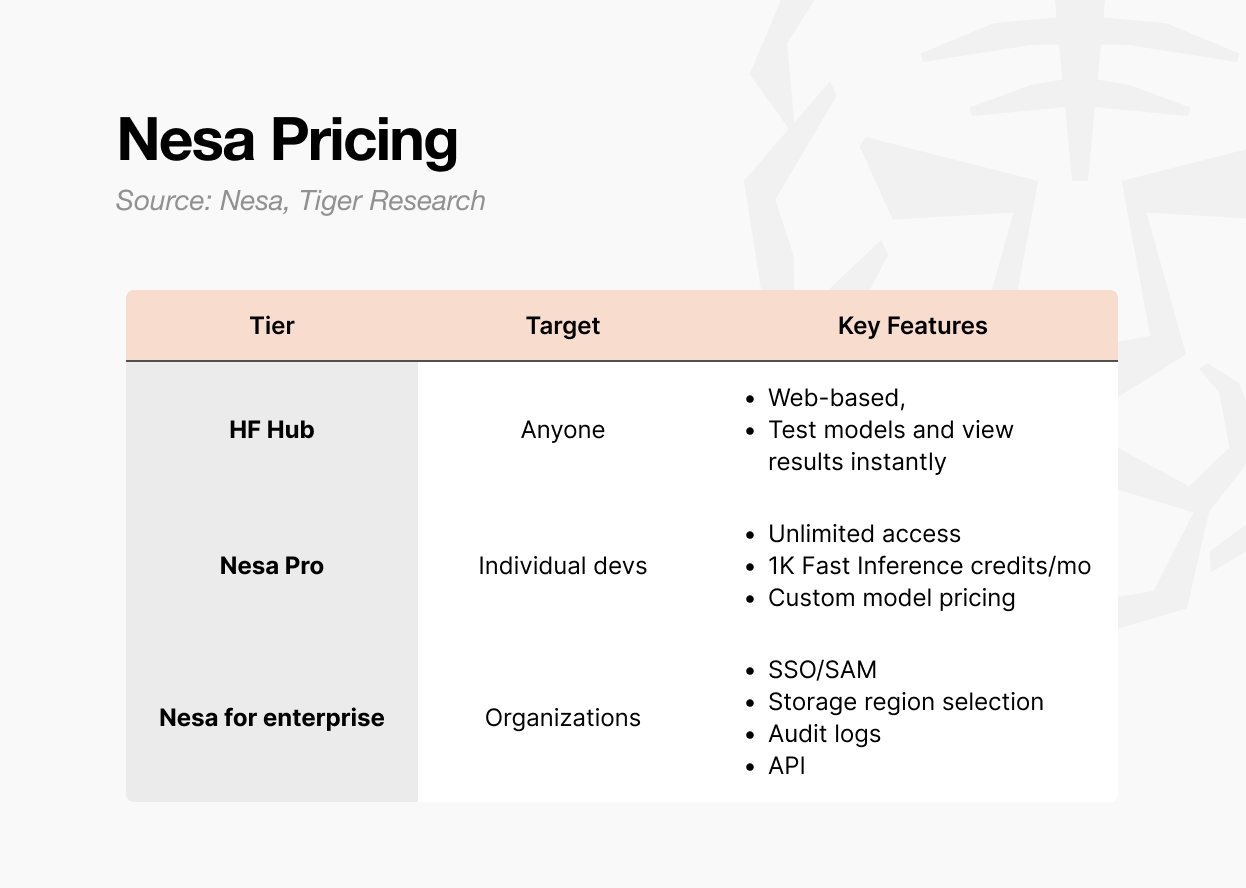

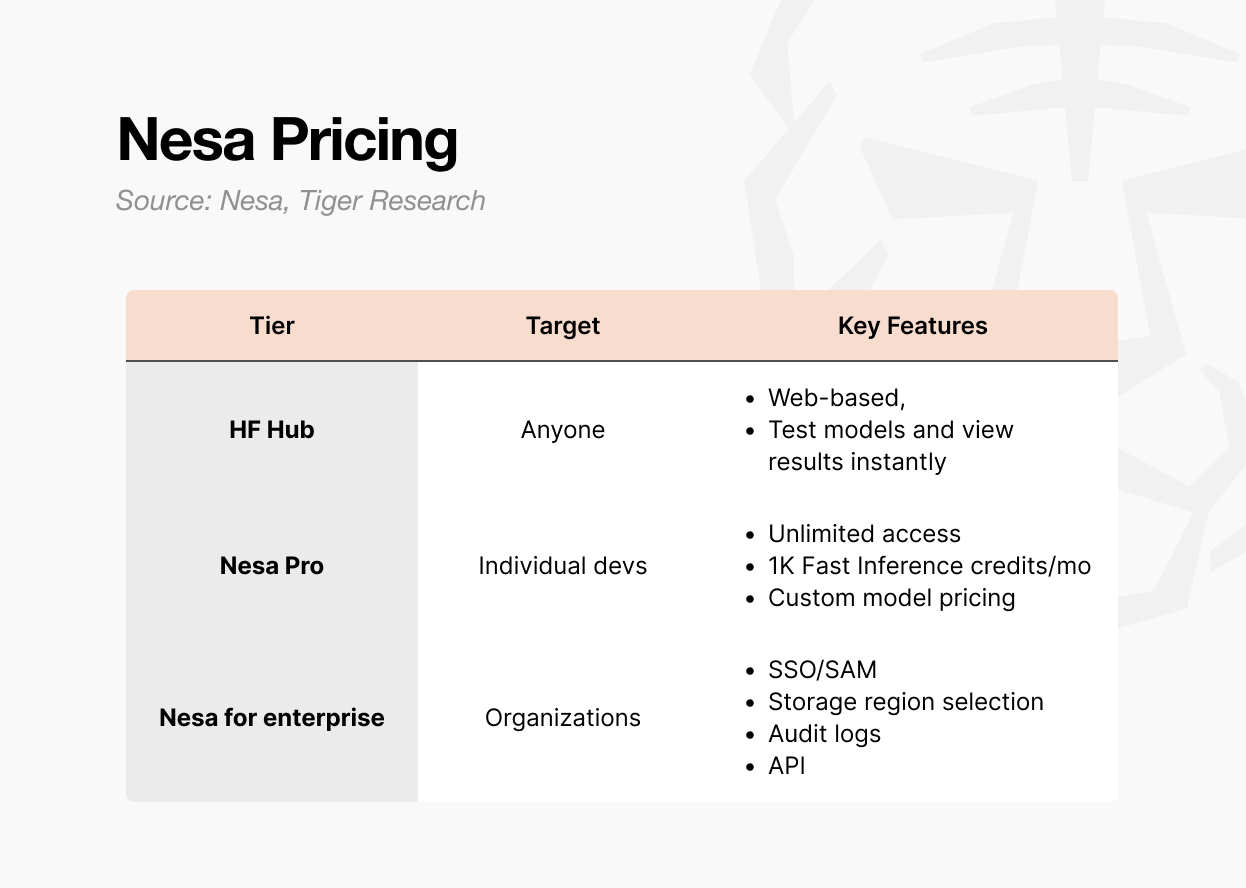

There are three ways to access Nesa.

First is the Playground. Users can select and test models directly on the web. No developer background is required. It allows hands-on experience with inputting data and viewing results per model.

It is the fastest path to see how decentralized AI inference actually works.

Second is the Pro subscription. At $8 per month, it includes unlimited access, 1,000 Fast Inference credits per month, custom model pricing controls, and featured page visibility for models.

This tier is designed for individual developers or small teams looking to deploy and monetize their own models.

Third is Enterprise. This is not a public pricing plan but a custom contract structure. It includes SSO/SAML support, selectable data storage regions, audit logs, granular access controls, and annual-commitment billing.

Pricing starts at $20 per user per month, but actual terms are negotiated based on scale. It is built for organizations integrating Nesa into internal AI pipelines, with API access and organization-level management provided through a separate agreement.

In short: Playground for exploration, Pro for individual or small-team development, Enterprise for organizational deployment.

6. Why a Token Is Needed

A decentralized network has no central administrator. The entities running servers and verifying results are distributed around the world. This raises a natural question: why would anyone keep their GPU running to process someone else’s AI inference?

The answer is economic incentive. In the Nesa network, that incentive is the $NES token.

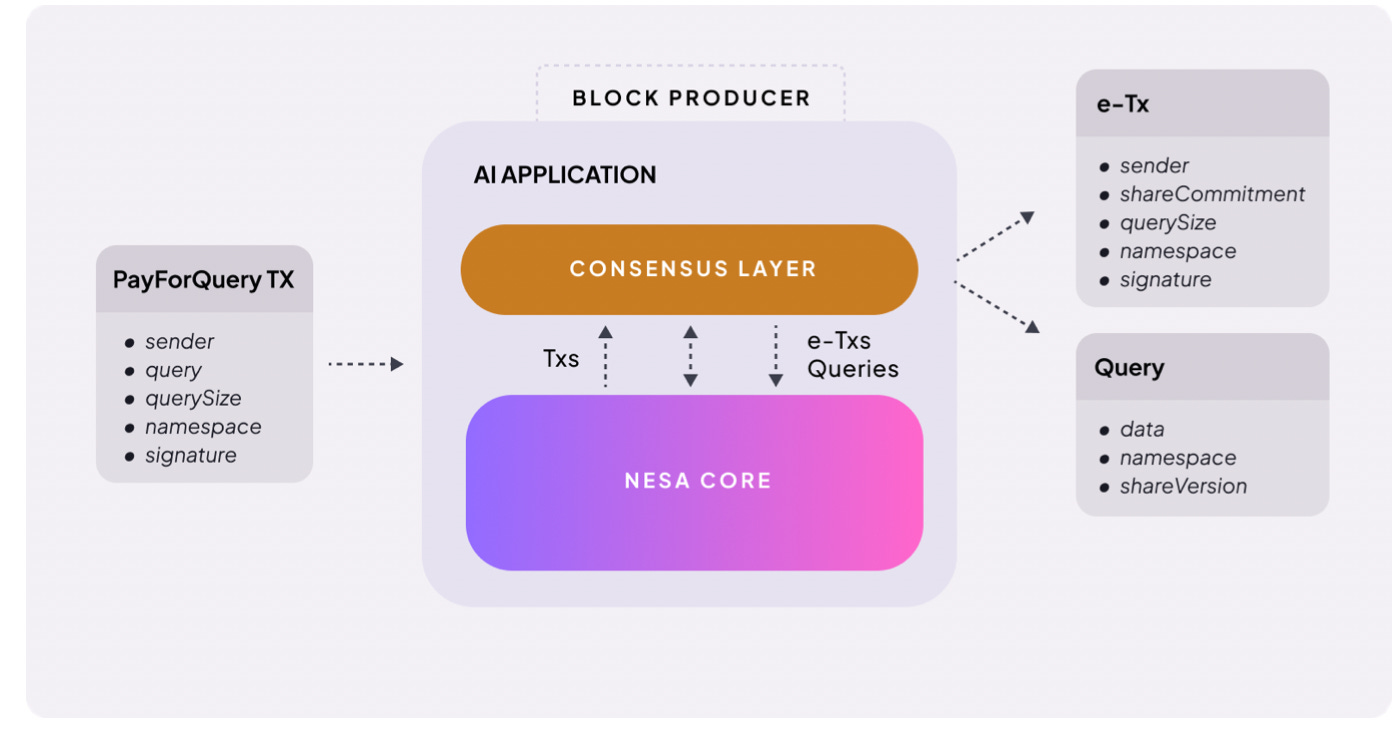

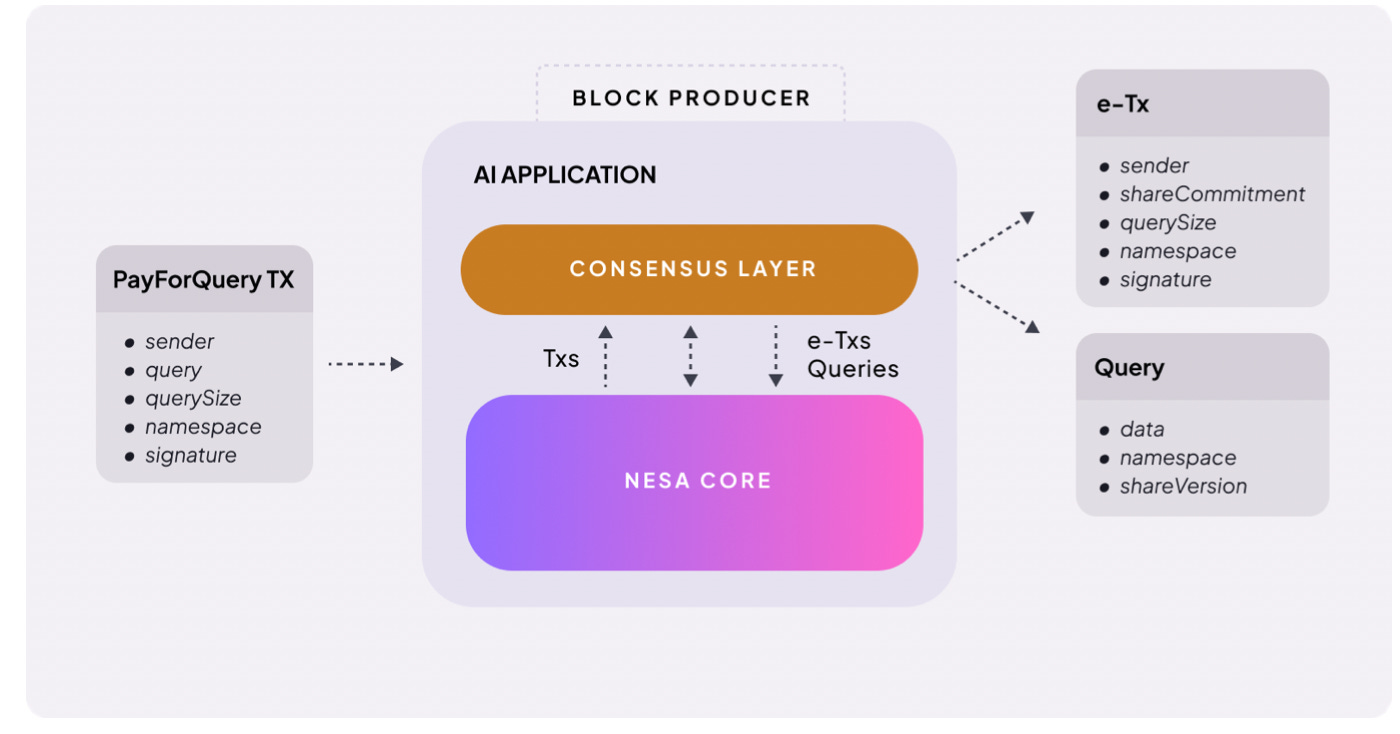

The structure is straightforward. When a user requests AI inference, a fee is attached. Nesa calls this PayForQuery. It consists of a fixed fee per transaction plus a variable fee proportional to data size.

Higher fees receive priority processing, the same principle as gas fees on a blockchain.

The recipients of these fees are miners. To participate in the network, miners must stake a set amount of $NES. They put their own tokens at risk before being assigned work.

If a miner returns faulty results or fails to respond, a penalty is deducted from their stake. If they process accurately and quickly, they earn greater rewards.

$NES also serves as a governance tool. Token holders can submit proposals and vote on core network parameters such as fee structures and reward ratios.

In summary, $NES serves three roles: payment for inference requests, collateral and reward for miners, and participation rights in network governance. Without the token, nodes do not run. Without nodes, privacy AI does not function.

One point worth noting: the token economy depends on preconditions to function as designed.

Inference demand must be sufficient for miner rewards to be meaningful. Rewards must be meaningful for miners to stay. Miners must be sufficient for network quality to hold.

This is a virtuous cycle where demand drives supply and supply sustains demand, but getting that cycle started is the hardest phase.

The fact that enterprise clients like Procter & Gamble are already using the network in production is a positive signal. However, whether the balance between token value and mining rewards holds as the network scales remains to be seen.

7. The Case for Privacy AI

The problem Nesa is trying to solve is clear: change the structure in which user data is exposed to third parties whenever AI is used.

The technical foundation is solid. Its core encryption technologies, Equivariant Encryption (EE) and HSS-EE, originated from academic research. The inference optimization scheduler MetaInf was published at the COLM 2025 main conference.

This is not a case of simply citing papers. The research team directly designed the protocols and implemented them in the network.

Among decentralized AI projects, it is rare to find one that has had its own cryptographic primitives validated at the academic level and deployed them onto live infrastructure. The fact that Procter & Gamble and other major enterprises are already running inference on this infrastructure is a meaningful signal for an early-stage project.

That said, limitations are clear.

Market scope: Institutional clients come first; retail users unlikely to pay for privacy yet

Product usability: Playground feels closer to Web3/investment UX than everyday AI tools

Scale validation: Controlled benchmarks ≠ production with thousands of concurrent nodes

Market timing: Demand for privacy AI is real, but demand for decentralized privacy AI is unproven; enterprises still default to centralized APIs

Most enterprises are still accustomed to centralized APIs, and the barrier to adopting blockchain-based infrastructure remains high.

We live in an era where even the head of U.S. cybersecurity uploaded classified documents to AI. Demand for privacy AI already exists and will only grow.

Nesa has academically validated technology and live infrastructure to meet that demand. There are limitations, but its starting position is ahead of other projects.

When the privacy AI market opens in earnest, Nesa will be among the first names that come up.

🐯 More from Tiger Research

Read more reports related to this research.Disclaimer

This report was partially funded by Nesa. It was independently produced by our researchers using credible sources. The findings, recommendations, and opinions are based on information available at publication time and may change without notice. We disclaim liability for any losses from using this report or its contents and do not warrant its accuracy or completeness. The information may differ from others’ views. This report is for informational purposes only and is not legal, business, investment, or tax advice. References to securities or digital assets are for illustration only, not investment advice or offers. This material is not intended for investors.

Terms of Usage

Tiger Research allows the fair use of its reports. ‘Fair use’ is a principle that broadly permits the use of specific content for public interest purposes, as long as it doesn’t harm the commercial value of the material. If the use aligns with the purpose of fair use, the reports can be utilized without prior permission. However, when citing Tiger Research’s reports, it is mandatory to 1) clearly state ‘Tiger Research’ as the source, 2) include the Tiger Research logo following brand guideline. If the material is to be restructured and published, separate negotiations are required. Unauthorized use of the reports may result in legal action.

]]>Key Takeaways

인공지능이 이미 일상이 된 현재, 사람들은 많은 데이터를 거리낌 없이 업로드하지만, 정작 그 데이터가 중앙 서버를 거친다는 사실을 간과함

심지어 미국의 보안을 책임지는 CISA의 직무대행 국장마저도 기밀 문서를 ChatGPT에 노출시키기도 했음

네사는 이를 해결하기 위해 데이터 전송 전 데이터 변환(EE) 및 노드 간 분할(HSS-EE)을 통해 어느 당사자도 원본을 볼 수 없도록 함

네사는 실질적으로 학술적 검증을 통해 기술적으로 앞서 나가고 있으며, P&G 등 대기업의 사용 사례도 확보함

다만, 전반적 시장은 빅테크의 중앙 집중식 API를 선호해, 향후 더 많은 고객사가 분산형 프라이버시 AI를 채택할지 지켜봐야할 것

1. 당신이 입력한 데이터는 안전한가

2026년 1월, 미국 사이버 보안의 핵심 기관인 CISA의 국장 대행 마두 고투무칼라(Madhu Gottumukkala)가 정부 민감 문서를 ChatGPT에 업로드한 사실이 드러났다. 계약 관련 서류를 요약하고 정리하려는 단순한 목적이었다.

물론 ChatGPT 내부에서 내용을 저장하고 정부에 알린 것은 아니며, 자체 보안 시스템에 적발되어 보안 규정 위반으로 조사를 받은 사례이다.

미국 보안 수장마저 AI를 일상적으로 쓰며, 기밀문서까지 올린 셈이다.

사용자가 입력한 데이터는 암호화되기에 안전하다고 할 수 있다. 맞다. 데이터는 명시적으로는 암호화된다. 하지만 사실 복호화가 가능한 구조다. 유효한 영장이나 긴급 상황에서는 정보를 제공할 수 있으며, 사실 우리는 그 뒤에서 어떤 일이 일어나는지 알 수 없다.

2. 일상 속에 필요한 프라이버시 AI - 네사(Nesa)

AI는 이미 일상이다. 기사를 요약하고, 코드를 짜고, 메일을 쓰는 데까지 깊이 들어왔다. 심각한 건 위 사례처럼 기밀 문서와 개인정보까지 별다른 경각심 없이 AI에 맡기고 있다는 점이다.

문제의 핵심은 이 데이터가 전부 서비스 제공자의 중앙 서버를 거친다는 데 있다. 암호화를 한다고 해도 복호화 키는 서비스 제공자가 쥐고 있다. 이걸 어떻게 믿을 수 있는가?

사용자의 입력 데이터는 모델 개선, 안전성 검토, 법적 요청 등 다양한 경로로 제3자에게 노출될 수 있다. 기업 플랜이라면 조직 관리자가 채팅 기록을 열람할 수 있고, 개인 플랜이라도 영장이 나오면 데이터는 넘어간다.

AI가 일상 깊숙이 자리 잡은 지금, 프라이버시에 대해 다시 한 번 질문을 던질 때다.

네사(Nesa)는 이 구조 자체를 바꾸려는 프로젝트다. 데이터를 중앙 서버에 맡기지 않고도 AI 추론을 실행할 수 있는 탈중앙 인프라를 만든다. 사용자의 입력 데이터는 암호화된 상태로 처리되며, 어떤 노드도 원본 데이터를 볼 수 없다.

3. 네사는 이를 어떻게 해결하는가?

네사를 사용하는 병원이 있다고 가정하자.

의사가 환자의 MRI 영상으로 종양 여부를 판독하고 싶다. 지금의 AI 서비스라면 이 영상이 OpenAI나 Google 서버로 그대로 전송된다. 네사에서는 다르다. 영상이 의사의 컴퓨터를 떠나기 전에 일정한 규칙으로 변환된다.

쉽게 설명하면 이렇다. 수학 시험지를 생각해 보자. 원래 문제가 “3 + 5 = ?”이라고 하자. 이 문제를 그대로 다른 사람에게 보여주면, 그 사람은 내가 무슨 계산을 하려는지 바로 안다.

하지만 보내기 전에 모든 숫자에 ×2를 적용하면, 상대방이 받는 문제는 “6 + 10 = ?”이 된다. 상대방은 이걸 풀어서 16이라는 답을 돌려준다.

나는 다시 ÷2를 적용해서 8을 얻는다. 원래 문제를 그대로 풀었을 때와 같은 답이다. 상대방은 계산을 대신 해줬지만, 내 원래 숫자가 3과 5였다는 건 모른다.

네사의 등변 암호화(Equivariant Encryption, EE)가 하는 일이 정확히 이것이다. 데이터를 보내기 전에 일정한 수학적 규칙으로 변환한다. AI 모델은 변환된 데이터를 가지고 계산을 수행한다. 사용자가 결과에 역변환을 적용하면, 원본 데이터를 넣었을 때와 동일한 답이 나온다. 이 성질을 수학에서 등변성이라고 부른다. 변환을 먼저 하든, 계산을 먼저 하든, 최종 결과가 같다는 뜻이다.

실제로는 ×2 같은 단순한 규칙이 아니라, AI 모델의 내부 연산 구조에 맞춘 복잡한 변환을 쓴다. 핵심은 무작위로 데이터를 섞는 게 아니라, 모델의 계산 흐름과 맞물리는 규칙을 적용한다는 점이다. 그래서 모델이 변환된 데이터를 처리해도 결과의 정확도가 떨어지지 않는다.

다시 병원으로 돌아오면, 의사가 체감하는 건 아무것도 없다. 영상을 올리고 결과를 받는 과정은 기존과 같다. 달라진 건 그 사이에서 어떤 노드도 환자의 원본 MRI를 볼 수 없다는 점이다.

네사는 여기서 한 단계 더 나간다. EE만으로도 노드가 원본을 볼 수 없지만, 변환된 데이터 자체는 하나의 서버에 온전히 존재한다. HSS-EE(Homomorphic Secret Sharing over Encrypted Embeddings)는 이 변환된 데이터마저 쪼개는 기술이다.

아까 수학 시험지 비유로 돌아가 보자. EE는 문제지에 ×2 규칙을 적용해서 보내는 것이었다. HSS-EE는 여기서 한 걸음 더 나간다. 규칙이 적용된 시험지를 반으로 찢어서, 앞부분은 A에게, 뒷부분은 B에게 따로 보내는 것이다. A는 자기가 받은 조각만 풀고, B도 자기 조각만 푼다. 어느 쪽도 전체 문제를 볼 수 없다. 두 사람의 답을 합쳐야 비로소 완전한 결과가 나오고, 이를 합칠 수 있는 건 문제를 보낸 사람뿐이다.

정리하면, EE는 “데이터를 변환해서 원본을 못 보게” 하는 기술이고, HSS-EE는 “변환된 데이터마저 쪼개서 한 곳에 모이지 않게” 하는 기술이다. 프라이버시 보호가 이중으로 걸리는 구조다.

4. 프라이버시를 강화하면 느려진다?

프라이버시를 강화하면 느려진다. 이건 암호 기술의 오래된 상식이다. 가장 널리 알려진 완전 동형 암호(FHE)는 일반 연산 대비 1만~100만 배 느리다. 실시간 AI 서비스에 적용할 수 없다.

네사의 등변 암호화(EE)는 다르다. 수학 시험지 비유로 돌아가면, ×2를 적용하고 나중에 ÷2로 되돌리는 데 드는 추가 비용은 미미하다. FHE처럼 문제 자체를 완전히 다른 수학 체계로 바꾸는 게 아니라, 기존 계산 위에 가벼운 변환만 얹는 구조이기 때문이다.

EE (등변 암호화): LLaMA-8B 기준, 지연시간 증가 9% 미만 (정확도 원본 대비 99.99% 이상 일치)

HSS-EE (분산 암호화): LLaMA-2 7B 기준, 추론 1건당 700-850밀리초

여기에 MetaInf라는 메타러닝 스케줄러가 네트워크 전체의 효율을 잡는다. 모델 크기, GPU 사양, 입력 특성을 보고 가장 빠른 추론 기법을 자동으로 골라주는 시스템이다. 기존 머신러닝 기반 선택기 대비 정확도 89.8%, 가속 비율 1.55배를 기록했고, COLM 2025 본회의에 게재되어 학술적으로도 검증받았다.

위 수치는 통제된 테스트 환경에서 나온 결과다. 다만 네사의 추론 인프라는 이미 실제 엔터프라이즈 환경에서 사용되고 있어, 실서비스 수준의 성능이 확인된 상태다.

5. 누가, 어떻게 쓰는가

네사에 접근하는 방식은 크게 세 가지다.

첫 번째는 플레이그라운드다. 웹에서 바로 모델을 골라 테스트할 수 있는 환경이다. 개발자가 아니어도 된다. 모델별 입력을 넣고 결과를 확인하는 수준의 체험이 가능하다. 탈중앙 AI 추론이 실제로 어떻게 작동하는지 직접 확인할 수 있는 가장 빠른 경로다.

두 번째는 Pro 구독이다. 월 8달러로 무제한 접근, 월 1,000건의 Fast Inference 크레딧, 커스텀 모델 가격 설정 권한, 모델 Featured 페이지 노출 등이 포함된다. 개인 개발자나 소규모 팀이 자기 모델을 올리고 수익화하려는 경우에 맞는 요금제다.

세 번째는 엔터프라이즈다. 공개 요금제가 아니라 별도 계약 구조다. SSO/SAML 지원, 데이터 저장 위치 선택(Storage Regions), 감사 로그, 세분화된 접근 제어, 연간 커밋 기반 청구 등이 포함된다.

월 유저당 20달러부터 시작하지만, 실제 조건은 규모에 따라 협의한다. 기업이 사내 AI 파이프라인에 네사를 통합하려는 경우를 위한 구조로, 별도 계약을 통해 API를 제공받고 조직 단위로 관리할 수 있다. 또한 이미 P&G와 같은 대기업들이 쓰고 있다.

정리하면, 가볍게 써보려면 플레이그라운드, 개인·소규모 개발이면 Pro, 조직 단위 도입이면 엔터프라이즈다.

6. 왜 토큰이 필요한가?

탈중앙 네트워크는 중앙 관리자가 없다. 서버를 돌리는 주체도, 결과를 검증하는 주체도 전 세계에 흩어져 있다. 그러면 질문이 하나 생긴다. 이 사람들은 왜 자기 GPU를 켜고 남의 AI 추론을 처리해 주는가?

답은 경제적 보상이다. 네사 네트워크에서 그 보상 수단이 $NES 토큰이다.

구조는 단순하다. 사용자가 AI 추론을 요청하면, 그 요청에는 수수료가 붙는다. 네사에서는 이를 PayForQuery라고 부른다. 트랜잭션당 고정 수수료와 데이터 크기에 비례하는 변동 수수료로 구성된다. 수수료가 높을수록 우선 처리된다. 블록체인의 가스비와 같은 원리다.

이 수수료를 받는 쪽이 채굴자(Miner)다. 채굴자는 네트워크에 참여하기 위해 일정량의 $NES를 스테이킹해야 한다. 자기 돈을 걸어야 일을 맡길 수 있는 구조다. 엉터리 결과를 내거나 응답하지 않으면 스테이킹한 토큰에서 페널티가 차감된다. 반대로 정확하고 빠르게 처리하면 더 많은 보상을 받는다.

또한 네트워크의 방향을 결정하는 거버넌스 도구이기도 하다. $NES 보유자는 수수료 구조, 보상 비율 등 네트워크 핵심 파라미터에 대한 제안과 투표에 참여할 수 있다.

정리하면, $NES는 세 가지 역할을 한다. 추론 요청의 결제 수단, 채굴자의 담보이자 보상, 그리고 네트워크 거버넌스 참여권이다. 토큰이 있어야 노드가 돌아가고, 노드가 돌아가야 프라이버시 AI가 작동한다.

다만 짚어야 할 부분이 있다. 토큰 이코노미가 설계대로 작동하려면 전제 조건이 필요하다.

추론 수요가 충분해야 채굴자에게 돌아가는 보상이 유의미하고, 보상이 유의미해야 채굴자가 남아 있고, 채굴자가 충분해야 네트워크 품질이 유지된다.

결국 수요가 공급을 견인하고, 공급이 다시 수요를 뒷받침하는 선순환 구조인데, 초기에 이 바퀴가 돌아가기까지가 가장 어렵다. 현재 엔터프라이즈 고객이 실사용 중이라는 점은 긍정적이지만, 네트워크 규모가 커졌을 때 토큰 가치와 채굴 보상 사이의 균형이 유지되는지는 지켜봐야 한다.

7. 프라이버시 AI의 필요성

네사가 풀려는 문제는 명확하다. AI를 쓸 때 데이터가 제3자에게 노출되는 구조를 바꾸겠다는 것이다.

기술적 기반은 탄탄한 편이다. 핵심 암호화 기술인 등변 암호화(EE)와 HSS-EE는 학술 연구에서 출발했고, 추론 최적화 스케줄러 MetaInf는 COLM 2025 본회의에 게재됐다. 단순히 논문을 인용하는 수준이 아니라, 연구진이 직접 프로토콜을 설계하고 네트워크에 구현하는 구조다.

탈중앙 AI 프로젝트 중 자체 암호화 프리미티브를 논문 수준에서 검증받고, 그걸 실제 인프라에 올린 경우는 드물다. 실제 P&G와 같은 엔터프라이즈 고객이 이 인프라 위에서 추론을 돌리고 있다는 점도 초기 프로젝트치고는 유의미한 신호다.

다만 한계도 분명하다.

첫째, 타겟 시장의 폭이다. 현실적으로 이 기술이 먼저 먹히는 곳은 기관이다. 일반 사용자가 AI 프라이버시를 인식하고 비용까지 지불하려면 아직 시간이 필요하다. 리테일 시장에서 프라이버시는 ‘있으면 좋은 것’이지, ‘돈을 내고 살 것’까지는 아니다. 결국 현 단계에서 네사의 성장은 기관 고객을 얼마나 꾸준히 확보하느냐에 달려 있는데, 이건 결코 쉬운 일이 아니다.

둘째, 제품 사용성이다. 플레이그라운드는 모델을 직접 체험할 수 있는 공간이지만, 현재 구성은 투자를 유도하는 웹3 서비스의 모습에 가깝다. 우리가 일상적으로 쓰는 AI 서비스와는 다소 거리가 있다.

셋째, 규모의 검증이다. 통제된 환경의 벤치마크와 수천 노드가 동시에 돌아가는 프로덕션 환경은 다르다. 네트워크가 본격적으로 확장됐을 때도 같은 성능을 유지할 수 있는지는 별개의 문제다.

넷째, 시장 타이밍이다. 기관들의 프라이버시 AI에 대한 수요는 분명하지만, 그 수요가 “탈중앙 인프라 위의 프라이버시 AI”까지 확장되는지는 다른 문제다. 대부분의 기업은 아직 중앙화된 API에 익숙하고, 블록체인 기반 인프라에 대한 진입 장벽은 여전히 높다.

미국 보안 수장마저 기밀 문서를 AI에 올리는 시대다. 프라이버시 AI에 대한 수요는 이미 존재하고, 시간이 갈수록 커질 수밖에 없다. 네사는 이 수요에 대해 학술적으로 검증된 기술과 실제 가동 중인 인프라를 갖추고 있다. 한계는 있지만, 출발선 자체가 다른 프로젝트들보다 앞에 있다.

프라이버시 AI 시장이 본격적으로 열릴 때, 가장 먼저 이름이 올라올 프로젝트 중 하나다.

🐯 More from Tiger Research

이번 리서치와 관련된 더 많은 자료를 읽어보세요.Disclaimer

이 보고서는 네사(Nesa)로부터 일부 원고료 지원을 받았으나, 신뢰할 수 있는 자료를 바탕으로 독립적인 조사를 통해 작성되었습니다. 하지만 이 보고서의 결론과 권고사항, 예상, 추정, 전망, 목표, 의견 및 관점은 작성 당시의 정보를 바탕으로 하며 예고 없이 변경될 수 있습니다. 이에 당사는 본 보고서나 그 내용을 이용함에 따른 모든 손실에 대해 책임을 지지 않으며 정보의 정확성, 완전성, 그리고 적합성을 명시적으로나 암시적으로 보증하지 않습니다. 또한 타인 및 타조직의 의견과 일치하지 않거나 반대될 수 있습니다. 이 보고서는 정보 제공의 목적으로 작성되었으며, 법률, 사업, 투자, 또는 세금에 관한 조언으로 간주되어서는 안 됩니다. 또한 증권이나 디지털 자산에 대한 언급은 설명을 위한 것일 뿐, 투자 권고나 투자 자문 서비스 제공을 제안하는 것이 아닙니다. 이 자료는 투자자나 잠재적 투자자를 대상으로 하지 않았습니다.

Terms of Usage

타이거리서치는 리포트의 공정 사용을 지지합니다. 이는 공익적 목적으로 콘텐츠를 인용하되 상업적 가치에 영향을 주지 않는 범위에서의 넓은 사용을 허용하는 원칙입니다. 공정 사용 규칙에 따라, 리포트를 사전 허가 없이 사용할 수 있으나, 타이거리서치 리포트를 인용 시에는 1) 출처로 ‘타이거리서치’를 분명히 밝히고, 2) 타이거리서치의 브랜드 가이드라인에 맞는 로고(Black/White)를 포함시켜야 합니다. 자료를 재구성하여 출판할 경우에는 별도의 협의가 요구됩니다. 사전 허가 없는 사용은 법적 조치를 초래할 수 있습니다.

]]>Key Takeaways

Projects that address real, concrete problems tend to remain resilient even during market downturns.

Hyperliquid, Canton, and Kite target different problem areas, but they share a common trait: practical and realistic solutions rather than abstract narratives.

To assess this realism, analysis should focus on three factors: the problem the project aims to solve, the structure of its solution, and the team’s ability to execute in practice.

1. Conditions for Survival in a Down Market: Does It Work in Practice

Bitcoin has fallen below $70,000. Among the top 100 cryptocurrencies by market capitalization, only seven remain above their 200-day moving average. This stands in contrast to the Nasdaq 100, where 53 constituents are still trading above the same threshold.

Market conditions cannot be resisted. Still, some crypto assets manage to endure even in the worst environments.

Their resilience cannot be easily dismissed as the result of artificial market making or a coincidental rebound. A closer look at their trajectory suggests a different explanation.

These projects no longer rely on vague visions or technical complexity alone. Instead, they share a common trait: they address core market problems with solutions that are grounded in practical reality. Their approaches generally align with three directions.

Do they solve problems the market is facing today?

Are they prepared for real-world use in the near term?

Are they building infrastructure that the industry will depend on over the long term?

Ultimately, the ability to solve real problems in practice remains the strongest fundamental.

2. Three Directions Chosen by the Market

Projects that could answer the questions above managed to survive. They did so by, 1) clearly identifying market problems 2) presenting practical solutions that matched their specific timing.

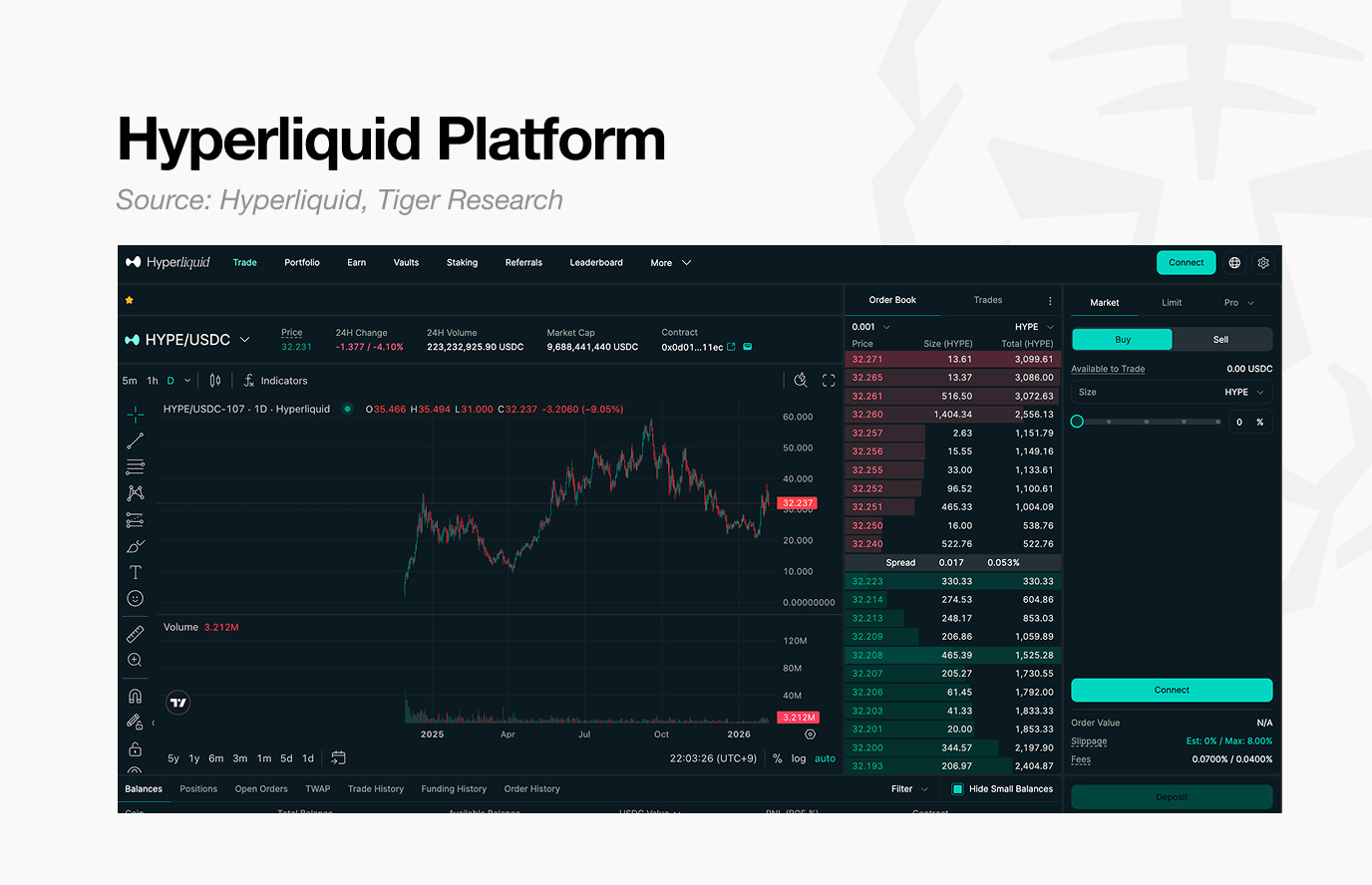

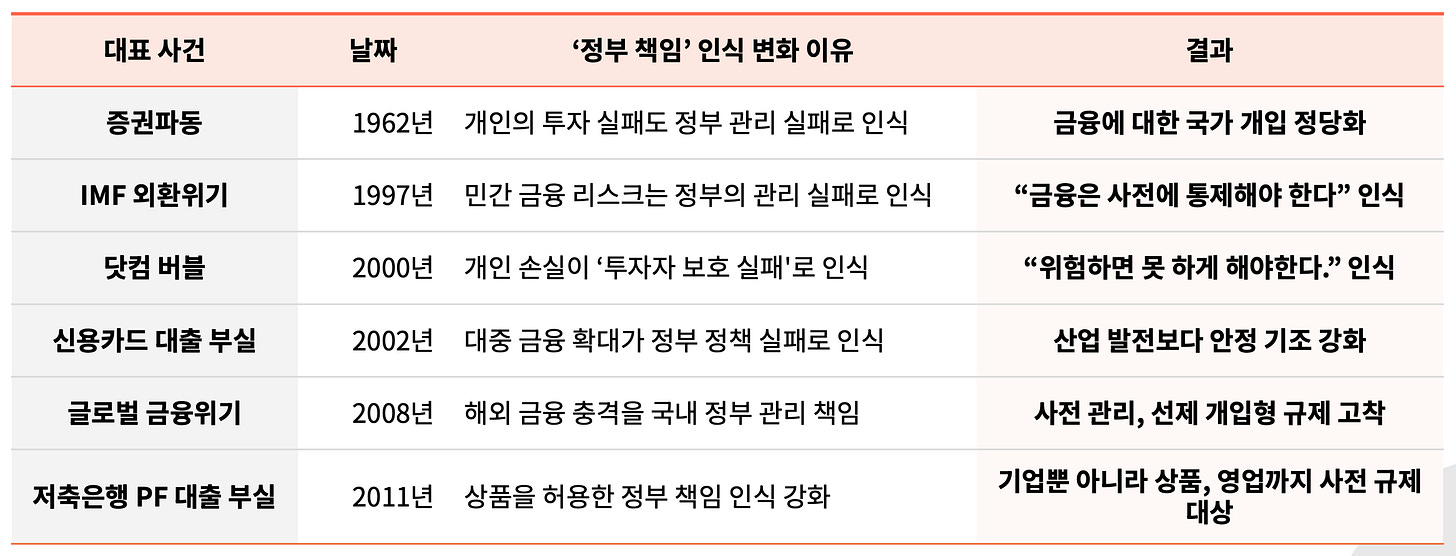

2.1. Hyperliquid: Solving Immediate Trading Frictions

Centralized exchanges have traditionally been viewed as accountable intermediaries. In practice, however, they have often failed to align with investor interests when issues arise. Decentralized exchanges emerged as an alternative, but inferior user experience and performance led many investors to avoid them.

Against this backdrop, Hyperliquid introduced the concept of a perp DEX. It brought features investors valued in centralized exchanges such as high leverage, fast execution, and stable liquidity through its HLP mechanism into an on-chain environment.

Early usage was driven in part by demand for the $HYPE token airdrop. However, continued engagement after the airdrop reflected user satisfaction with the platform’s performance.

Ultimately, Hyperliquid’s resilience stems from addressing a persistent and current problem: dissatisfaction with centralized exchanges.

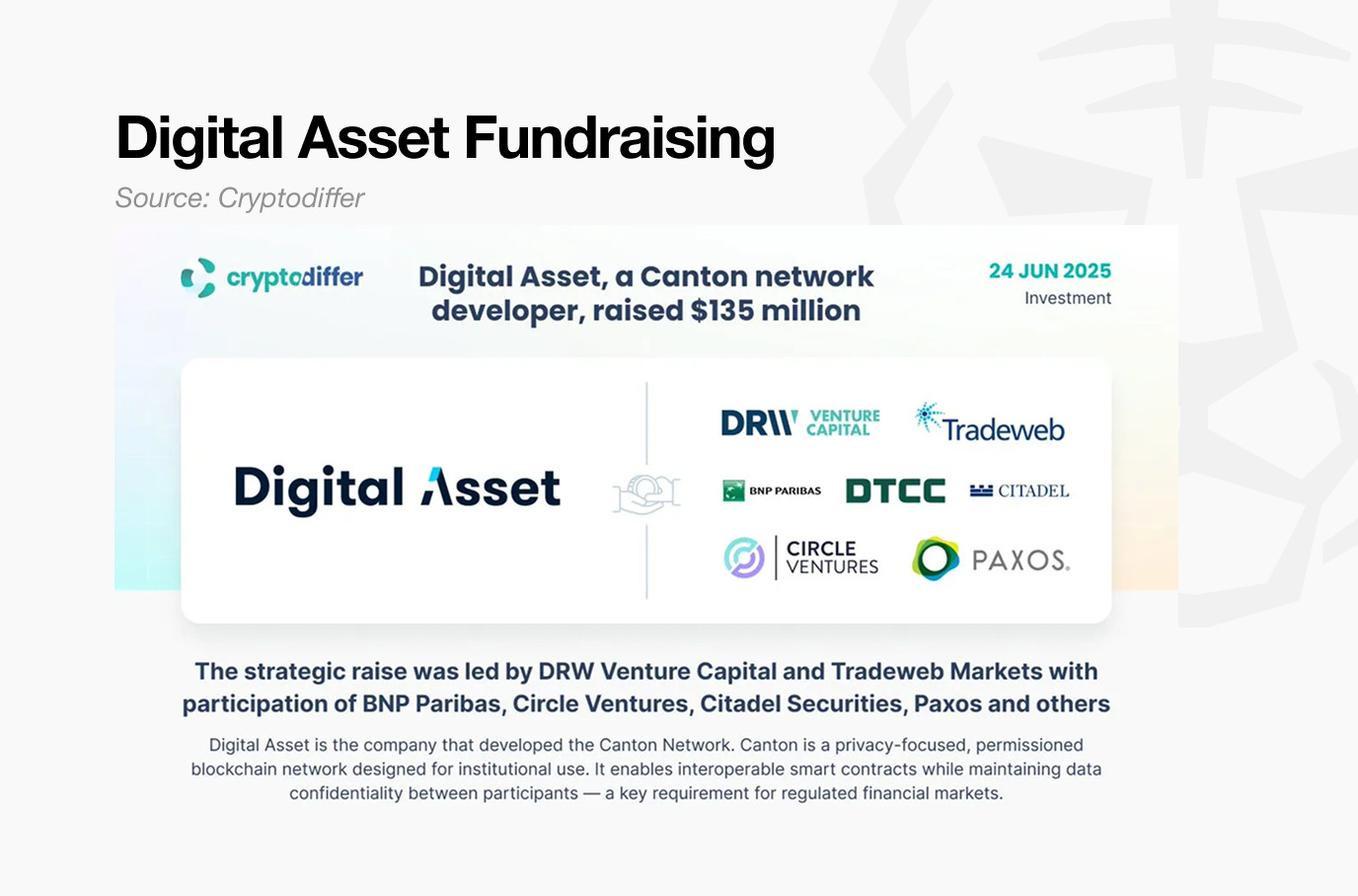

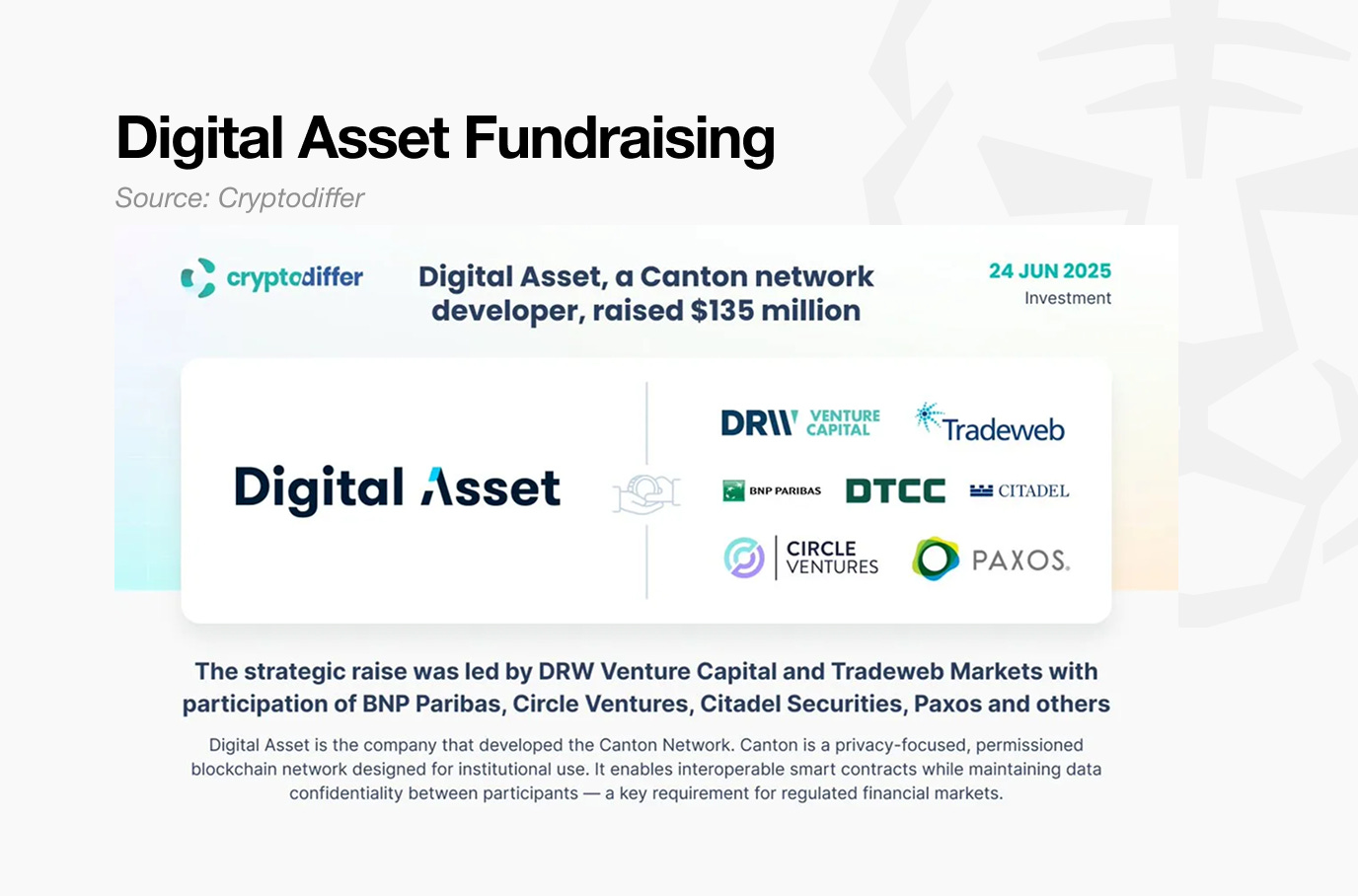

2.2. Canton Network: Preparing for the Institutional Finance Era

Canton presents a solution aimed at the near future. As interest in real-world assets continues to rise, institutions have begun to view blockchain not as a public network, but as financial infrastructure. In this context, what institutions require is not full data transparency, but a selective privacy model that supports both regulatory compliance and confidentiality.

The Canton Network emerged in response to these demands. Through DAML, Canton enables configurable data disclosure tailored to each participating party.

This allows institutions to preserve transaction confidentiality while sharing information only within necessary boundaries. Rather than imposing a provider-driven design, Canton builds infrastructure aligned with institutional demand.

Another critical factor is that Canton has expanded its ecosystem with real-world deployment in mind from the outset, supported by early collaboration with financial institutions.

Most notably, its partnership with DTCC establishes a pathway for assets managed within traditional financial systems to extend into a Canton-based environment. DTCC processes approximately $3.7 quadrillion in transactions annually, underscoring the practical feasibility of the Canton Network’s approach.

Ultimately, the Canton Network offers a structural solution that aims to satisfy three institutional requirements simultaneously: privacy protection, regulatory compliance, and integration with existing financial systems.

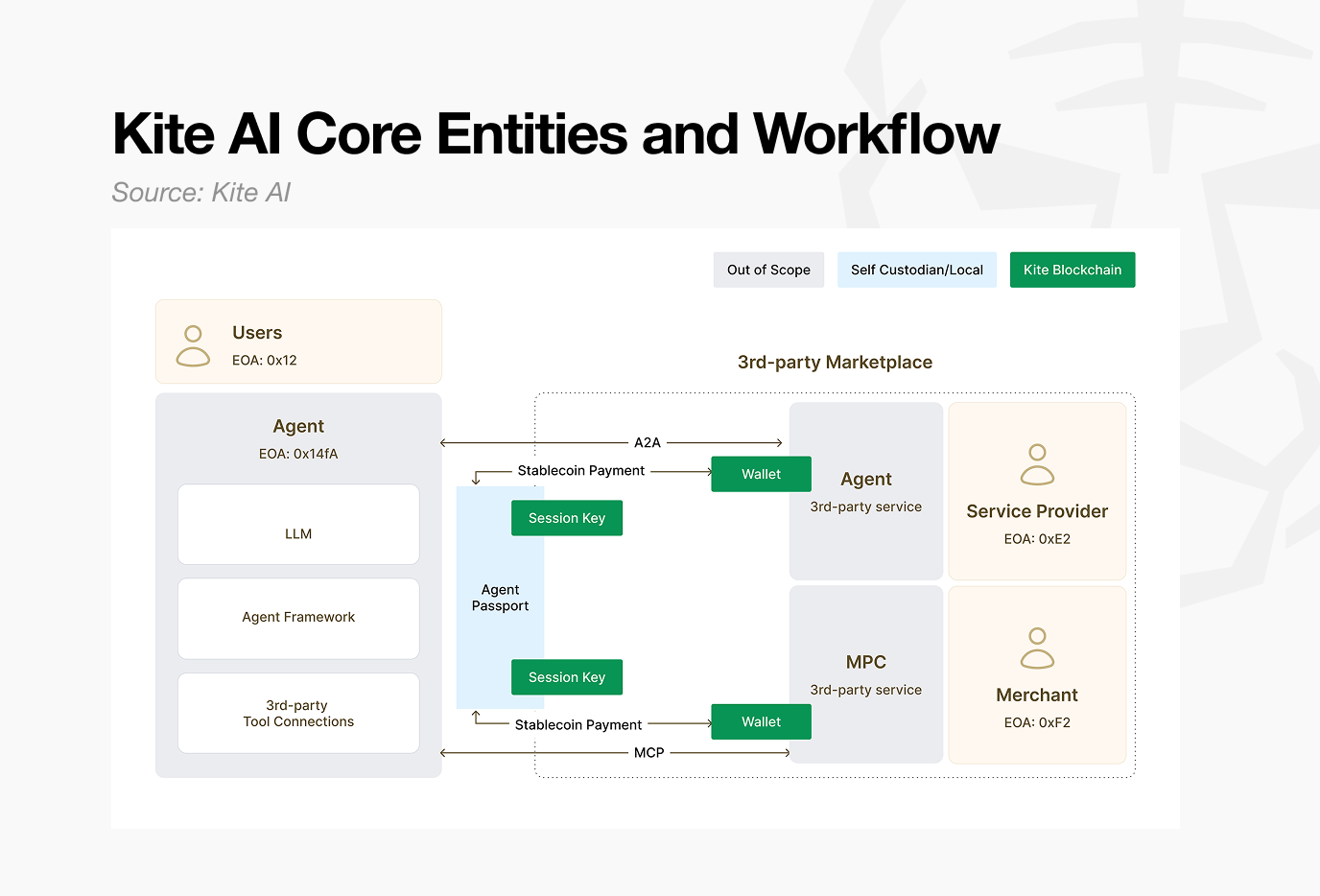

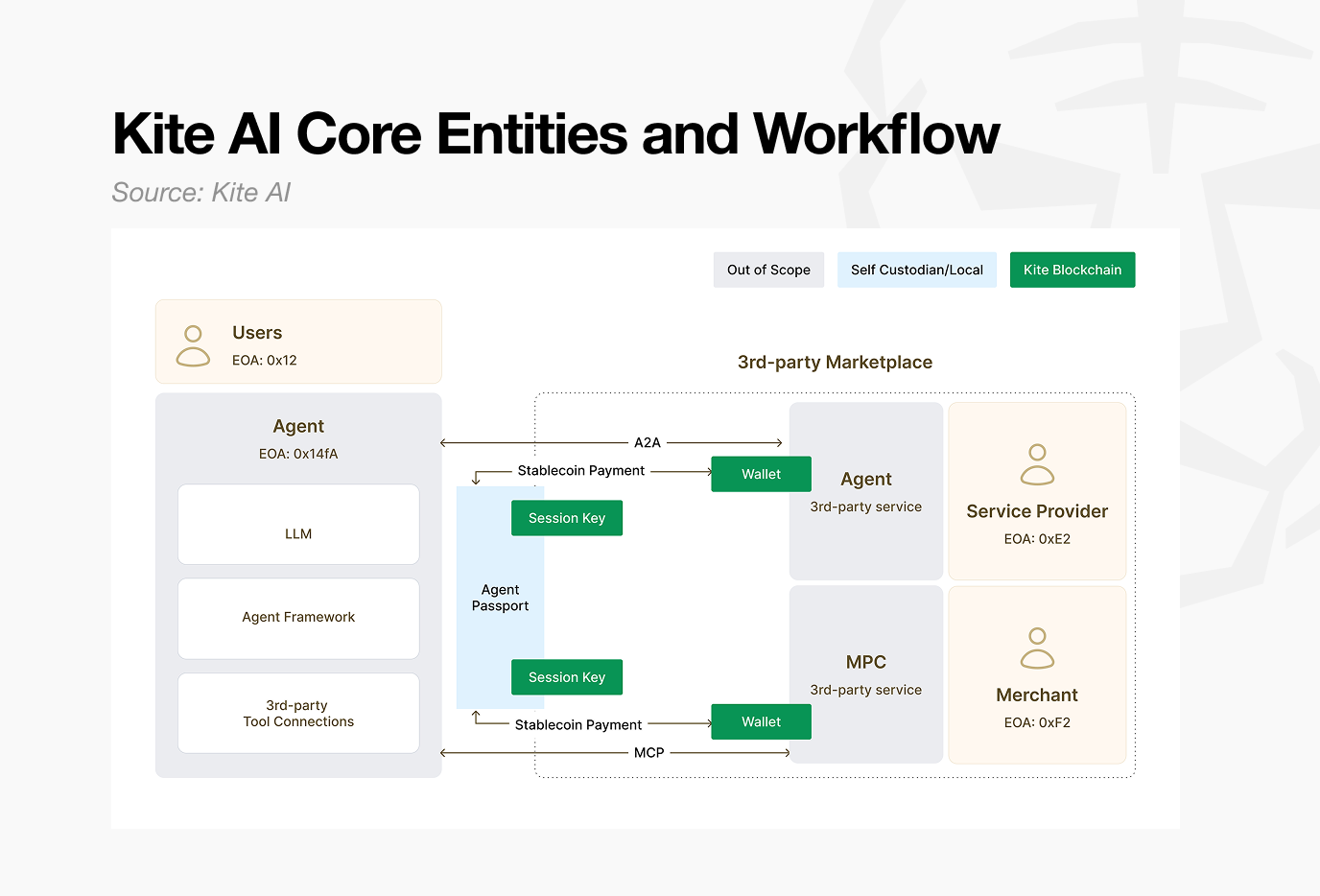

2.3. Kite AI: Building an AI Economy That Has Not Yet Arrived

Unlike the previous examples, Kite AI currently has limited real world adoption. However, when viewed through the lens of a future in which AI agents operate as economic actors, its structural logic remains compelling.

Across both Web2 and Web3, there is broad consensus on an agent-driven future. Few dispute a scenario in which AI agents handle tasks such as booking hotels or ordering groceries on behalf of users.

That future, however, requires infrastructure that allows AI agents to initiate and execute payments independently. Existing transaction systems were designed around human-to-human transfers and efficiency between human participants.

As a result, for AI agents to function as autonomous economic entities, new mechanisms are required, including identity verification and automated payment frameworks.

Kite AI is building payment infrastructure designed for this environment. Its core components include an “agent passport” for identity verification and x402 protocol functionality to enable automated payments.

The vision Kite AI presents cannot be deployed at scale today, simply because the future it targets has not yet materialized.

Still, the project derives realism from a broader premise: when this widely anticipated future arrives, the underlying technology it is developing will be necessary. This alignment with a broadly accepted trajectory lends the project structural credibility despite limited current usage.

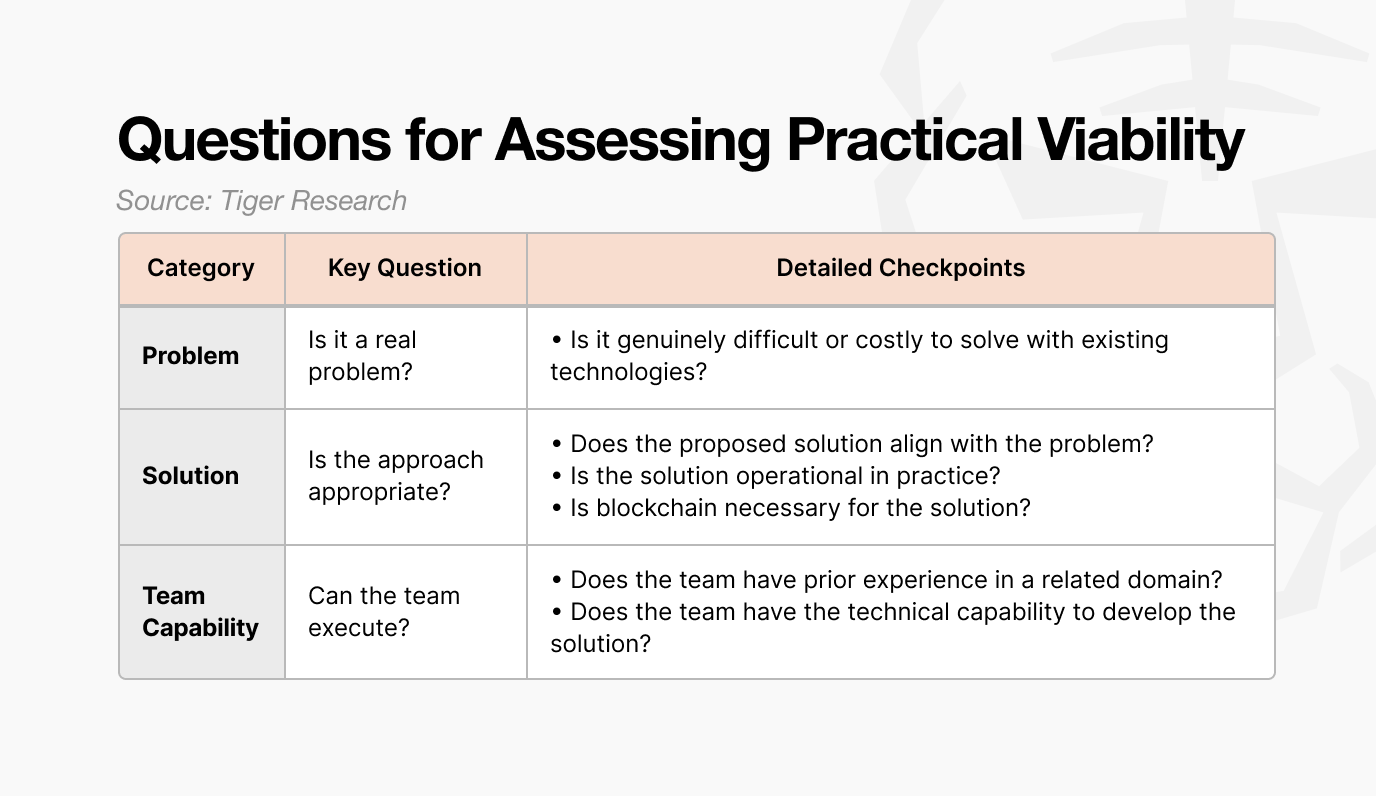

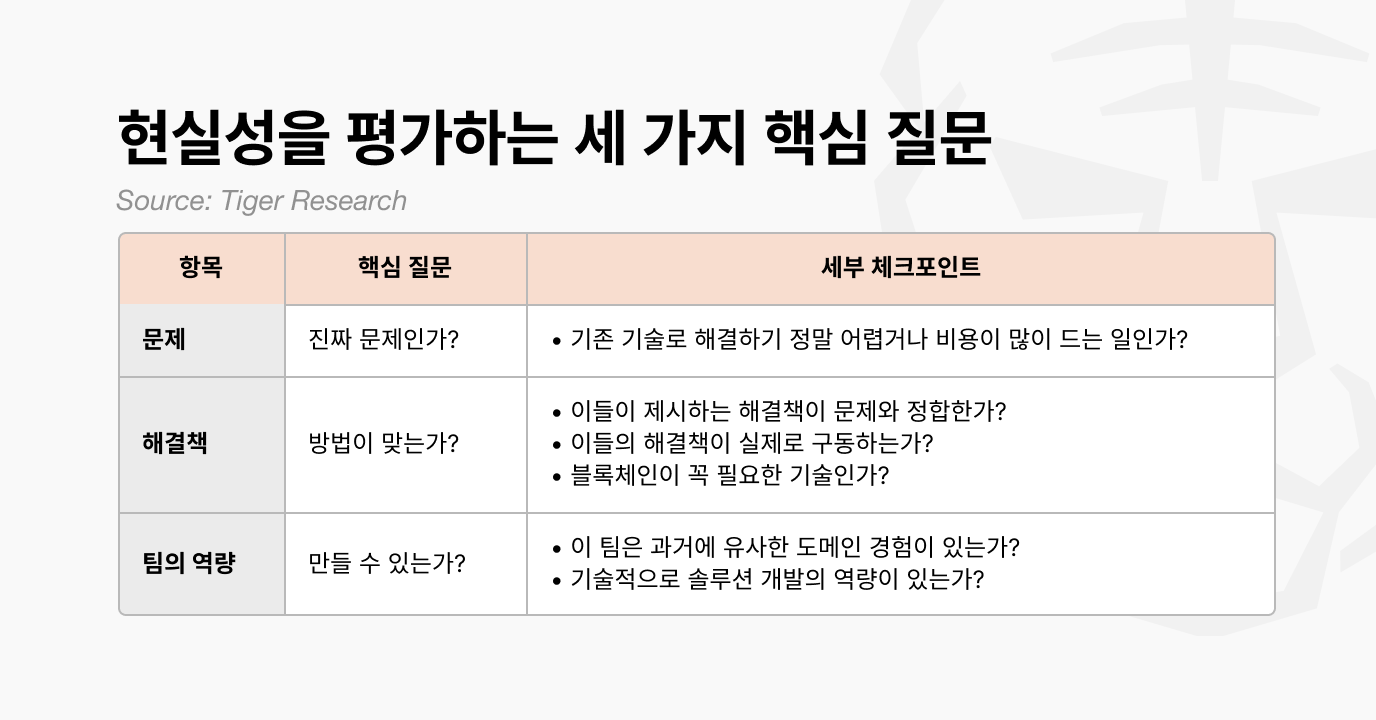

3. Three Key Questions for Assessing Practical Viability

Although the three projects operate on different timelines, they share a common characteristic: real-world viability.

Assessments of the same project often diverge. Some view it as solving real problems, while others dismiss it as overhyped. To reduce this gap in interpretation, at least three core questions must be asked.

Because most projects promote optimistic future narratives, answering these questions properly requires time and effort. Filtering out misleading or incomplete information is not straightforward. Projects that cannot answer these three questions with confidence may experience short-term price appreciation, but they are likely to fade when the next downturn arrives.

The current state of the crypto market is clearly unfavorable. That does not mean it is over. New experiments will continue, and the task is to evaluate what those efforts truly represent.

What matters now is realism.

🐯 More from Tiger Research

Read more reports related to this research.Disclaimer

This report has been prepared based on materials believed to be reliable. However, we do not expressly or impliedly warrant the accuracy, completeness, and suitability of the information. We disclaim any liability for any losses arising from the use of this report or its contents. The conclusions and recommendations in this report are based on information available at the time of preparation and are subject to change without notice. All projects, estimates, forecasts, objectives, opinions, and views expressed in this report are subject to change without notice and may differ from or be contrary to the opinions of others or other organizations.

This document is for informational purposes only and should not be considered legal, business, investment, or tax advice. Any references to securities or digital assets are for illustrative purposes only and do not constitute an investment recommendation or an offer to provide investment advisory services. This material is not directed at investors or potential investors.

Terms of Usage

Tiger Research allows the fair use of its reports. ‘Fair use’ is a principle that broadly permits the use of specific content for public interest purposes, as long as it doesn’t harm the commercial value of the material. If the use aligns with the purpose of fair use, the reports can be utilized without prior permission. However, when citing Tiger Research’s reports, it is mandatory to 1) clearly state ‘Tiger Research’ as the source, 2) include the Tiger Research logo. If the material is to be restructured and published, separate negotiations are required. Unauthorized use of the reports may result in legal action.

]]>Key Takeaways

현실적으로 문제를 해결 할 수 있는 프로젝트가 하락장에서도 견딤

하이퍼리퀴드, 캔톤, 카이트는 서로 다른 문제점을 해결 하지만 공통점은 ‘현실성’있는 해결책

현실성을 판단하기 위해서는 프로젝트가 해결하려는 문제, 솔루션, 실현 가능 역량을 중점적으로 평가

1. 하락장에서 살아남는 조건: 현실적으로 작동하는가

비트코인이 결국 $70,000 아래로 떨어졌다. 암호화폐 시총 상위 100개 종목 중 200일 선 위에 있는 종목은 단 7개뿐이다. 나스닥 100의 종목 중 53개가 200일선 위에 있는 것과 대조적이다.

시장의 상황을 거스를 수는 없다. 하지만 최악의 상황에서도 버텨내는 암호화폐 역시 존재한다.

이들은 어떻게 하락장에서도 가격을 지킬 수 있는가? 이를 단순히 “인위적인 마켓 메이킹(MM)의 결과물”이라거나 “우연한 반등”라고 하기에는 그들의 행보를 보면 생각이 달라질 수 있다.

이들은 더 이상 불투명한 비전이나 기술적 화려함만을 내세우지 않는다. 대신 시장의 핵심 문제를 ‘현실성’있게 해결해 나가고 있다는 공통점을 가진다. 이들은 구체적으로 다음과 같은 세 가지 방향을 갖는다.

지금 당장 시장이 겪는 문제를 풀고 있는가?

가까운 미래에 실제 사용될 준비가 되어 있는가?

장기적으로 산업이 의존하게 될 기반을 만들고 있는가?

결국, ‘현실적인 문제 해결 능력’이 가장 강력한 펀더멘털이다.

2. 시장이 선택한 세 가지 방향

위 질문에 답변하는 프로젝트는 살아남았다. 이들은 1) 시장의 문제를 인식하고, 2) 각자의 시점에 맞는 현실적인 해결책을 제시했다.

2.1. 하이퍼리퀴드: 지금 당장의 거래 문제를 해결하다

중앙화 거래소는 책임을 진다는 면에서 강점이 있었으나, 실제로는 문제가 생길 때마다 투자자들의 편이 아니었다. 이를 해결하고자 여러 탈중앙화 거래소가 등장했지만, 사용 환경이 중앙화 거래소보다 좋지 않아 투자자들에게 외면받았다.

이러한 상황에서 하이퍼리퀴드는 perpDEX라는 개념을 가져왔다. CEX에서 투자자들이 원하는 고배율 레버리지, 빠른 체결 속도, 그리고 HLP 기반의 안정적인 유동성을 온체인 환경에서 구현한 것이다. 출시 초기에는 $HYPE 토큰 에어드랍을 노린 유저들이 몰려들었지만, 실제로 플랫폼을 사용하면서 투자자들은 성능에 만족하여 에어드랍이 끝난 이후에도 거래를 지속했다.

결국 하이퍼리퀴드는 지속된 오늘의 문제, 중앙화 거래소에 대한 불만을 해결한 것에서 나온다.

2.2. 캔톤 네트워크: 다가오는 기관 금융 시대를 준비하다

캔톤은 가까운 미래의 해결책을 제시하고 있다. RWA에 대한 관심이 높아지는 가운데, 기관들은 블록체인을 단순한 퍼블릭 네트워크가 아닌 ‘금융 인프라’ 관점에서 바라보기 시작했다. 이러한 환경에서 기관들이 요구하는 것은 모든 데이터를 공개하는 구조가 아니라, 규제 준수와 기밀성을 동시에 충족할 수 있는 선택적 프라이버시 체인이다.

이러한 요구에 대응하기 위해 등장한 것이 캔톤 네트워크다. 캔톤은 daml를 통해서 각 파티에 맞는 정보 공개 수준을 제공했다. 이를 통해 기관들은 거래 데이터의 기밀성을 유지하면서도 필요한 범위 내에서만 정보를 공유할 수 있다. 즉 공급자적 마인드가 아닌 수요자, 기관이 원하는 인프라를 만든 것이다.

게다가 캔톤 네트워크는 초기부터 금융기관과의 협력 네트워크를 구축하며 실제 사용 환경을 전제로 생태계를 확장해왔다는 점이 중요하다. 특히 DTCC와의 파트너십을 통해, 기존 금융 시스템에서 관리되던 자산을 캔톤 네트워크 기반 환경으로 확장할 수 있는 기반을 마련했다. DTCC가 연간 처리하는 거래 규모는 약 3.7경 달러에 달하며, 이는 캔톤 네트워크의 현실 실현 가능함을 보여준다.

결국 캔톤 네트워크는 기관이 요구하는 프라이버시 보호, 규제 준수, 그리고 기존 금융 시스템과의 연동이라는 세 가지 조건을 동시에 충족하려는 구조적 해법을 제시하고 있다.

2.3. 카이트 AI: 아직 오지 않은 AI 경제를 구축하다

카이트 AI는 앞선 사례들과 달리 아직 실사용 사례는 제한적이다. 그러나 AI 에이전트가 경제 주체로 활동하게 될 미래를 고려할 때, 구조적 설득력은 충분히 확보하고 있다.

웹2와 웹3를 막론하고 AI 에이전트에 기반한 미래는 모두가 동의한다. AI 에이전트가 나를 대신해서 호텔을 예약해주고, 바나나를 주문해주는 그러한 미래에 대해 누구도 이견이 없다.

하지만 이 미래를 위해서는 AI 에이전트가 스스로 결제를 수행하는 인프라가 필요하다. 기존 거래 시스템은 설계 단계부터 인간 간 송금과 거래 효율화에 집중해 왔다. 때문에 AI 에이전트가 독립적인 경제 주체로 활동하기 위해서는 신원 증명이나 자동화된 결제 구조가 필요한 것이다.

카이트 AI는 이런 미래를 대비하기 위한 AI 에이전트 결제 인프라를 만들고 있다. 위에 설명한 것처럼 신원 증명을 위한 ‘에이전트 패스포트’, 자동화된 결제 구조를 위한 ‘x402 프로토콜 기능’이 핵심이다.

카이트 AI가 제시하는 비전은 당장 대규모 적용이 불가하다. 우리가 이야기하는 미래가 오지 않았기 때문이다. 하지만 모두가 동의하는 미래가 왔을 때 필요한 기술이라는 광범위한 설득력이 프로젝트를 현실성 있게 만들고 있다.

3. 현실성을 평가하는 세 가지 핵심 질문

세 개의 프로젝트 모두 시점은 다르지만, 이들이 공통적으로 보여준 것은 ‘현실성’ 이다.

같은 프로젝트를 두고도 평가는 엇갈린다. 누군가는 “실제 문제를 풀고 있다”고 보고, 또 다른 누군가는 “과대 포장에 불과하다”고 본다. 이 혼란을 줄이려면, 최소한 아래 세 가지 질문을 스스로에게 던져봐야 한다.

대다수 프로젝트가 장밋빛 미래를 내세우는 만큼, 이 질문들에 제대로 답하려면 상당한 시간과 노력이 필요하다. 거짓 정보를 걸러내는 일 자체가 쉽지 않기 때문이다. 그러나 위 세 항목에 자신 있게 답하지 못하는 프로젝트는, 단기적으로 가격이 뛸 수 있어도 다음 하락장이 오면 다시 역사의 뒤안길로 밀려날 가능성이 높다.

암호화폐 시장이 좋지 않다는 사실은 분명하다. 그렇다고 끝난 것은 아니다. 새로운 시도는 계속될 것이고, 우리는 그 시도가 어떤 의미를 갖는지 또렷하게 바라볼 필요가 있다.

지금 당신에게 필요한 것은 ‘현실성’이다.

🐯 More from Tiger Research

이번 리서치와 관련된 더 많은 자료를 읽어보세요.Disclaimer

이 보고서는 신뢰할 수 있는 자료를 바탕으로 작성되었습니다. 그러나 정보의 정확성, 완전성, 그리고 적합성을 명시적으로나 암시적으로 보증하지 않습니다. 당사는 본 보고서나 그 내용을 이용함에 따른 모든 손실에 대해 책임을 지지 않습니다. 이 보고서의 결론과 권고사항, 예상, 추정, 전망, 목표, 의견 및 관점은 작성 당시의 정보를 바탕으로 하며 예고 없이 변경될 수 있습니다. 또한 타인 및 타조직의 의견과 일치하지 않거나 반대될 수 있습니다. 이 보고서는 정보 제공의 목적으로 작성되었으며, 법률, 사업, 투자, 또는 세금에 관한 조언으로 간주되어서는 안 됩니다. 또한 증권이나 디지털 자산에 대한 언급은 설명을 위한 것일 뿐, 투자 권고나 투자 자문 서비스 제공을 제안하는 것이 아닙니다. 이 자료는 투자자나 잠재적 투자자를 대상으로 하지 않았습니다.

타이거리서치 리포트 이용 안내

타이거리서치는 리포트의 공정 사용을 지지합니다. 이는 공익적 목적으로 콘텐츠를 인용하되 상업적 가치에 영향을 주지 않는 범위에서의 넓은 사용을 허용하는 원칙입니다. 공정 사용 규칙에 따라, 리포트를 사전 허가 없이 사용할 수 있으나, 타이거리서치 리포트를 인용 시에는 1) 출처로 ‘타이거리서치’를 분명히 밝히고, 2) 타이거리서치 로고를 포함시켜야 합니다. 자료를 재구성하여 출판할 경우에는 별도의 협의가 요구됩니다. 사전 허가 없는 사용은 법적 조치를 초래할 수 있습니다.

]]>Key Takeaways

Crypto winters follow a sequence: major event → trust collapse → talent exodus

Past winters caused by internal problems; current rise and fall both driven by external factors; neither winter nor spring

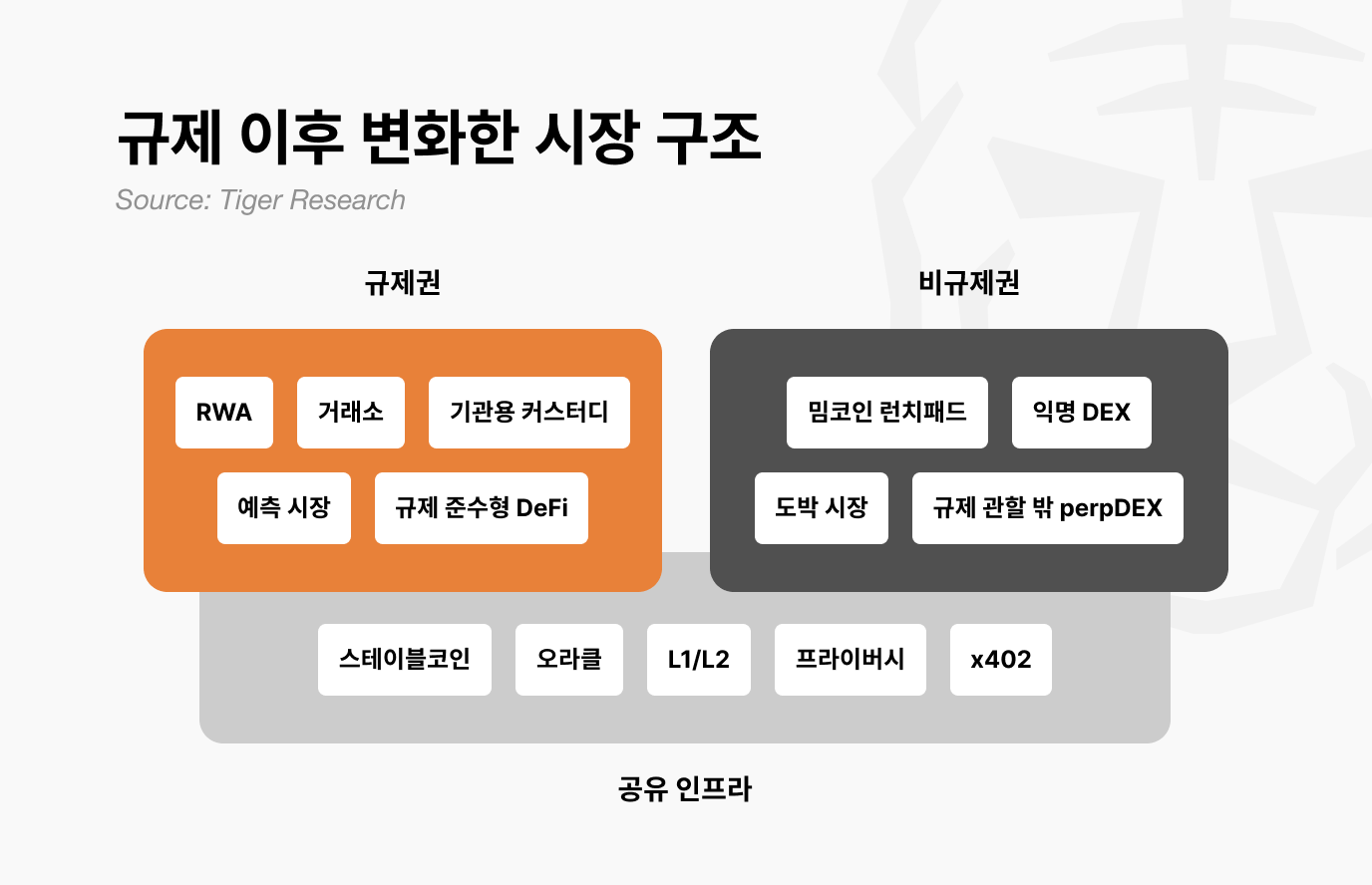

Post-regulation market split into three layers: regulated zone, unregulated zone, shared infrastructure; trickle-down effect gone

ETF capital stays in Bitcoin; does not flow outside regulated zone

Next bull run requires killer use case + supportive macro environment

1. How Did Previous Crypto Winters Unfold?

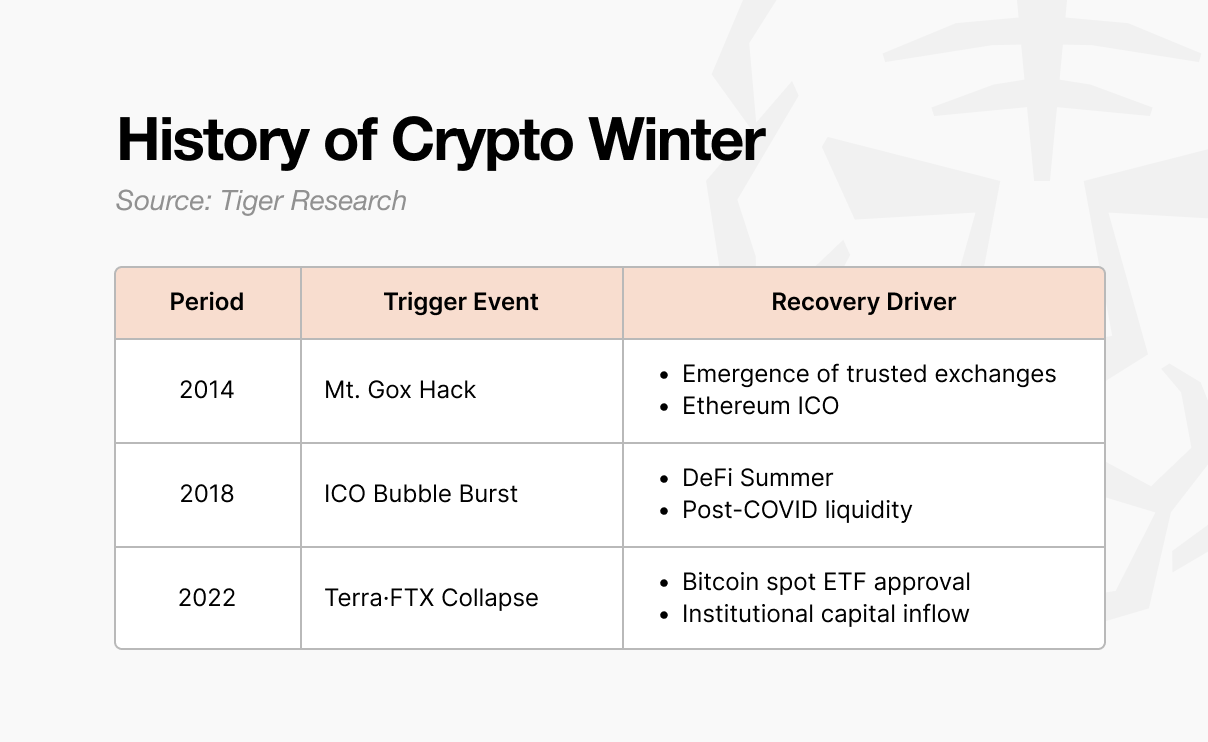

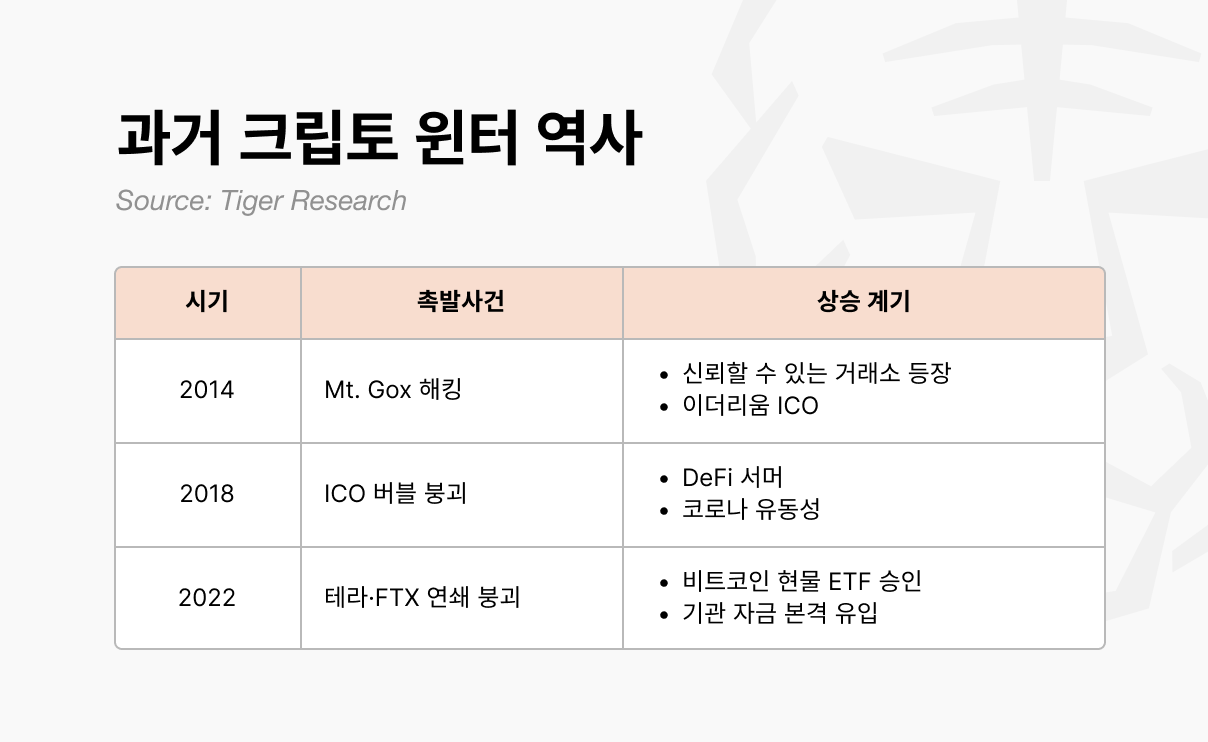

The first winter came in 2014. Mt. Gox was an exchange handling 70% of global Bitcoin trading volume at the time. Approximately 850,000 BTC vanished in a hack, and market trust collapsed. New exchanges with internal controls and audit functions emerged, and trust began to recover. Ethereum also entered the world through an ICO, opening new possibilities for vision and fundraising methods.

This ICO became the spark for the next bull market. When anyone could issue tokens and raise funds, the 2017 boom ignited. Projects raising tens of billions on a single whitepaper flooded in, but most had no substance.

In 2018, Korea, China, and the U.S. poured out regulations, the bubble burst, and the second winter arrived. This winter did not end until 2020. After COVID, liquidity flowed in, and DeFi protocols like Uniswap, Compound, and Aave gained attention, bringing capital back.

The third winter was the harshest. When Terra-Luna collapsed in 2022, Celsius, Three Arrows Capital, and FTX failed in succession. It was not a simple price drop; the industry’s structure itself was shaken. In January 2024, the U.S. SEC approved spot Bitcoin ETFs, followed by the Bitcoin halving and Trump’s pro-crypto policies, and capital began flowing in once again.

2. Crypto Winter Pattern: Major Event → Trust Collapse → Talent Exodus

All three winters followed the same sequence. A major event occurred, trust collapsed, and talent left.

It always started with a major event. The Mt. Gox hack, ICO regulations, and the Terra-Luna collapse followed by the FTX bankruptcy. The scale and form of each event differed, but the result was the same. The entire market fell into shock.

The shock soon spread into trust collapse. People who had been discussing what to build next began asking whether crypto was truly meaningful technology. The collaborative atmosphere among builders disappeared, and they began tearing into each other over who was to blame.

Doubt led to talent exodus. Builders who had been creating new momentum in blockchain fell into skepticism. In 2014, they left for fintech and big tech. In 2018, they left for institutions and AI. They departed for places that seemed more certain.

3. Is This a Crypto Winter?

The patterns from past crypto winters are visible today.

Major events:

Trump memecoin launch: market cap hit $27 billion in one day, then crashed 90%

10.10 liquidation event: U.S. announced 100% tariffs on China, triggering Binance’s largest-ever liquidation ($19 billion)

Trust collapse: Skepticism spreading in industry. Focus shifted from next build to blame games.

Talent exodus pressure: AI industry growing fast. Promises faster exits, greater wealth than crypto.

However, it is difficult to call this a crypto winter. Past winters erupted from within the industry. Mt. Gox was hacked, most ICO projects were revealed as scams, and FTX collapsed. The industry lost trust on its own.

Now is different.

ETF approval opened the bull market, and tariff policy and interest rates drove the decline. External factors lifted the market, and external factors brought it down.

Builders have not left either.

RWA, perpDEX, prediction markets, InfoFi, privacy. New narratives kept emerging, and they are still being created. They have not pulled up the entire market like DeFi once did, but they have not disappeared. The industry did not collapse; the external environment changed.

We did not create the spring, so there is no winter either.

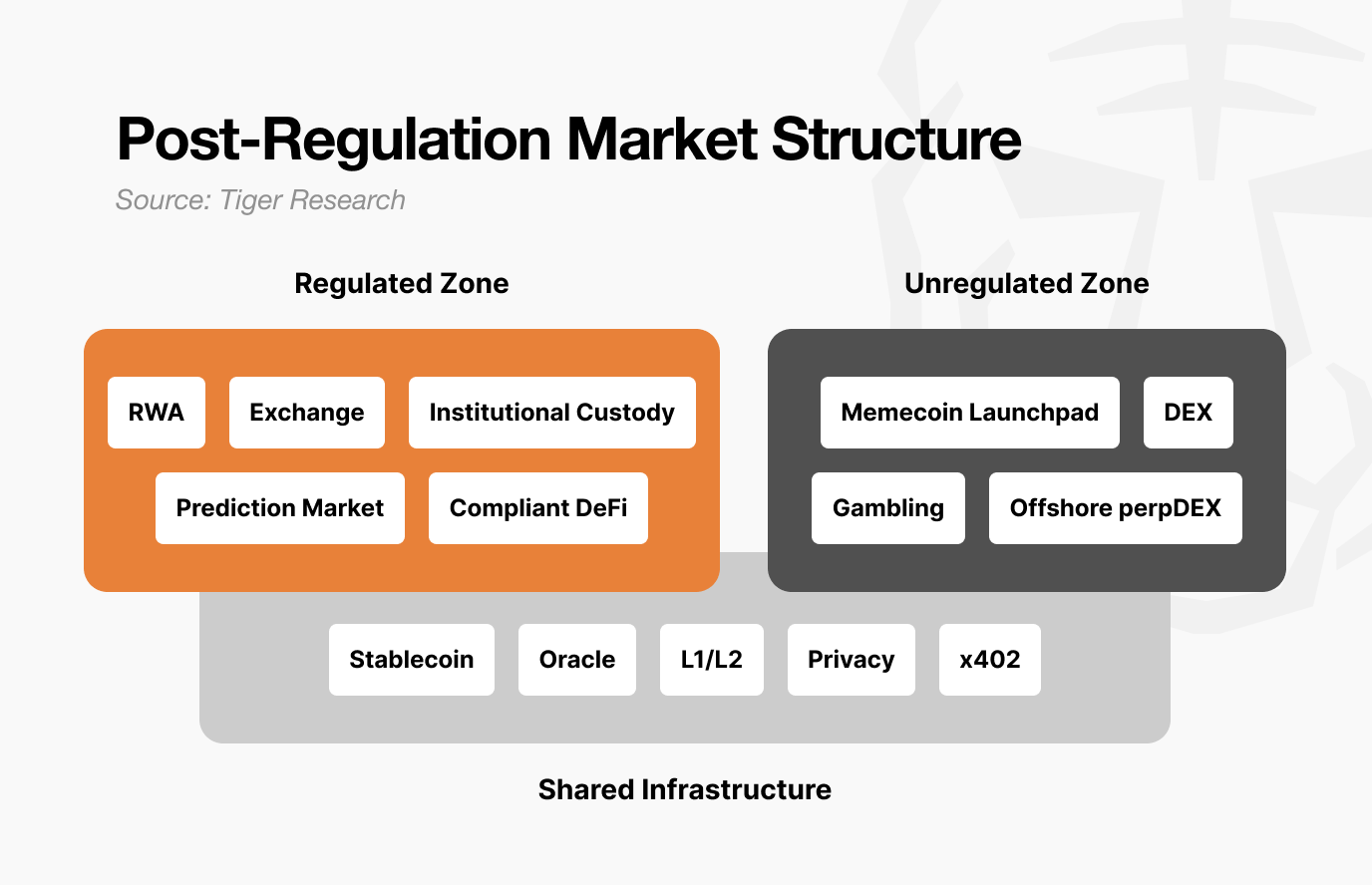

4. Post-Regulation Market Structure Changes

Behind this lies a significant shift in market structure following regulation. The market has already split into three layers: 1) regulated zone, 2) unregulated zone, and 3) shared infrastructure.

The regulated zone includes RWA tokenization, exchanges, institutional custody, prediction markets, and compliance-based DeFi. They undergo audits, make disclosures, and receive legal protection. Growth is slow, but capital scale is large and stable.

However, once inside the regulated zone, explosive gains like the past become difficult to expect. Volatility decreases and upside is capped. But downside is also capped.

The unregulated zone, on the other hand, will become more speculative going forward. Entry barriers are low and speed is fast. 100x in a day, -90% the next day happens more often.

However, this space is not meaningless. Industries born in the unregulated zone are creative, and once validated, they move into the regulated zone. DeFi did this, and prediction markets are doing so now. It serves as an experimental ground. But the unregulated zone itself will become increasingly separated from regulated zone businesses.

Shared infrastructure includes stablecoins and oracles. They are used in both the regulated and unregulated zones. The same USDC is used for institutional RWA payments and for Pump.fun trades. Oracles supply data for tokenized treasury verification and for anonymous DEX liquidations alike.

In other words, as the market split, capital flows also changed.

In the past, when Bitcoin rose, altcoins rose too through a trickle-down effect. Now it is different. Institutional capital that entered through ETFs stayed in Bitcoin, and it ended there. Regulated zone capital does not flow into the unregulated zone. Liquidity stayed only where value was proven. And even Bitcoin has not yet proven its value as a safe asset compared to risk assets.

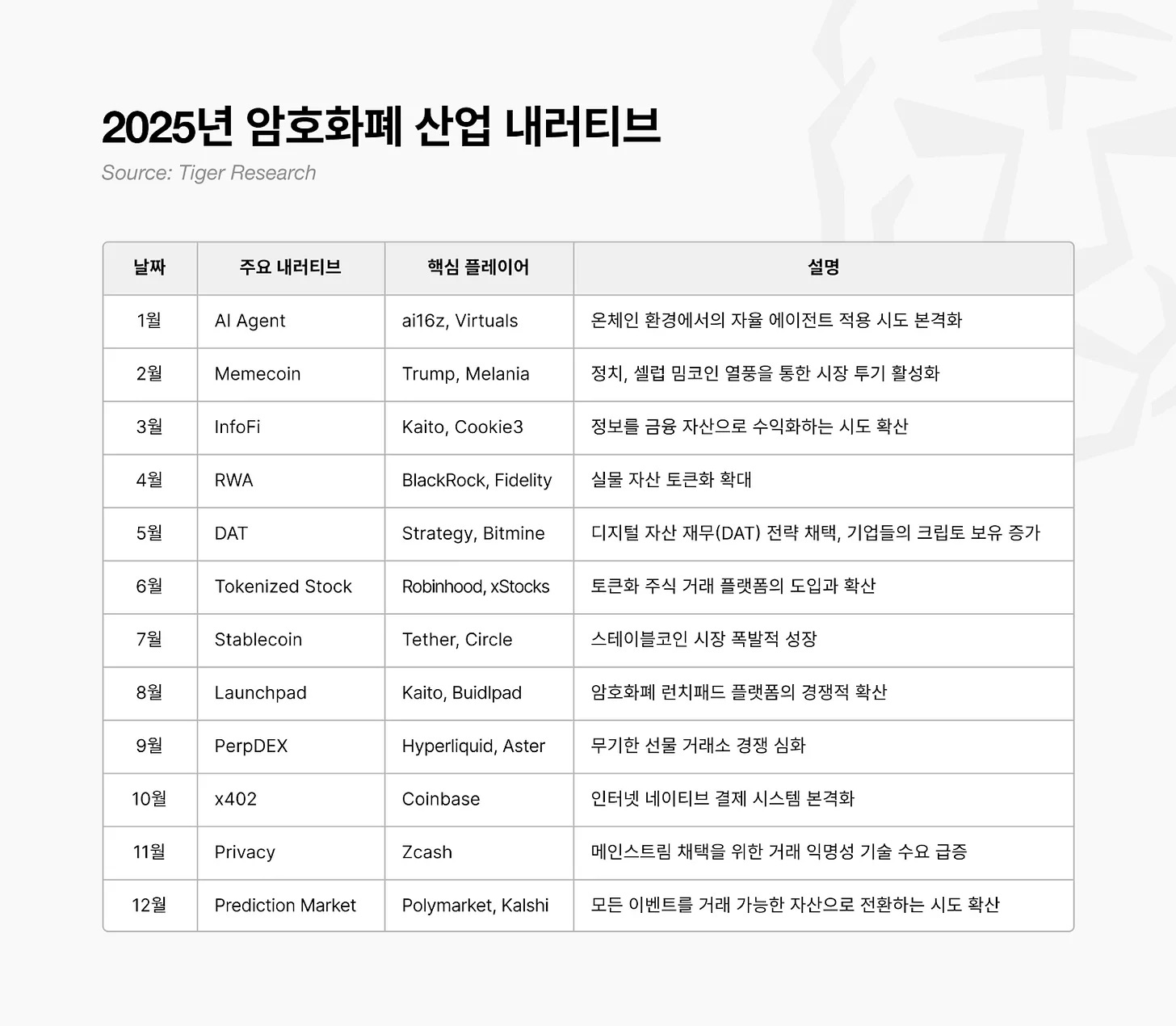

5. Conditions for the Next Bull Run

Regulation is already being sorted out. Builders are still building. Then two things remain.

First, a new killer use case must emerge from the unregulated zone. Something that creates value that did not exist before, like DeFi Summer in 2020. AI agents, InfoFi, and on-chain social are candidates, but they are not yet at a scale to move the entire market. The flow where experiments in the unregulated zone get validated and move into the regulated zone must be created again. DeFi did this, and prediction markets are doing so now.

Second, the macroeconomic environment. Even if regulation is sorted out, builders are building, and infrastructure is accumulating, the upside is limited if the macroeconomic environment does not support it. DeFi Summer in 2020 exploded as liquidity was released after COVID. The rise after ETF approval in 2024 also coincided with rate cut expectations. No matter how well the crypto industry performs, it cannot control interest rates and liquidity. For what the industry has built to gain persuasiveness, the macroeconomic environment must turn around.

A “crypto season” where everything rises together like the past is unlikely to come again. Because the market has split. The regulated zone grows steadily, and the unregulated zone rises big and falls big.

The next bull run will come. But it will not come for everyone.

🐯 More from Tiger Research

Read more reports related to this research.Disclaimer

This report has been prepared based on materials believed to be reliable. However, we do not expressly or impliedly warrant the accuracy, completeness, and suitability of the information. We disclaim any liability for any losses arising from the use of this report or its contents. The conclusions and recommendations in this report are based on information available at the time of preparation and are subject to change without notice. All projects, estimates, forecasts, objectives, opinions, and views expressed in this report are subject to change without notice and may differ from or be contrary to the opinions of others or other organizations.

This document is for informational purposes only and should not be considered legal, business, investment, or tax advice. Any references to securities or digital assets are for illustrative purposes only and do not constitute an investment recommendation or an offer to provide investment advisory services. This material is not directed at investors or potential investors.

Terms of Usage

Tiger Research allows the fair use of its reports. ‘Fair use’ is a principle that broadly permits the use of specific content for public interest purposes, as long as it doesn’t harm the commercial value of the material. If the use aligns with the purpose of fair use, the reports can be utilized without prior permission. However, when citing Tiger Research’s reports, it is mandatory to 1) clearly state ‘Tiger Research’ as the source, 2) include the Tiger Research logo. If the material is to be restructured and published, separate negotiations are required. Unauthorized use of the reports may result in legal action.

]]>Key Takeaways

크립토 윈터는 대형 사건, 신뢰 붕괴, 인재 이탈 순으로 찾아옴

과거 윈터는 업계 내부 문제로, 현재는 상승과 하락 모두 외부 요인이 주도해 윈터도 봄도 아님

규제 이후 시장은 규제권, 비규제권, 공유 인프라 세 층으로 나뉘며 과거처럼 비트코인이 오르면 알트까지 오르는 낙수효과 사라짐.

ETF 자금은 비트코인에 머물고 규제권 밖으로 안 흐름

다음 상승은 킬러 유스케이스와 거시경제 환경이 갖춰져야 올 것

1. 크립토 윈터는 어떻게 찾아왔는가?

첫 번째 겨울은 2014년에 왔다. Mt. Gox는 당시 전 세계 비트코인 거래량의 70%를 처리하던 거래소였다. 약 85만 BTC가 해킹으로 사라지면서 시장 신뢰가 무너졌다. 이후 내부 통제와 감사 기능을 갖춘 새 거래소들이 등장하며 신뢰를 회복하기 시작했다. 또한 이더리움이 ICO를 통해 세상에 나오며 새로운 비전과 자금 조달 방식의 가능성을 열었다.

이 ICO가 다음 불장의 불씨가 됐다. 누구나 토큰을 발행해 자금을 모을 수 있게 되면서 2017년 열풍이 불었다. 백서 하나로 수백억을 모으는 프로젝트가 쏟아졌지만 대부분 실체가 없었다. 2018년 한국, 중국, 미국이 규제를 쏟아내면서 거품이 꺼졌고, 두 번째 겨울이 찾아왔다. 이 겨울은 2020년이 되어서야 끝났다. 코로나 이후 유동성이 풀리고, 유니스왑, 컴파운드, 에이브 같은 디파이 프로토콜이 주목받으면서 자금이 다시 들어왔다.

세 번째 겨울은 가장 혹독했다. 2022년 테라-루나가 무너지자 셀시우스, 쓰리애로우스캐피탈, FTX가 연쇄 도산했다. 단순 가격 하락이 아니라 업계 구조 자체가 흔들렸다. 2024년 1월 미국 SEC가 비트코인 현물 ETF 승인, 비트코인 반감기와 트럼프의 친-크립토 정책이 이어지며 다시 한 번 자금이 쏠리기 시작했다.

2. 크립토 윈터의 패턴: 큰 사건 → 신뢰 붕괴 → 인재 이탈

세 번의 겨울은 모두 같은 순서로 찾아왔다. 대형 사건이 터지고, 신뢰가 무너지고, 인재가 떠났다.

시작은 항상 대형 사건이었다. Mt. Gox 해킹, ICO 규제, 테라-루나 붕괴와 FTX 파산. 사건의 규모와 형태는 달랐지만 결과는 같았다. 시장 전체가 충격에 빠진다.

충격은 곧 신뢰 붕괴로 번졌다. 다음에 뭘 만들지 이야기하던 사람들이 크립토가 진짜 의미 있는 기술인지 묻기 시작했다. 빌더들끼리 협력하던 분위기는 사라지고, 누가 문제였는지 서로 물어뜯었다.